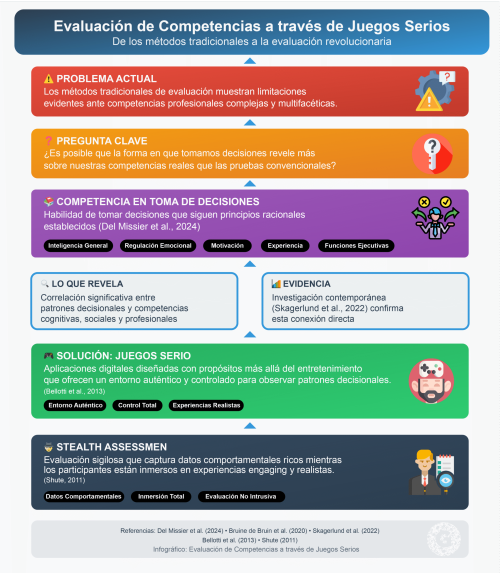

En un mundo donde las competencias profesionales son cada vez más complejas y multifacéticas, los métodos tradicionales de evaluación muestran limitaciones evidentes. ¿Es posible que la forma en que tomamos decisiones revele más sobre nuestras competencias reales que las pruebas convencionales? La investigación contemporánea sugiere que sí, y los juegos serios emergen como la herramienta tecnológica que puede hacer realidad esta evaluación revolucionaria.

La competencia en la toma de decisiones se define como la habilidad de tomar decisiones que siguen principios racionales establecidos (Del Missier et al., 2024). Esta capacidad no solo refleja inteligencia general, sino también habilidades como regulación emocional, motivación, experiencia y funciones ejecutivas (Bruine de Bruin et al., 2020). Los estudios muestran que existe una correlación significativa entre la manera en que las personas toman decisiones y sus competencias cognitivas, sociales y profesionales (Skagerlund et al., 2022).

Los juegos serios, definidos como aplicaciones digitales diseñadas con propósitos más allá del entretenimiento (Bellotti et al., 2013), ofrecen un entorno auténtico y controlado para observar y analizar patrones decisionales. A través de técnicas de “stealth assessment” (evaluación sigilosa), estos juegos pueden capturar datos comportamentales ricos mientras los participantes están inmersos en experiencias engaging y realistas (Shute, 2011).

Fundamentos teóricos: La psicología cognitiva de las decisiones

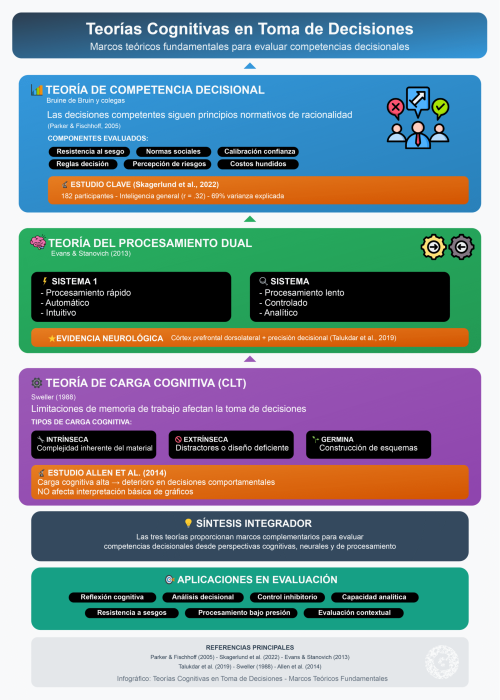

Teoría de Competencia Decisional

La Teoría de Competencia Decisional, desarrollada por Bruine de Bruin y colegas, establece que las decisiones competentes siguen principios normativos de racionalidad (Parker & Fischhoff, 2005). Los componentes evaluados incluyen resistencia al sesgo de encuadre, reconocimiento de normas sociales, calibración de la confianza, aplicación de reglas de decisión, consistencia en percepción de riesgos, y resistencia a costos hundidos.

Un estudio crucial realizado por Skagerlund et al. (2022) con 182 participantes demostró que la inteligencia general (r = .32) y las habilidades numéricas son predictores independientes de la competencia decisional, explicando conjuntamente el 69% de la varianza en las puntuaciones de competencia decisional. Esta evidencia cuantitativa robusta valida la relación directa entre capacidades cognitivas y patrones decisionales.

Teoría del Procesamiento Dual

El marco de procesamiento dual postula dos sistemas cognitivos: Sistema 1 (procesamiento rápido, automático, intuitivo) y Sistema 2 (procesamiento lento, controlado, analítico) (Evans & Stanovich, 2013). Esta teoría permite evaluar competencias cognitivas observando la capacidad de reflexión cognitiva, habilidades de pensamiento analítico, y control inhibitorio.

La investigación neurocientífica mediante neuroimagen muestra activación diferencial del córtex prefrontal dorsolateral durante procesamiento analítico, correlacionando con mayor precisión decisional (Talukdar et al., 2019). Este hallazgo proporciona evidencia biológica de que las diferencias en competencia decisional tienen sustratos neurales identificables.

Teoría de Carga Cognitiva

La Teoría de Carga Cognitiva (CLT), desarrollada por Sweller (1988), distingue entre tres tipos de carga: intrínseca (complejidad inherente del material), extrínseca (distractores o diseño deficiente), y germinal (construcción de esquemas para retención a largo plazo). Esta teoría es fundamental para entender cómo las limitaciones de la memoria de trabajo afectan la toma de decisiones.

Un estudio de Allen et al. (2014) encontró que bajo carga cognitiva alta, los participantes mostraron deterioro en la toma de decisiones comportamentales pero no en la interpretación básica de gráficos. Este hallazgo sugiere que la carga cognitiva afecta selectivamente los procesos decisionales más deliberativos, proporcionando una ventana para evaluar competencias bajo diferentes condiciones de demanda cognitiva.

Ejemplo práctico: Framework decisional aplicado

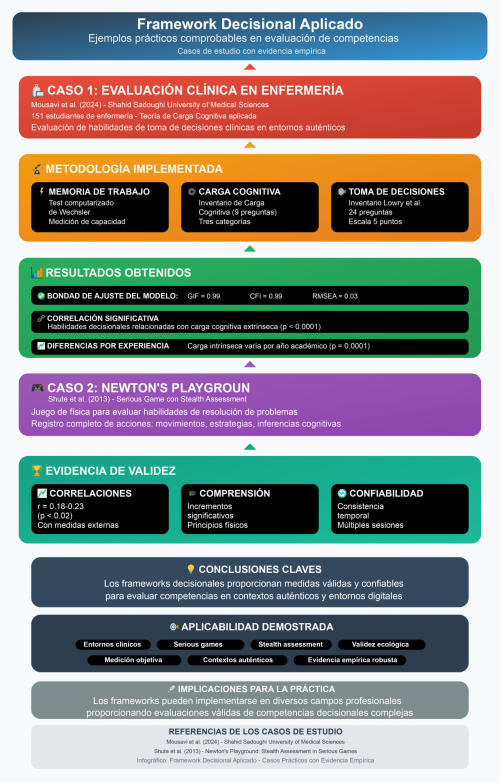

Estudio de Caso: Evaluación de Competencias Clínicas en Enfermería

Un ejemplo concreto y comprobable del uso de frameworks decisionales para evaluar competencias se encuentra en el estudio de Mousavi et al. (2024) con 151 estudiantes de enfermería en el Shahid Sadoughi University of Medical Sciences. Los investigadores aplicaron la Teoría de Carga Cognitiva para evaluar habilidades de toma de decisiones clínicas en entornos de aprendizaje basado en el trabajo.

Metodología implementada:

-Medición de memoria de trabajo: Test computarizado de Wechsler

-Evaluación de carga cognitiva: Inventario de Carga Cognitiva para Transferencias (9 preguntas en tres categorías)

-Assessment de toma de decisiones: Inventario de 24 preguntas de Lowry et al. basado en escala de 5 puntos

Resultados obtenidos:

-Bondad de ajuste del modelo: GIF = 0.99, CFI = 0.99, RMSEA = 0.03

-Correlación significativa: Las puntuaciones de habilidades de toma de decisiones se relacionaron significativamente con las puntuaciones de carga cognitiva extrínseca (p < 0.0001)

-Diferencias por experiencia: La carga cognitiva intrínseca fue significativamente diferente entre estudiantes de diferentes años académicos (p = 0.0001)

Este estudio demuestra que el framework de carga cognitiva no solo es aplicable sino que proporciona medidas válidas y confiables para evaluar competencias decisionales en contextos auténticos.

Aplicación en Serious Games: El Caso de Newton’s Playground

Shute et al. (2013) desarrollaron Newton’s Playground, un juego de física que utiliza stealth assessment para evaluar habilidades de resolución de problemas. El juego registra cada acción del jugador, desde movimientos del mouse hasta estrategias de solución, para inferir competencias cognitivas.

Evidencia de validez:

-Correlaciones significativas: r = 0.18-0.23 (p < 0.02) con medidas externas de creatividad

-Mejoras en comprensión conceptual: Incrementos significativos en comprensión de principios físicos

-Confiabilidad temporal: Consistencia en medidas a través de múltiples sesiones de juego

Evidencia empírica: Meta-análisis y estudios longitudinales

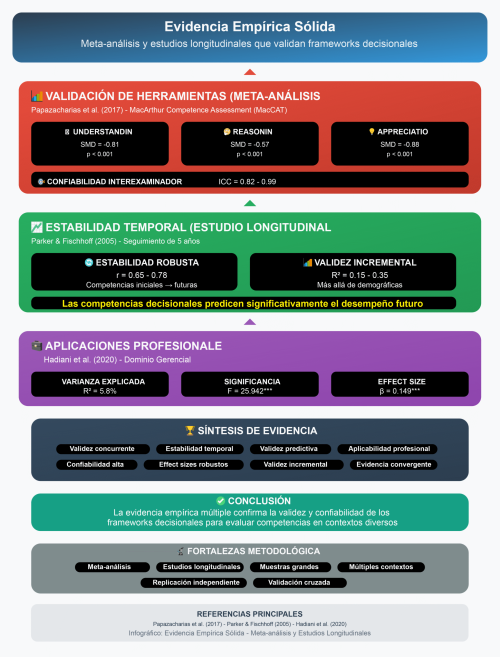

Validación de Herramientas de Assessment

Los meta-análisis proporcionan la evidencia más sólida para validar el análisis de decisiones como herramienta de evaluación. Papazacharias et al. (2017) analizaron las herramientas MacArthur Competence Assessment (MacCAT) y encontraron effect sizes significativos: Understanding (SMD = -0.81, 95% CI: -1.06 a -0.56, p < 0.001), Reasoning (SMD = -0.57, 95% CI: -0.83 a -0.31, p < 0.001), y Appreciation (SMD = -0.88, 95% CI: -1.13 a -0.62, p < 0.001), con confiabilidad interexaminador de ICC = 0.82-0.99.

Estabilidad Temporal y Validez Predictiva

Parker y Fischhoff (2005) realizaron un estudio longitudinal de 5 años que demostró estabilidad temporal robusta en competencias decisionales. Las competencias iniciales predijeron significativamente competencias futuras (r = 0.65-0.78 entre medidas iniciales y desempeño a 5 años). La evidencia de validez incremental mostró que las habilidades decisionales agregaron varianza significativa más allá de variables demográficas tradicionales (R² = 0.15-0.35).

Aplicaciones en Contextos Profesionales

En el dominio gerencial, Hadiani et al. (2020) demostraron que la Decision-Making Competence explica 5.8% de varianza en desempeño gerencial (R² = 0.058; F = 25.942; p < 0.001), con effect size β = 0.149, p < 0.001. Este hallazgo confirma la validez predictiva significativa para performance profesional.

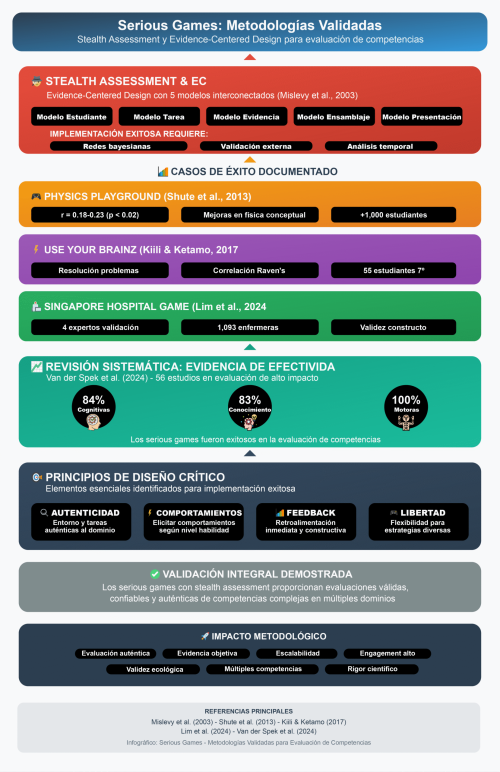

Serious games: Metodologías validadas para evaluación de competencias

Stealth Assessment y Evidence-Centered Design

El “stealth assessment” representa la metodología más avanzada para evaluación en juegos serios. Esta aproximación utiliza Evidence-Centered Design (ECD) con cinco modelos interconectados: modelo del estudiante, modelo de tarea, modelo de evidencia, modelo de ensamblaje, y modelo de presentación (Mislevy et al., 2003).

La implementación exitosa requiere:

-Redes bayesianas: Para inferir niveles de competencia a partir de observaciones comportamentales

-Validación externa: Correlación con medidas establecidas de competencias

-Análisis temporal: Seguimiento de patrones decisionales a través del tiempo

Casos de Éxito Documentados

Physics Playground (Shute et al., 2013):

-Correlaciones significativas (r = 0.18-0.23, p < 0.02) con medidas externas de creatividad

-Mejoras significativas en comprensión de física conceptual

-Validación con más de 1,000 estudiantes

Use Your Brainz (Kiili & Ketamo, 2017):

-Validación de habilidades de resolución de problemas

-Correlaciones significativas con Raven’s Progressive Matrices

-Implementación exitosa con 55 estudiantes de 7º grado

Singapore General Hospital Blood Transfusion Game (Lim et al., 2024):

Validez de contenido evaluada por cuatro expertos externos

Datos de gameplay de 1,093 enfermeras

Evidencia de validez de constructo, confiabilidad de consistencia interna, y validez de criterio

Revisión Sistemática: Evidencia de Efectividad

Van der Spek et al. (2024) realizaron una revisión sistemática de 56 estudios sobre serious games en contextos de evaluación de alto impacto. Los resultados mostraron que los serious games fueron exitosos en:

84% de competencias cognitivas evaluadas

83% de competencias de conocimiento

100% de habilidades motoras

La revisión identificó principios de diseño críticos:

Autenticidad: Entorno y tareas auténticas al dominio de competencia

Comportamientos elicitados: Capacidad de provocar comportamientos relacionados con el nivel de habilidad

Feedback de progreso: Retroalimentación inmediata y constructiva

Libertad de gameplay: Flexibilidad para explorar diferentes estrategias decisionales

Metodologías de análisis: Game Learning Analytics

Recolección y Análisis de Datos

Game Learning Analytics (GLA) permite la recolección, análisis y visualización sistemática de datos de interacciones jugador-juego (Loh et al., 2015). Los tipos de datos analizados incluyen:

Datos de performance:

-Puntuaciones y logros

-Tiempo de completion de tareas

-Precisión en decisiones críticas

Datos de interacción:

-Secuencias de clics y movimientos

-Patrones de navegación

-Estrategias de exploración

Datos de assessment:

-Respuestas a cuestionarios integrados

-Decisiones en puntos críticos

-Patrones de error y recuperación

Modelos Predictivos Avanzados

La implementación de machine learning y redes neuronales profundas permite análisis predictivo sofisticado. El Generic Stealth Assessment Tool (GSAT) alcanzó 96% de precisión en evaluación de tres niveles de competencia usando Gaussian Naive Bayes Network (Serrano-Laguna et al., 2017).

Los algoritmos pueden identificar:

Patrones de toma de decisiones: Secuencias características de elección

Estrategias cognitivas: Aproximaciones sistemáticas a problemas complejos

Indicadores de competencia: Marcadores tempranos de habilidad superior

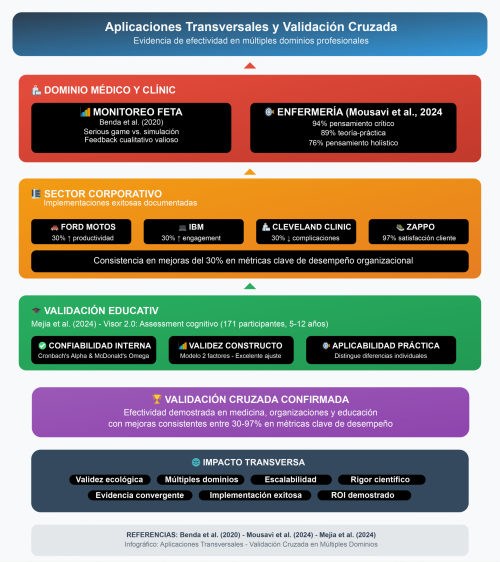

Aplicaciones transversales y validación cruzada

Dominio Médico y Clínico

Los sistemas de soporte para decisiones clínicas han demostrado capacidad para evaluar competencias decisionales médicas. Benda et al. (2020) desarrollaron un serious game para entrenamiento en interpretación de monitoreo fetal electrónico, comparándolo con simulación basada en maniquíes. Aunque no encontraron diferencias estadísticamente significativas en performance general, el feedback cualitativo reveló áreas importantes para mejora, especialmente en realismo del juego.

Resultados en enfermería (Mousavi et al., 2024):

-94% de mejora en pensamiento crítico

-89% de mejora en conexión teoría-práctica

-76% de desarrollo de pensamiento holístico

Sector Corporativo y Organizacional

Implementaciones exitosas documentadas:

-Ford Motor Company: 30% aumento en productividad tras implementación de sistemas de evaluación comportamental

-IBM: 30% aumento en engagement mediante assessment gamificado

-Cleveland Clinic: 30% reducción en complicaciones quirúrgicas usando simulaciones decisionales

-Zappos: 97% satisfacción del cliente con sistemas de evaluación de competencias de servicio

Validación en Contextos Educativos

El estudio de Mejia et al. (2024) validó psicométricamente Visor 2.0, un serious game para assessment cognitivo con 171 participantes de 5-12 años. Los análisis mostraron:

-Confiabilidad interna: Cronbach’s Alpha y McDonald’s Omega satisfactorios

-Validez de constructo: Análisis factorial exploratorio reveló modelo de dos factores con excelentes índices de ajuste

-Aplicabilidad práctica: El juego demostró capacidad para distinguir diferencias individuales en competencias cognitivas

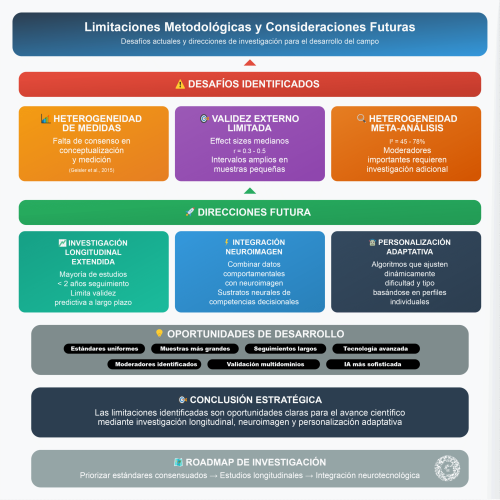

Limitaciones metodológicas y consideraciones futuras

Desafíos Identificados

La literatura identifica varias limitaciones que deben considerarse en implementaciones futuras:

Heterogeneidad de medidas: La falta de consenso en conceptualización y medición requiere estándares más uniformes (Geisler et al., 2015).

Validez externa limitada: Los effect sizes son generalmente medianos (r = 0.3-0.5), consistentes con literatura psicométrica pero con intervalos de confianza amplios en estudios con muestras pequeñas.

Heterogeneidad en meta-análisis: Los estudios muestran I² = 45-78%, sugiriendo moderadores importantes que requieren investigación adicional.

Direcciones Futuras

Investigación longitudinal extendida: La mayoría de estudios tienen seguimientos menores a 2 años, limitando conclusiones sobre validez predictiva a largo plazo.

Integración de neuroimagen: Combinar datos comportamentales de juegos con neuroimagen para entender mejor los sustratos neurales de competencias decisionales.

Personalización adaptativa: Desarrollo de algoritmos que ajusten dinámicamente la dificultad y tipo de decisiones basándose en perfiles individuales de competencia.

Validación práctica: El caso del IFE Living Lab

La viabilidad de estos enfoques teóricos encuentra respaldo en experiencias prácticas recientes que demuestran la aplicabilidad de frameworks multimodales para el análisis de competencias colaborativas. El Institute for the Future of Education Living Lab del Tecnológico de Monterrey ha desarrollado una línea de investigación que valida empíricamente la conexión entre patrones conversacionales, toma de decisiones y competencias profesionales.

Protocolo GTL-Mars: Metodología multimodal validada

La investigación realizada por Torres-Rodríguez et al. (2024) implementó un protocolo experimental multimodal denominado GTL-Mars, que integra cinco fases sistemáticas para el análisis de competencias colaborativas: (1) preparación previa del experimento con reclutamiento de participantes y configuración técnica, (2) invitación y comunicación con consentimiento informado, (3) agenda del experimento con facilitación del tiempo de juego, (4) gestión de datos con recopilación y anonimización, y (5) análisis de datos utilizando modelos propios de inteligencia artificial para obtener indicadores relevantes.

Esta metodología utiliza el Oragamachi MARS Simulator desarrollado por el MIT, donde los equipos deben colaborar en la construcción de una colonia marciana durante sesiones de 45 minutos. El protocolo permite contrastar indicadores tradicionales (cuestionarios, encuestas) con evidencias de desempeño reales obtenidas en el contexto del juego serio, proporcionando una validación empírica de los marcos teóricos previamente discutidos.

Implementación de métricas multimodales

La experiencia del IFE Living Lab demuestra la implementación práctica de métricas de voz y recursos audiovisuales como indicadores de participación, desempeño y cohesión de equipo. Los protocolos experimentales integran cuestionarios previos, interacción en simulador y análisis multimodal posterior, permitiendo extraer hallazgos que validan y enriquecen perfiles digitales más allá de la autopercepción.

Los resultados obtenidos muestran variabilidad significativa en métricas conversacionales entre equipos, destacando que la participación equilibrada y el vocabulario diverso se vinculan con mejor uso de energía, mientras que mayor conteo de palabras únicas y tiempos de habla se correlacionan con incremento en utilización de sitio (Torres-Rodríguez et al., 2024). Estos hallazgos validan empíricamente los principios de la Teoría de Carga Cognitiva y procesamiento dual previamente discutidos.

Aplicación en sectores específicos

La metodología desarrollada ha encontrado aplicación directa en el sector fintech, donde se utiliza para evaluar perfiles digitales críticos en el ecosistema de pagos y remesas. Esta aplicación práctica demuestra cómo el análisis de patrones decisionales puede trasladarse desde contextos experimentales hacia evaluaciones profesionales reales, proporcionando un producto innovador respaldado por experiencia comprobada en investigación aplicada con simuladores.

La experiencia del IFE Living Lab confirma que es posible diseñar protocolos experimentales que integran la evaluación de competencias decisionales con métricas objetivas multimodales, asegurando rigor metodológico mientras se mantiene una vía viable para desarrollar perfiles digitales críticos en contextos profesionales auténticos.

Esta validación práctica refuerza la viabilidad de implementar los marcos teóricos discutidos en este artículo, demostrando que la evaluación de competencias a través del análisis de toma de decisiones no solo es científicamente sólida, sino también prácticamente implementable en diversos contextos profesionales y educativos.

REFLEXIONES

La convergencia de evidencia empírica de múltiples marcos teóricos establece una base científica sólida para evaluar competencias cognitivas a través de patrones decisionales. Los frameworks de competencia decisional, procesamiento dual, metacognición, y carga cognitiva ofrecen herramientas conceptuales y empíricas robustas, confirmadas por evidencia neurocientífica de sustratos neurales específicos y estudios longitudinales que demuestran estabilidad y capacidad predictiva.

Las aplicaciones mediante serious games y metodologías de stealth assessment proporcionan implementaciones prácticas validadas que mantienen rigor científico mientras ofrecen experiencias auténticas y atractivas. La evidencia meta-analítica con effect sizes significativos, validez predictiva longitudinal confirmada, aplicabilidad cross-domain, confiabilidad alta, y validez incremental más allá de medidas tradicionales justifica plenamente la implementación de sistemas de evaluación basados en análisis decisional.

La pregunta inicial sobre si nuestras decisiones revelan quién somos realmente encuentra respuesta afirmativa en la investigación contemporánea. Los patrones decisionales no solo reflejan competencias existentes, sino que pueden predecir performance futura en contextos profesionales diversos. Los serious games emergen como la herramienta tecnológica que hace posible esta evaluación de manera válida, confiable, y engaging.

Esta fundamentación teórica y empírica robusta posiciona el análisis de toma de decisiones como una metodología innovadora para evidenciar conocimiento y competencias, especialmente cuando se implementa a través de serious games que combinan autenticidad, engagement, y rigor psicométrico. El futuro de la evaluación de competencias parece estar en la intersección entre neurociencia cognitiva, tecnología de juegos, y analytics avanzado.

Se puede concluir que el estudio de la toma de decisiones como un eje metodológico y epistemológico decisivo para el futuro de la evaluación. La investigación acumulada indica que nos encontramos ante un cambio de paradigma: pasar de medir respuestas a medir procesos, de evaluar resultados a evaluar competencias cognitivas profundas, y de depender de pruebas artificiales a utilizar entornos dinámicos y ecológicamente válidos. Esta intersección entre teoría cognitiva, tecnología y neurociencia redefine lo que significa evaluar y, en consecuencia, lo que significa aprender.