El presente artículo introduce el concepto de “Confort Artificial” como marco analítico para comprender el uso no mediatizado de la Inteligencia Artificial (IA) y sus efectos en el desarrollo cognitivo humano. Se argumenta que, mientras los usuarios creen estar avanzando y aprendiendo mediante el uso de herramientas de IA, en realidad permanecen atrapados en un estado de comodidad pasiva que inhibe la transformación real. A través de una revisión de literatura reciente y análisis semiótico, se examina cómo la dependencia de la IA genera una ilusión de crecimiento mientras simultáneamente convierte al usuario en recurso del sistema que cree dominar.

La Paradoja del Avance Tecnológico

Vivimos en una época donde la Inteligencia Artificial promete revolucionar cada aspecto de nuestra existencia, desde la educación hasta el trabajo creativo. Sin embargo, bajo esta promesa de empoderamiento tecnológico subyace una paradoja inquietante: mientras creemos utilizar estas herramientas para expandir nuestras capacidades, podríamos estar experimentando lo que denomino “Confort Artificial” – un estado de dependencia tecnológica que simula progreso mientras mantiene al sujeto en una pasividad cognitiva profunda.

Este concepto surge de la observación de un fenómeno cada vez más prevalente: usuarios que, creyendo dominar herramientas de IA para aprender, crear y desarrollarse, en realidad permanecen en un bucle de consumo pasivo que inhibe las mismas capacidades que pretenden potenciar. Como señala Gerlich (2025), existe una correlación negativa significativa entre el uso frecuente de herramientas de IA y las habilidades de pensamiento crítico, mediada por un incremento en la descarga cognitiva (cognitive offloading).

El Confort Artificial: Anatomía de una Ilusión

Definición y Dimensiones Conceptuales

El Confort Artificial puede definirse como la ilusión de crecimiento y avance generada por una mediación tecnológica, que mantiene al sujeto en un estado de comodidad pasiva, inhibiendo su transformación real, mientras simultáneamente lo convierte en recurso para el propio sistema. Esta definición se alinea con las observaciones de Li (2024), quien documenta cómo la sobre-dependencia de sistemas de diálogo con IA conduce a errores en el desempeño de tareas debido a la aceptación acrítica de recomendaciones generadas por algoritmos.

La dimensión semántica del concepto revela una tensión fundamental: el “confort” implica ausencia de fricción y desafío, mientras lo “artificial” remite a lo fabricado, lo no-natural. Juntas, estas palabras generan un oxímoron productivo: una comodidad que no surge de un proceso orgánico de desarrollo, sino que es inducida externamente por sistemas tecnológicos.

La Arquitectura de la Dependencia

Zhang et al. (2024) identifican la dependencia de IA como “una excesiva confianza en tecnologías y aplicaciones de IA en varios aspectos de la vida, incluyendo estudios académicos, rutinas diarias e interacciones sociales” (p. 5). Esta dependencia no es meramente instrumental; constituye una reconfiguración fundamental de nuestros procesos cognitivos.

El trabajo de Dergaa et al. (2024) sobre los efectos cognitivos de los chatbots de IA revela que, mientras los usuarios perciben estos sistemas como extensiones de sus propias capacidades, en realidad están experimentando una forma de alienación cognitiva similar a la descrita por teóricos críticos en otros contextos. Los autores advierten que “la naturaleza inmediata y conversacional de los AIC puede fomentar un sentido más profundo de confianza y dependencia en los usuarios, potencialmente influenciando los procesos cognitivos de manera diferente a las fuentes tradicionales de búsqueda” (p. 3).

La Erosión del Pensamiento Profundo

De la Reflexión a la Reacción

El fenómeno del Confort Artificial se manifiesta de manera particularmente aguda en la pérdida de capacidad para el pensamiento profundo y sostenido. Carr (2010), en su obra seminal The Shallows, ya advertía sobre cómo Internet estaba reconfigurando nuestros cerebros hacia un procesamiento superficial de información. La IA generativa amplifica exponencialmente este efecto.

Newport (2016) define el trabajo profundo como “actividades profesionales realizadas en un estado de concentración libre de distracciones que empujan las capacidades cognitivas a su límite” (p. 3). Sin embargo, el Confort Artificial erosiona precisamente esta capacidad. Como documenta el estudio de Gerlich (2025), los participantes más jóvenes (17-25 años) mostraron mayor dependencia de herramientas de IA y puntuaciones más bajas en pensamiento crítico comparados con grupos de mayor edad.

La Sociedad Paliativa Digital

Byung-Chul Han (2021) introduce el concepto de “sociedad paliativa” para describir una cultura que evita sistemáticamente el dolor, la fricción y el desafío. En el contexto del Confort Artificial, la IA funciona como el analgésico definitivo contra la incomodidad del aprendizaje genuino. Han argumenta que “en una sociedad de la positividad, el dolor como pura negatividad no tiene lugar” (The Palliative Society, p. 12).

Esta aversión al esfuerzo cognitivo se traduce en lo que Han (2015) denomina “la sociedad del cansancio” (The Burnout Society), donde la autoexplotación reemplaza a la explotación externa. El Confort Artificial representa una evolución perversa de este fenómeno: ya no nos autoexplotamos activamente, sino que delegamos incluso esa función a sistemas automatizados.

El Usuario como Recurso: La Inversión del Poder

Capitalismo de Vigilancia y Extracción de Valor

Shoshana Zuboff (2019) acuñó el término “capitalismo de vigilancia” para describir cómo las corporaciones tecnológicas extraen valor de los datos comportamentales humanos. En su análisis, Zuboff define este fenómeno como “la reclamación unilateral de la experiencia humana privada como materia prima gratuita para su traducción en datos comportamentales” (The Age of Surveillance Capitalism, p. 8).

El Confort Artificial opera dentro de esta lógica extractiva. Mientras los usuarios creen estar utilizando herramientas de IA para su beneficio, en realidad están alimentando sistemas que los convierten en “recursos para el propio sistema” (Zuboff, 2019, p. 94). Cada interacción, cada consulta, cada corrección contribuye al refinamiento de algoritmos que, paradójicamente, profundizan la dependencia del usuario.

La Vida “Onlife” y la Disolución de Fronteras

Luciano Floridi (2014) propone el concepto de “onlife” para describir la experiencia seamless entre lo online y offline en la era de la infosfera. En The Fourth Revolution, Floridi argumenta que estamos experimentando una cuarta revolución (después de Copérnico, Darwin y Freud) que redefine fundamentalmente qué significa ser humano.

El Confort Artificial prospera en este ambiente “onlife”, donde las distinciones entre pensamiento propio y asistido por máquina se vuelven borrosas. Floridi (2014) advierte que “las personas que adoptamos en las redes sociales, por ejemplo, alimentan nuestras vidas ‘reales’ de modo que comenzamos a vivir ‘onlife'” (p. 43). Esta fusión no es neutral; facilita la colonización del espacio cognitivo por lógicas algorítmicas.

Implicaciones Educativas y Cognitivas

El Colapso del Aprendizaje Significativo

Un estudio sistemático de Li (2024) sobre los efectos de la sobre-dependencia de sistemas de diálogo con IA en las capacidades cognitivas de los estudiantes revela patrones alarmantes. La investigación documenta cómo “con el rápido avance de los sistemas de diálogo con IA, el panorama de la investigación y la educación ha sido significativamente transformado” (p. 2), pero esta transformación no necesariamente implica mejora.

Los hallazgos más preocupantes incluyen:

– Erosión del pensamiento crítico: Los estudiantes que dependen excesivamente de IA muestran capacidades disminuidas para evaluar críticamente información (Li, 2024).

– Pérdida de autonomía intelectual: La delegación sistemática de tareas cognitivas resulta en una atrofia de habilidades fundamentales (Morales-García et al., 2024).

– Ilusión de competencia: Los usuarios desarrollan una falsa sensación de dominio mientras sus habilidades reales se deterioran (Zhang et al., 2024).

La Paradoja de la Eficiencia

El Confort Artificial promete eficiencia, pero entrega dependencia. Como señalan estudios recientes, “mientras la descarga cognitiva puede mejorar la eficiencia y reducir la tensión mental, también afecta el desarrollo cognitivo y el pensamiento crítico” (Gerlich, 2025, p. 7). Esta paradoja revela la naturaleza engañosa del confort tecnológico: lo que parece una ganancia inmediata en productividad se traduce en una pérdida a largo plazo de capacidades fundamentales.

Oportunidades y Alternativas

No se trata de estigmatizar la red y las tecnologías, sino de fortalecer las habilidades que nos permitan mediar críticamente en una sociedad digitalizada. Como afirmaba Tim Berners-Lee, “La web es más una creación social que técnica”. Los planteamientos anteriores muestran un cierto catastrofismo derivado de la visión de la tecnología como “no neutra”; sin embargo, la verdadera neutralidad no reside en los artefactos, sino en la conciencia que tenemos de su funcionamiento.

En este sentido, las competencias digitales, tradicionalmente reducidas a destrezas técnicas, requieren ser comprendidas desde su complejidad. Basta recordar cómo se enseñaba ofimática en los años noventa: centrada en los menús de la aplicación más que en el valor creativo de lo que podíamos construir con esas herramientas. Quienes lograron ver más allá de la instrucción superficial —ya fuera en asignaturas de TIC o en capacitaciones laborales— alcanzaron un beneficio concreto en su especialización.

El contrapunto real radica en la conciencia de un uso intencionado de la tecnología: uno que busque maximizar beneficios y disminuir riesgos, generando valor individual con impacto colectivo. En esa dirección se orienta el constructo al que alude Berners-Lee.

Hacia una Mediación Crítica

Resistir el Confort Artificial no implica rechazar la tecnología, sino desarrollar una relación crítica y consciente con ella. Newport (2016) propone el concepto de “minimalismo digital” como estrategia para recuperar la agencia en nuestra relación con la tecnología. Esto implica:

-Períodos de desconexión deliberada: Crear espacios temporales libres de mediación algorítmica.

-Fricción productiva: Buscar activamente desafíos cognitivos que requieran esfuerzo sostenido.

-Reflexión metacognitiva: Desarrollar conciencia sobre nuestros propios procesos de pensamiento y su relación con las herramientas digitales.

El Valor del Pensamiento Lento

En contraposición a la inmediatez del Confort Artificial, diversos autores proponen la recuperación del “pensamiento lento” (Kahneman, 2011). Esta modalidad cognitiva, caracterizada por el procesamiento deliberado y reflexivo, constituye un antídoto contra la superficialidad inducida por la IA.

Han (2022) argumenta que “necesitamos desarrollar una nueva cultura de la atención que valore la contemplación sobre el consumo, la profundidad sobre la velocidad” (The Crisis of Narration, p. 87). Esta revalorización del tiempo cognitivo representa una forma de resistencia contra la lógica extractiva del Confort Artificial.

El Despertar del Sueño Algorítmico

El Confort Artificial representa uno de los desafíos más sutiles y penetrantes de nuestra era. A diferencia de formas anteriores de alienación tecnológica, opera mediante la seducción antes que la coerción, prometiendo empoderamiento mientras entrega dependencia.

Los estudios recientes confirman lo que la intuición crítica sugería: el uso no mediado de IA está generando una crisis cognitiva sin precedentes. Como documenta Gerlich (2025), “es esencial fomentar la conciencia sobre las implicaciones cognitivas de la IA” (p. 15). Sin embargo, la conciencia por sí sola no es suficiente; se requiere una reorganización fundamental de nuestras prácticas educativas, laborales y sociales.

El concepto de Confort Artificial nos invita a cuestionar no solo cómo usamos la tecnología, sino cómo la tecnología nos usa a nosotros. En última instancia, la pregunta no es si podemos vivir sin IA – claramente, ese tren ya partió – sino si podemos mantener nuestra autonomía cognitiva y capacidad crítica en un mundo cada vez más mediado por algoritmos.

La respuesta a esta pregunta determinará si el futuro de la humanidad será uno de genuino progreso o de estancamiento disfrazado de avance. El Confort Artificial es, en este sentido, tanto un diagnóstico como una advertencia: el precio de la comodidad tecnológica podría ser nada menos que nuestra capacidad de pensar, crear y transformarnos genuinamente.

Como sociedad, enfrentamos una elección fundamental: aceptar el confort que nos domestica o abrazar la incomodidad que nos libera. Solo en el roce con lo difícil, en la fricción con lo incierto, puede nacer un avance real. El despertar del sueño algorítmico comienza con el reconocimiento de que el verdadero progreso nunca es cómodo, y que toda comodidad artificial es, en última instancia, una forma sofisticada de parálisis.

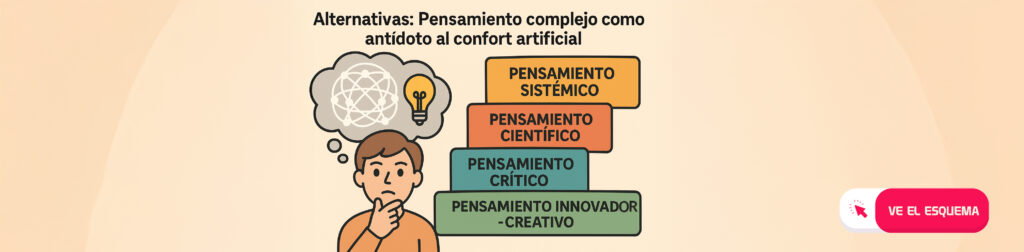

Alternativas: Pensamiento complejo como antídoto al confort artificial

Las investigaciones recientes confirman que el llamado fortalecimiento del “pensamiento crítico” no basta como salida al Confort Artificial. Reducir la complejidad a una sola dimensión es un error recurrente: el pensamiento crítico es necesario, pero forma parte de un entramado mayor. Como señala Morin (1990), el pensamiento complejo integra múltiples dimensiones: pensamiento sistémico, científico, crítico e innovador-creativo. No están separados, sino que se contienen unos a otros, configurando un enfoque capaz de atender la incertidumbre y la fricción cognitiva que el confort artificial nos priva de experimentar.

En este marco, el antídoto no está en la comodidad de respuestas inmediatas, sino en la reconstrucción intencional de nuestra capacidad de enfrentar problemas desde la complejidad: analizar interacciones y contextos (pensamiento sistémico), cuestionar con base en evidencia (pensamiento científico), discernir y argumentar (pensamiento crítico) y generar soluciones originales (pensamiento innovador-creativo). Este conjunto devuelve a la experiencia humana la densidad reflexiva que evita caer en la pasividad tecnológica.

Un camino complementario está en las denominadas competencias silver de los usuarios analógicos-digitales, que han debido “aprender a aprender” en transiciones sucesivas hacia lo digital. Sus prácticas de resiliencia, paciencia cognitiva y aprendizaje autónomo ofrecen un puente estratégico intergeneracional.

Tal como se desarrolla en Grezan (2025), estas competencias constituyen un legado que debe transmitirse a las nuevas generaciones para sostener el control sobre la máquina y no entregarlo a la comodidad algorítmica. (El lector interesado puede profundizar en este tema en: Competencias Silver en la Era de la IA: El Aprender a Aprender como Puente Estratégico).

Finalmente, la formación estructurada en pensamiento complejo comienza a tomar forma en propuestas como la metodología SEL4C, que desde la educación superior busca deliberadamente desafiar a los estudiantes en estas cuatro dimensiones cognitivas (Ramírez-Montoya et al., 2023). Aunque su énfasis incluye el emprendimiento social, lo que resulta relevante aquí es su evidencia de que el pensamiento complejo puede ser entrenado y fortalecido, ofreciendo una vía práctica para contrarrestar la parálisis del confort artificial.

Reflexión sobre el Confort Artificial

El arte, como expresión eminentemente humana, conecta nuestras emociones y sentidos en su totalidad, y viene en nuestro rescate. La poesía de Charly García nos recuerda la “inocencia artificial” que adormece nuestra condición frente al desarrollo humano, mientras Matt Bellamy de Muse advierte que estamos “enjaulados en simulaciones” que nos vuelven obsoletos. No se trata de una lucha contra las máquinas, sino de un despertar humano ante una herencia de sobreprotección, de generaciones intolerantes a la frustración y adictas a la inmediatez. Solo al valorar la fricción cognitiva como catalizador del aprendizaje podremos mediatizar conscientemente a las máquinas que nos acompañan. La verdadera libertad no reside en rechazar la tecnología, sino en la capacidad de elegir: saber cuándo desenchufarla y cuándo encenderla. Ese, como diría Maturana, es el acto liberador más humano y el más precioso tesoro de nuestra especie.