Conferencia “AI and the Future of Higher Education”

IFE Conference 2026, Tecnológico de Monterrey

27 de enero de 2026

Resumen

El 27 de enero de 2026, George Siemens—creador del conectivismo en 2004 y actualmente Chief AI Officer en Southern New Hampshire University—presentó en el IFE Conference del Tecnológico de Monterrey una visión donde la innovación educativa universitaria no reside en los modelos fundacionales de IA, sino en la capa de agentes, memoria y analítica situada. Este artículo rescata íntegramente su conferencia “AI and the Future of Higher Education”, contextualizándola en su trayectoria intelectual desde el conectivismo hasta su trabajo actual en sistemas agentivos. Siemens argumenta que las universidades enfrentan una encrucijada crítica: o construyen capacidades propias en arquitecturas de agentes educativos, o ceden el control de la experiencia de aprendizaje a plataformas comerciales. La charla articula conceptos técnicos emergentes—LLM OS, context engineering, arquitecturas multi-agente, sistemas de memoria tricapa—y los traduce a implicaciones concretas para el diseño educativo. Más allá de prescripciones técnicas, Siemens plantea interrogantes fundamentales sobre el futuro del conocimiento, el rol docente y la naturaleza misma de la cognición en ecosistemas humano-IA.

Palabras clave: Agentes de IA, conectivismo, educación superior, context engineering, learning analytics, sistemas multi-agente, George Siemens

George Siemens: Evolución Conceptual

IFE Conference 2026 • 27 enero

La encrucijada institucional

Las universidades deben elegir: construir capacidades propias en arquitecturas agentivas o ceder control de la experiencia de aprendizaje a plataformas comerciales.

No se trata de “adoptar IA”. Se trata de decidir quién controla la infraestructura cognitiva de tu institución: ¿tu equipo o proveedores externos?

2004

Conectivismo

2026

Arquitectura Agentiva

Tesis Central (2026)

La innovación educativa NO reside en los modelos fundacionales de IA, sino en la CAPA de agentes, memoria y analítica situada.

Las universidades que construyan capacidades en la capa de orquestación agentiva (no solo en comprar acceso a GPT/Claude) mantendrán control sobre su futuro educativo.

Conceptos clave

LLM OS

Sistema operativo emergente donde el LLM funciona como kernel coordinando herramientas (navegador, código, terminal), con la ventana de contexto como RAM y embeddings como filesystem.

¿Qué significa para diseño curricular? Los LLMs no son apps educativas sino infraestructura básica. Las decisiones sobre arquitectura de agentes son decisiones sobre el funcionamiento del aprendizaje institucional.

Context Engineering

Disciplina de diseñar sistemas dinámicos que proveen información y herramientas correctas, en formato correcto, en momento correcto. Incluye: prompts, memoria, RAG, tools, output estructurado.

¿Cómo cambia el rol docente? De diseñar contenidos secuenciados a orquestar flujos de información. De crear evaluaciones sumativas a diseñar sistemas de inferencia continua del estado del aprendiz.

Arquitecturas Multi-agente

Sistemas donde múltiples agentes especializados colaboran. Patrón Orchestrator-Worker: agente líder coordina subagentes paralelos.

Agente único para tareas coherentes; multi-agente para tareas paralelizables. La arquitectura depende del objetivo pedagógico-andragógico.

Memoria Tricapa

Working Memory (sesión) + Short-Term RAG (estado reciente) + Long-Term Profile (modelo persistente del aprendiz).

Supera el “estudiante eternamente nuevo”: captura patrones reales, dificultades recurrentes y estrategias efectivas. No pregunta qué funciona: observa qué funciona.

1. Introducción: Del conectivismo a la constelación de agentes

Veintidós años después de publicar “Connectivism: A Learning Theory for the Digital Age” (Siemens, 2005), George Siemens regresa a Latinoamérica con un mensaje que completa un arco intelectual inquietante: si en 2004 argumentó que “el aprendizaje puede residir en dispositivos no humanos,” en 2026 afirma que los dispositivos no humanos pueden reemplazar infraestructuras educativas completas.

La conferencia “AI and the Future of Higher Education”—presentada en el Pabellón Carreta del Campus Monterrey ante una audiencia de líderes universitarios latinoamericanos—se llevó a cabo el 27 de enero de 2026. El contexto es crucial: mientras las universidades debaten políticas sobre ChatGPT, Siemens plantea que esa conversación ya es obsoleta. La pregunta no es si permitir o prohibir IA generativa, sino cómo las instituciones construirán sus propios ecosistemas agentivos antes de que las plataformas comerciales lo hagan por ellas.

1.1 Trayectoria intelectual: de las redes al sistema operativo

George Siemens nació en una familia menonita de agricultores en México, pasando sus primeros seis años sin electricidad—una ironía biográfica para quien se convertiría en teórico de las redes de conocimiento digital. Su artículo “Connectivism: A Learning Theory for the Digital Age” (2005) acumula más de 5,220 citaciones y se publicó cuando era instructor en Red River College, Winnipeg. La teoría emergió en el contexto de la Web 2.0, cuando blogs, wikis y redes sociales transformaban radicalmente el acceso y distribución del conocimiento.

Los ocho principios originales del conectivismo (Siemens, 2005) anticiparon fenómenos que hoy parecen evidentes pero que en 2004 eran controversiales:

- El aprendizaje como proceso de conectar nodos especializados

- El conocimiento residiendo fuera del individuo (en organizaciones, bases de datos)

- La capacidad de “saber más” siendo más crítica que lo que se sabe actualmente

- El aprendizaje residiendo en dispositivos no humanos

Este último principio generó las críticas más fuertes. Verhagen (2006) argumentó que alterar la definición de “aprendizaje” para incluir dispositivos no humanos convertía al conectivismo en una visión pedagógica, no en una teoría del aprendizaje propiamente dicha. Bell (2011) criticó la falta de evidencia empírica. Kerr (2007) sostuvo que las teorías existentes ya abordaban satisfactoriamente el aprendizaje en la era tecnológica.

Pero Siemens no abandonó la provocación. Co-diseñó con Stephen Downes el primer MOOC de la historia—”Connectivism and Connective Knowledge” (CCK08)—atrayendo 2,200 participantes globales. Posteriormente se convirtió en figura fundacional del campo de learning analytics, presidiendo la Society for Learning Analytics Research (SoLAR) y co-fundando la conferencia Learning Analytics and Knowledge (LAK).

En los últimos años, su trabajo en Matter and Space (también conocido como SNHU Human Systems) y como presidente fundador de GRAILE (Global Research Alliance for AI in Learning and Education) lo ha posicionado en la vanguardia de la investigación sobre agentes de IA en educación. Su advertencia es clara:

“Casi nadie está preguntando, de manera sostenida y seria, qué significa diseñar el aprendizaje para un futuro donde no sabemos qué conocimiento permanecerá estable, qué habilidades retendrán valor, o cómo los humanos continuarán importando cognitivamente.”

La conferencia del 28 de enero de 2026 es su respuesta más articulada a esa pregunta.

Evolución Intelectual: De Redes a Orquestación

George Siemens • 2004-2026 • Trayectoria Conceptual

2. El paradigma del LLM Operating System

Siemens inicia la conferencia con una diapositiva técnica que desconcierta a quienes esperan una charla pedagógica convencional: el diagrama de un “LLM OS” (Karpathy, 2023). No es coincidencia que comience aquí. La metáfora del sistema operativo redefine radicalmente cómo debemos entender los modelos de lenguaje en educación.

2.1 De chatbots a kernels

Andrej Karpathy—ex-director de IA en Tesla y OpenAI—propuso en 2023 que los LLMs no son meramente chatbots sofisticados, sino el proceso kernel de un sistema operativo emergente (Karpathy, 2023). En esta arquitectura:

- El LLM funciona como CPU/kernel, coordinando todas las funciones del sistema

- La ventana de contexto opera como RAM, gestionando memoria de trabajo con límites definidos (128K tokens en GPT-4 Turbo)

- Los embeddings vectoriales sirven como filesystem, almacenando representaciones semánticas persistentes

- El acceso a herramientas (navegador, intérprete Python, terminal) replica dispositivos periféricos

- El lenguaje natural es la interfaz, reemplazando comandos de código

Siemens utiliza esta metáfora para establecer un punto fundamental: estamos diseñando infraestructura, no aplicaciones educativas. Cuando una universidad implementa “IA en educación,” no está adoptando un software más—está decidiendo qué tipo de sistema operativo educativo construirá para las próximas décadas.

La implicación es radical: si los LLMs son kernels de sistemas operativos, entonces las decisiones sobre arquitectura de agentes, diseño de memoria y orquestación de contexto son decisiones sobre el propio funcionamiento básico del aprendizaje institucional.

LLM OS: De Chatbot a Infraestructura Educativa

La metáfora del sistema operativo redefine cómo debemos entender los modelos de lenguaje en educación

3. Agentes: más allá de la definición

“¿Qué son agentes?” pregunta Siemens, mostrando la definición canónica de Russell y Norvig (2021, p. 36):

“Algo que percibe y actúa en un entorno… con la capacidad de operar autónomamente, percibir su entorno, persistir en el tiempo, adaptarse al cambio, y crear y perseguir objetivos.”

Pero Siemens no se detiene en la teoría. Muestra arquitecturas reales de sistemas agentivos desplegados en contextos de alto riesgo.

3.1 Polaris: constelación de agentes en salud

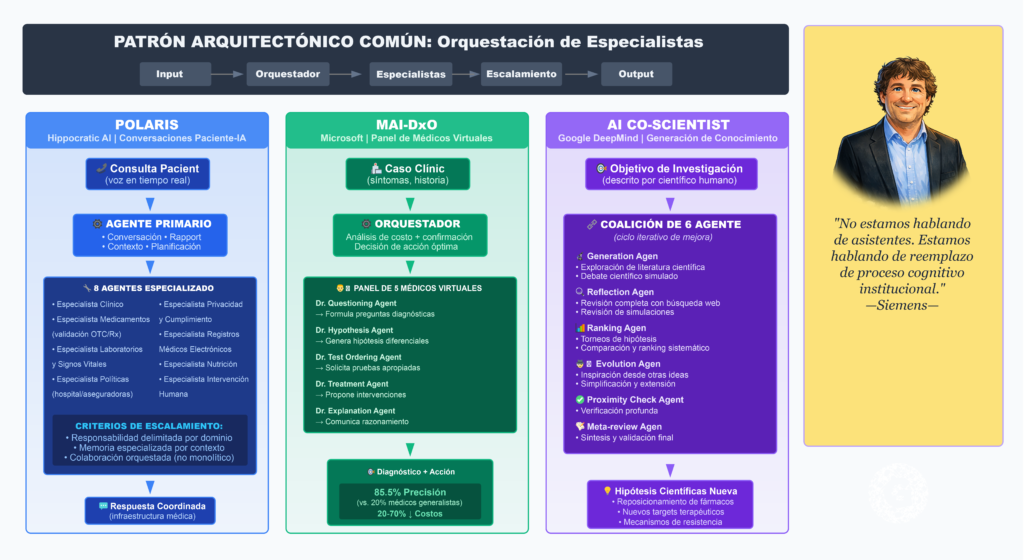

El primer caso es Polaris, un sistema desarrollado por Hippocratic AI para conversaciones de voz paciente-IA en tiempo real (Mukherjee et al., 2024). La arquitectura [Figura 1] revela una constelación multi-agente:

Agente primario:

- Capacidades conversacionales centrales

- Construcción de rapport

- Educación al paciente

- Gestión de contexto

- Planificador de acciones

Agentes de soporte especializados:

- Especialista clínico

- Especialista en medicamentos (validación OTC/Rx)

- Especialista en laboratorios y signos vitales

- Especialista en políticas hospitalarias/aseguradoras

- Especialista en privacidad y cumplimiento

- Especialista en registros médicos electrónicos

- Especialista en nutrición

- Especialista en intervención humana

Lo crucial no es la sofisticación tecnológica, sino el principio arquitectónico: cada agente tiene responsabilidad delimitada, memoria especializada y criterios claros de escalamiento. El sistema no intenta que un solo agente “sepa todo sobre salud,” sino que orquesta especialistas que colaboran.

Siemens enfatiza: “Esto no es IA apoyando a doctores. Es infraestructura médica reemplazada por coordinación agentiva.”

3.2 MAI-DxO: el panel de médicos virtuales

El segundo ejemplo es el Microsoft AI Diagnostic Orchestrator (Nori et al., 2025), presentado en junio de 2025. El sistema simula un panel de cinco médicos virtuales con roles distintos:

- Dr. Questioning Agent (formula preguntas diagnósticas)

- Dr. Hypothesis Agent (genera hipótesis diferenciales)

- Dr. Test Ordering Agent (solicita pruebas apropiadas)

- Dr. Treatment Agent (propone intervenciones)

- Dr. Explanation Agent (comunica razonamiento)

Un agente orquestador evalúa las recomendaciones mediante análisis de costo y confirmación diagnóstica, decidiendo la acción óptima: hacer pregunta, solicitar examen o proveer diagnóstico.

El rendimiento documentado es extraordinario: 85.5% de precisión diagnóstica en casos desafiantes del New England Journal of Medicine—comparado con 20% para médicos generalistas—mientras reduce costos diagnósticos en 20-70% (Nori et al., 2025).

3.3 AI Co-Scientist: generación y debate científico

El tercer caso, desarrollado por Google DeepMind (Gottweis et al., 2025), muestra agentes no solo aplicando conocimiento sino creando conocimiento nuevo. El sistema AI Co-Scientist utiliza una coalición de agentes especializados:

- Generation Agent: Exploración de literatura, debate científico simulado

- Reflection Agent: Revisión completa con búsqueda web, revisión de simulaciones

- Ranking Agent: Torneos de hipótesis, comparación y ranking

- Evolution Agent: Inspiración desde otras ideas, simplificación, extensión de investigación

- Proximity Check Agent y Meta-review Agent: Verificación profunda

El científico humano describe un objetivo de investigación, el sistema genera y debate hipótesis en un ciclo iterativo de mejora. Las aplicaciones demostradas incluyen reposicionamiento de fármacos, descubrimiento de nuevos targets terapéuticos y predicción de mecanismos de resistencia antimicrobiana.

Siemens se detiene aquí: “¿Ven el patrón? No estamos hablando de asistentes. Estamos hablando de reemplazo de proceso cognitivo institucional.”

4. El debate arquitectónico: ¿uno o muchos?

En este punto de la conferencia, Siemens introduce una tensión técnica fundamental que tiene implicaciones pedagógicas profundas: el debate entre arquitecturas de agente único versus multi-agente.

4.1 La posición de Cognition: “No construyan multi-agentes”

Muestra la diapositiva de Cognition Labs—creadores de Devin, el ingeniero de software AI—titulada provocativamente “Don’t Build Multi-agent Systems” (Yan, 2025). El argumento es contundente:

Los sistemas multi-agente son “casi seguramente no confiables” porque:

- Los subagentes operando en paralelo pueden tomar decisiones conflictivas

- La compartición de contexto entre agentes es deficiente

- Los outputs resultantes son inconsistentes

Solución propuesta: Un agente único que descompone tareas secuencialmente, comprimiendo contexto entre subtareas. Cada subtarea se ejecuta completamente antes de pasar a la siguiente, manteniendo coherencia.

4.2 La posición de Anthropic: multi-agentes cuando se hace bien

Contrasta con la arquitectura de Anthropic para su sistema de investigación avanzada (Hadfield et al., 2025). Aquí, el patrón Orchestrator-Worker con agentes paralelos logra:

- 90.2% mejor rendimiento que agentes únicos en tareas de investigación

- Hasta 90% de reducción en tiempo mediante paralelización de llamadas a herramientas

- Agente líder (Claude Opus 4) coordinando subagentes (Claude Sonnet 4) como “filtros inteligentes”

Siemens sintetiza: “El contexto y el caso de uso importan al seleccionar arquitectura, pero los agentes tienen promesa significativa para innovación educativa.”

La implicación pedagógica es clara: tareas profundas y coherentes (escribir un ensayo, programar una aplicación completa) favorecen agentes únicos; tareas amplias y paralelizables (investigación bibliográfica, evaluación multi-criterio) favorecen multi-agentes.

🤖 Simulador de Decisión Arquitectónica

¿Agente Único o Multi-Agente? Descubre qué arquitectura se adapta mejor a tu caso educativo

Explora cómo aplicar el criterio de Siemens para elegir entre arquitecturas de agente único (Cognition) o multi-agente (Anthropic). Comienza con un caso ejemplo o analiza tu propio escenario educativo.

Describe tu escenario educativo

Tu caso:

1 ¿La tarea requiere un output único y coherente?

2 ¿Se puede dividir en subtareas independientes?

3 ¿Es más importante velocidad o consistencia narrativa?

5. Ingeniería del contexto: el nuevo diseño instruccional

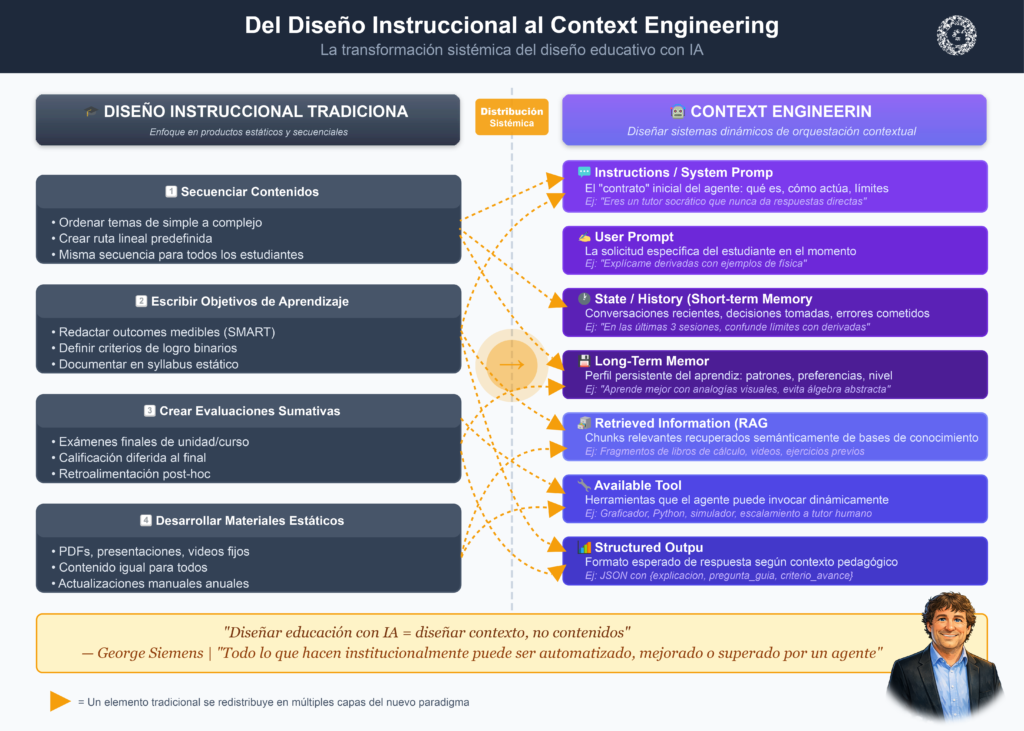

Aquí Siemens presenta lo que considera el cambio más fundamental en el diseño educativo con IA: el paso del prompt engineering al context engineering.

5.1 Más allá del prompt

Muestra el diagrama de Phil Schmid (2025) sobre “Context Engineering” [Figura 2]. El contexto NO es solo el user prompt. El contexto ES:

- Instructions / System Prompt: El “contrato” inicial del agente

- User Prompt: La solicitud específica del estudiante

- State / History (Short-term Memory): Conversaciones recientes, decisiones tomadas

- Long-Term Memory: Perfil persistente del aprendiz

- Retrieved Information (RAG): Chunks relevantes recuperados semánticamente

- Available Tools: Herramientas que el agente puede invocar

- Structured Output: Formato esperado de respuesta

Schmid (2025) define context engineering como:

“La disciplina de diseñar y construir sistemas dinámicos que proveen la información y herramientas correctas, en el formato correcto, en el momento correcto, para dar al LLM todo lo que necesita para cumplir una tarea.”

Siemens traduce: “Diseñar educación con IA = diseñar contexto, no contenidos.”

5.2 Implicaciones para el diseño instruccional

Este cambio desarticula prácticas consolidadas del diseño instruccional:

Comparación de prácticas: Tradicional vs Context Engineering

De la producción de contenidos a la orquestación de decisiones, inferencias y repositorios dinámicos.

| Diseño Instruccional Tradicional | Context Engineering |

|---|---|

| Secuenciar contenidos | Orquestar flujos de información |

| Escribir objetivos de aprendizaje | Definir criterios de decisión agentiva |

| Crear evaluaciones sumativas | Diseñar sistemas de inferencia continua |

| Desarrollar materiales estáticos | Curar repositorios semánticos dinámicos |

Siemens enfatiza: “Todo lo que hacen ahora institucionalmente y operacionalmente puede ser automatizado, mejorado o incluso superado por un agente. Ya sea su LMS, libros de texto, procesos de evaluación, enseñanza, tutoría.”

6. Arquitectura de memoria: del olvido a la persistencia

La sección sobre sistemas de memoria es donde la charla se vuelve técnicamente densa pero pedagógicamente revolucionaria.

6.1 La tricapa de memoria

Siemens presenta un esquema de arquitectura de memoria [Figura 3] con tres capas paralelas a modelos cognitivos humanos:

Working Memory (Agent-Level):

- Scope: Específico al agente, enfocado en actividad

- Content: Datos transaccionales—memoria necesaria para la tarea actual

- Purpose: Mantiene contexto dentro de actividad única

- Lifecycle: Basada en sesión, se limpia entre actividades

Short-Term Memory (RAG System):

- Storage: Vector store con indexación de fecha

- Content: Datos efímeros—estado reciente del aprendiz

- Process: Un worker en segundo plano extrae y resume

- Retrieval: Datos recientes priorizados sobre antiguos

- Cross-Agent: Disponible para todos los agentes (excepto wind-down)

Long-Term Memory (Learner Profile):

- Storage: Data lake con datos crudos persistentes

- Content: Datos estables—estado sostenido del aprendiz

- Processing: Indicadores calculados/predichos en el tiempo

- Purpose: Modelo comprehensivo del usuario para personalización

6.2 Memory Capture: qué se registra

En una segunda diapositiva sobre memoria, Siemens muestra ejemplos concretos de captura:

Personal Profile:

- Familia, mascotas, ocupación, educación

- Hobbies, intereses, entretenimiento

- Metas de carrera/habilidades/estilo de vida

- Situación de vida, eventos vitales mayores

Learning History:

- Áreas de dificultad y necesidades de clarificación

- Áreas de interés y engagement

- Desafíos de aprendizaje y preferencias

- Explicaciones proporcionadas y correcciones

Esta arquitectura responde a una crítica histórica del e-learning: el problema del “estudiante eternamente nuevo.” En LMS tradicionales, cada curso comienza desde cero, ignorando lo que el sistema ya sabe sobre patrones de aprendizaje del estudiante, dificultades conceptuales recurrentes o estrategias metacognitivas efectivas.

Siemens: “Esto NO es vigilancia. Es un modelo de aprendizaje vivo. El perfil de largo plazo captura preferencias reales no declaradas—qué funciona para este aprendiz específico, no qué dice que funciona.”

💾 Arquitectura de Memoria en Sistemas Educativos con IA

Del olvido institucional a la persistencia inteligente del aprendizaje

La Tricapa de Memoria

Working Memory (Agent-Level)

Memoria de trabajo específica al agente

Específico al agente, enfocado en actividad actual

Datos transaccionales necesarios para la tarea inmediata

Mantiene contexto dentro de una actividad única

Basada en sesión, se limpia entre actividades

Short-Term Memory (RAG System)

Sistema de recuperación semántica reciente

Vector store con indexación temporal

Datos efímeros: estado reciente del aprendiz

Worker en segundo plano extrae y resume continuamente

Prioriza datos recientes sobre antiguos

Disponible para todos los agentes del sistema

Long-Term Memory (Learner Profile)

Modelo persistente y comprehensivo del usuario

Data lake con datos crudos persistentes

Datos estables: estado sostenido del aprendiz

Indicadores calculados y predichos a lo largo del tiempo

Modelo comprehensivo para personalización profunda

Flujo Temporal de Datos

Sesión

(minutos-horas)

Reciente

(días-semanas)

Persistente

(meses-años)

Memory Capture: Ejemplos Concretos

La arquitectura de memoria responde al problema del "estudiante eternamente nuevo". En LMS tradicionales, cada curso comenzaba desde cero, ignorando patrones y estrategias ya identificadas.

👤 Personal Profile Long-Term

Contexto vital estable que informa personalización educativa.

📚 Learning History Short Long

Patrones identificados por interacciones continuas.

⚖️ La Pregunta Ética

¿Memoria persistente como vigilancia educativa o como modelo de aprendizaje vivo para personalización auténtica?

🚨 Vigilancia

- Datos sensibles sin límites claros

- Persistencia indefinida sin control del estudiante

- Riesgo de perfilamiento y sesgos

- Asimetría de poder y acceso

- Ausencia de “derecho al olvido”

✅ Modelo Vivo

- Captura lo que funciona (no solo lo declarado)

- Evita repetir explicaciones ya conocidas

- Personaliza con patrones longitudinales

- Reduce carga cognitiva

- Escala tutoría humana con evidencia

La Tesis de Siemens

"Esto NO es vigilancia. Es un modelo de aprendizaje vivo. El perfil de largo plazo captura preferencias reales no declaradas—qué funciona para este aprendiz específico, no qué dice que funciona."

— George Siemens

💭 Preguntas para tu institución

- ¿Qué consentimiento informado exigirías?

- ¿Cómo garantizarías transparencia (ver qué se almacena)?

- ¿Qué datos deben expirar y cuáles persistir?

- ¿Quién accede a esta memoria?

7. Analítica situada: del registro al estado

El cambio más filosóficamente profundo de la conferencia ocurre en la sección sobre datos y analítica.

7.1 “What Happens With Data?”

La diapositiva clave [Figura 4] muestra una jerarquía de cuatro niveles:

Variables (nivel inferior):

- Tiempo en assessment

- Conteo diario de videos vistos

- Tiempo con el agente dialogante

- Duración de sueño

- Variabilidad de frecuencia cardíaca

- Tono emocional de interacciones del estudiante con el agente

- Conteo de consultas al agente

Indicators (nivel 2):

- Access Frequency

- Effortful Engagement

- Time on Task

- Daily Sentiment Indicator

- Daily Stress Level

- Sleep Quality

States (nivel 3):

- Lack of motivation

- Limited participation in group activities

- Reluctance to seek help

- Difficulty in grasping concepts

Constructs (nivel superior):

- Mood

- Motivation

- Cognitive Engagement

- Connection

Siemens articula el cambio paradigmático:

❌ Datos como registros pasivos: “El estudiante completó módulo 3, obtuvo 75%, conectó 3 veces esta semana”

✅ Datos como indicadores de estado cognitivo, emocional y relacional: “El estudiante muestra reluctancia a buscar ayuda (estado) inferida por reducción en consultas al agente + aumento en tiempo de tarea + patrones de reformulación (variables)”

Esto conecta directamente con su crítica histórica a encuestas, rúbricas finales y mediciones declarativas. La evaluación no pregunta “¿qué tan motivado te sientes?” sino que infiere motivación desde decisiones y señales.

7.2 Analítica de lenguaje natural

Muestra otra diapositiva: “Analytics implications: Large scale natural language discussion, cognition, and turn taking data.”

El lenguaje se convierte en el nuevo dataset educativo:

- Turn-taking patterns: ¿Quién inicia? ¿Quién domina? ¿Cuánto tiempo pasa antes de responder?

- Cognition markers: Uso de lenguaje metacognitivo, marcadores de confusión, reformulaciones

- Discussion quality: Profundidad de elaboración, uso de evidencia, integración conceptual

Siemens: “La toma de turnos, silencios, reformulaciones y dudas son evidencia. El aprendizaje es discursivo y relacional, no secuencial. Aquí se rompe definitivamente la lógica SCORM / xAPI clásica.”

🧠 Simulador de Inferencia Analítica

Del registro pasivo al estado cognitivo: Aprende cómo los sistemas con IA infieren el estado del aprendiz

Dos Paradigmas de Analítica Educativa

📋 Datos como Registros Pasivos

El enfoque tradicional: documentar acciones discretas sin inferir estados cognitivos o emocionales.

"El estudiante completó el módulo 3"

"Obtuvo 75% en el assessment"

"Se conectó 3 veces esta semana"

¿Está motivado? ¿Confundido? ¿Necesita ayuda? Los datos no responden estas preguntas críticas.

🧠 Datos como Indicadores de Estado

El nuevo enfoque: inferir estados cognitivos, emocionales y relacionales desde patrones de variables.

"El estudiante muestra reluctancia a buscar ayuda"

Inferido por: ↓ consultas al agente + ↑ tiempo en tarea + patrones de reformulación

"El estudiante presenta dificultad en comprender conceptos"

Inferido por: múltiples reintentos + tiempo prolongado + tono de frustración

"El estudiante muestra falta de motivación"

Inferido por: ↓ acceso + sentimiento negativo + participación limitada

El sistema puede intervenir proactivamente antes de que el estudiante abandone o falle.

💡 El Cambio Paradigmático de Siemens

"La evaluación no pregunta '¿qué tan motivado te sientes?' sino que infiere motivación desde decisiones y señales. Esto rompe definitivamente con encuestas, rúbricas finales y mediciones declarativas."

La Jerarquía de Inferencia: 4 Niveles

Haz clic en cada nivel para ver ejemplos concretos

🔍 Cómo Funciona la Inferencia

Las variables se agregan en indicators, que revelan states, que informan constructs. Cada nivel abstrae y sintetiza el anterior, permitiendo intervenciones pedagógico-andragógicas informadas por teoría.

Observa una Inferencia en Acción

Caso: María, estudiante de cálculo diferencial

Seguimiento durante últimas 2 semanas

Nivel 1: Variables Variables

- Consultas al agente: 8 → 2 (−75%)

- Tiempo en tareas: 45 → 85 min (+89%)

- Reformulación: 3 intentos por pregunta

- Tono emocional: neutral → frustración

Nivel 2: Indicators Indicators

- Access Frequency: Crítico ↓

- Time on Task: Muy alto

- Effortful Engagement: Alto, improductivo

- Daily Sentiment: Tendencia negativa

Nivel 3: State State

- Reluctancia a buscar ayuda

- Dificultad en comprender conceptos

- Frustración creciente

✅ Inferencia Completa

Construct: Baja Autoeficacia + Engagement Cognitivo Desconectado

Intervención: Escalamiento proactivo a tutor humano con enfoque en estrategias metacognitivas.

💡 Por Qué Esto Importa

Un LMS tradicional solo registraría: "María completó 4 tareas esta semana." Este sistema infiere: "María necesita intervención inmediata porque está luchando sola." La diferencia es entre reporte y comprensión.

🎯 Ahora Tú: Practica la Inferencia

Lee variables, elige la inferencia y recibe feedback inmediato.

Caso 1: Carlos, estudiante de programación

📊 Variables Observadas

- Acceso constante (5–6/semana)

- Videos vistos alto (80%)

- Tiempo en assessments normal

- Consultas al agente muy bajas

- Participación en foros nula

- Tono emocional neutral

¿Qué se infiere?

Caso 2: Lucía, estudiante de biología molecular

📊 Variables Observadas

- Sueño muy reducido (4–5h)

- Variabilidad cardíaca elevada

- Tiempo en assessments +150%

- Reformulaciones múltiples

- Ansiedad en interacciones

- Accesos nocturnos 11pm–2am

¿Qué se infiere?

Caso 3: Diego, estudiante de historia del arte

📊 Variables Observadas

- Acceso descendente (6→3→1)

- Videos vistos muy bajo (20%)

- Tiempo en plataforma −70%

- Participación activa → nula

- Sentimiento negativo sostenido

- Consultas al agente 0

¿Qué se infiere?

🎉 ¡Completaste el Simulador!

Has experimentado cómo los sistemas con IA infieren estados desde variables observables. El cambio es de registro pasivo a comprensión activa.

8. Visualizaciones: lectura pedagógica vs. control administrativo

Las siguientes diapositivas muestran visualizaciones complejas del sistema Matter and Space [Figura 5]:

- Learner progression through CG nodes with competency level: Heatmap mostrando progresión no-lineal por nodos de un curriculum graph

- User-agent engagement: Matriz de interacciones estudiante-agente por tipo de agente

- User Intake clustering: Agrupamiento jerárquico basado en patrones de ingreso

- Learner competency by CG node learning objective: Distribución de dominio competencial

Siemens enfatiza: “Estas NO son dashboards administrativos. Son instrumentos de lectura pedagógica-andragógica.”

Lo que representan:

- Progresión no-lineal

- Competencia distribuida

- Engagement situado por agente

- Ritmos distintos sin penalización

La última visualización—un heatmap temporal de tiempo en tarea por sub-agente—muestra patrones de engagement de estudiantes reales con diferentes agentes pedagógicos (Apply, Content Learn, Learning Flow, Onboarding, Reflect, Reinforce, Wellness Checkpoint, etc.) a través de semanas.

Siemens: “Esto dialoga con aprendizaje rizomático, trayectorias personalizadas, evaluación por decisiones, no por hitos.”

Simulador de Lectura Pedagógica-Andragógica

Aprende a interpretar visualizaciones complejas como instrumentos de comprensión del aprendizaje

El Cambio de Perspectiva

Las visualizaciones de sistemas educativos con IA NO son dashboards administrativos. Son instrumentos de lectura pedagógica-andragógica que revelan patrones de aprendizaje, no métricas de cumplimiento.

Dos Formas de Leer Visualizaciones

📊 Lectura Administrativa (tradicional)

- ¿Cuántos completaron? — Tasas de terminación

- ¿Cuál es el promedio? — Normalización por medias

- ¿Quién está atrasado? — Penalización temporal

- ¿Qué porcentaje pasó? — Cumplimiento binario

- ROI — Costo-beneficio agregado

🎓 Lectura Pedagógica-Andragógica (nueva)

- ¿Qué patrón muestra este aprendiz? — Trayectorias individuales

- ¿Dónde está el engagement? — Esfuerzo situado

- ¿Cuál es el ritmo natural? — Tiempos personales

- ¿Qué revela la no-linealidad? — Aprendizaje rizomático

- ¿Qué intervención necesita? — Apoyo personalizado informado

En este simulador, verás 3 visualizaciones complejas de sistemas reales. Tu desafío: identificar qué patrón revelan y qué intervención pedagógica-andragógica sugieren, evitando lecturas administrativas superficiales.

Lo que representan: progresión no-lineal, competencia distribuida, engagement situado por agente y ritmos distintos sin penalización.

La última visualización —un heatmap temporal de tiempo en tarea por sub-agente— muestra patrones reales con agentes (Apply, Content, Learning Flow, Onboarding, Reflect, Reinforce, Wellness, etc.) a través de semanas.

Siemens: “Esto dialoga con aprendizaje rizomático, trayectorias personalizadas, evaluación por decisiones, no por hitos.”

Caso 1: Progresión No-Lineal por Curriculum Graph

Heatmap mostrando nivel de dominio competencial por nodo y semana

¿Qué interpretación es más apropiada?

Caso 2: Engagement Usuario-Agente por Tipo

Matriz mostrando interacciones estudiante-agente por tipo de agente

¿Qué patrón revela esta matriz?

Caso 3: Tiempo en Tarea por Sub-Agente

Patrón temporal (8 semanas)

¿Qué revela este patrón temporal?

9. La tesis central: innovación en la capa de orquestación

Llegamos a la diapositiva que Siemens considera el núcleo de su argumento:

“Context and use case matters when selecting architecture, but agents hold significant promise for education innovation. Few areas of focus will generate more value in universities taking control of their future. Agents are an application feature of foundation models.“

La última frase es crítica. Los modelos fundacionales (GPT, Claude, Gemini, Llama) se están comoditizando. OpenAI, Anthropic y Google compiten en márgenes cada vez menores de rendimiento. Pero la diferenciación real ocurre en:

- Cómo se asignan roles a los agentes

- Cómo se gestiona la memoria del aprendiz

- Cómo se diseña el contexto de cada interacción

- Cómo se interpretan datos para intervención pedagógica

Siemens llama a esta capa “agentes, memoria y analítica situada.” Situada porque está enraizada en el contexto institucional específico: los datos del estudiante, las competencias curriculares, los recursos disponibles, las políticas de la universidad.

9.1 “It’s agents…”

La penúltima diapositiva es casi un manifiesto:

LMS → Agents

Textbooks → Agents

Assessment → Agents

Teaching → Agents

Tutoring → Agents

Etc.Siemens en el transcript:

“Todo lo que hacen ahora institucionalmente y operacionalmente puede ser automatizado, mejorado o incluso superado por un agente. Ya sea su LMS, libros de texto, procesos de evaluación, enseñanza, tutoría… Todos ahora comienzan a sentarse dentro del paisaje de agentes.”

Pero luego agrega una advertencia crucial: “Y regreso nuevamente a la diapositiva que presenté anteriormente—este es mi última slide—así que solo quiero mencionar: los aliento a iniciar equipos pequeños para comenzar a construir, evaluar con agentes para resolver problemas específicos.”

La innovación ocurre en la capa de orquestación

Los modelos fundacionales se comoditizan. La diferenciación real ocurre en cómo asignas roles a agentes, gestionas memoria del aprendiz, diseñas contexto e interpretas datos para intervención pedagógica-andragógica.

“Context and use case matters when selecting architecture, but agents hold significant promise for education innovation. Few areas of focus will generate more value in universities taking control of their future. Agents are an application feature of foundation models.“

Define tu contexto

Describe el dolor y la restricción. Esto fija el “use case” (Siemens).

💡 Recordatorio Siemens

Empieza con equipos pequeños y problemas específicos. No es transformación masiva top-down.

Elige tu apuesta de orquestación

No eliges “la IA”, eliges la capa donde enfocarás innovación: roles, memoria, contexto o analítica.

Tip: simula primero con “Roles”, luego cambia a otra capa y observa si tu criterio se mantiene.

Tesis (resumen) · “Mapa de capa”

Elige dos capas donde crees que está la innovación y escribe una razón. No buscamos “la correcta”: buscamos que puedas explicar tu decisión.

It’s agents… · “Traduce tu institución”

Convierte el manifiesto en un caso real: elige un dominio, un tipo de agente y un riesgo. El sistema te propone un primer experimento y una pregunta metacognitiva.

⚠️ Regla Siemens

Equipo pequeño + problema específico + evaluación real. Si tu caso se vuelve “mega-transformación”, reduce alcance.

10. El rol del docente: del código al programa

La sesión de preguntas y respuestas ilumina la preocupación más profunda de la audiencia: ¿qué pasa con los profesores?

Un participante pregunta sobre el rol del docente en relación con agentes. La respuesta de Siemens es la más elaborada de la conferencia:

“La educación tiene al menos tres componentes de desarrollo para estudiantes. Les enseñamos conocimiento y habilidades, les enseñamos formas de ser, y también atendemos su desarrollo en torno a dinámicas de bienestar y salud mental. Entonces, solo una pequeña parte de la experiencia universitaria está directamente relacionada con aprender contenido, entender cuándo aplicarlo, entender qué tiene sentido y qué no. Esos son roles que los profesores universitarios continuarán modelando y continuarán apoyando a los estudiantes.“

Luego ofrece una analogía reveladora:

“Si quieren entender el futuro de casi todo el trabajo de conocimiento, diría: miren qué ha pasado con la ingeniería de software en los últimos 18 meses. Muchos desarrolladores, si me preguntaran, dirían que la codificación era una parte primaria de su trabajo. El tiempo que pasaban literalmente escribiendo Python o Java o JavaScript era una gran parte del trabajo que hacían. Ahora… solo hoy Andre Karpathy publicó que solía tener solo 20% de su tiempo de codificación asistido por agentes o por IA. Dijo que ahora está invertido, ahora 20% es él, 80% es IA. Pero lo que está pasando es que esto les da más tiempo para hablar sobre el meta, la estructura del sistema, la evaluación, evaluar la calidad del output. Entonces el punto es que te conviertes en un programador, no en un codificador, y el codificador solo escribe el software real.”

La distinción es fundamental: programador vs. codificador. El codificador escribe líneas de código; el programador piensa en arquitecturas, diseña sistemas, evalúa calidad.

Aplicado a educación:

“Nuestro rol como profesores en el aula. Tenemos que hacer la evaluación más amplia, ayudar a los aprendices a entender las formas en que su moralidad es impactada, las formas en que necesitan estar en el mundo, cómo estar bien mental y emocionalmente. Entonces mucho de esto es escalar la experiencia de aprendizaje al nivel metacognitivo versus mantenerla en el nivel [cognitivo básico].”

Autodiagnóstico metacognitivo: ¿estoy “codificando” o “programando” mi docencia?

Responde 8 dilemas A/B. La idea no es “aprobar”, sino detectar tu tendencia actual y convertirla en un siguiente paso accionable (equipo pequeño + problema específico), en línea con Siemens.

Cómo usarlo

- Responde los 8 dilemas (A/B).

- Haz clic en Ver resultado cuando completes todo.

- Lee tus 2 recomendaciones y responde la pregunta metacognitiva.

- Define un siguiente paso en formato: “equipo pequeño + problema específico”.

8 dilemas A/B

Propósito principal

Diseño de evaluación

Gestión del contexto

Uso de agentes / roles

Memoria del aprendiz

Trayectorias

Datos

Rol docente

11. Discusión: tensiones, paradojas y preguntas abiertas

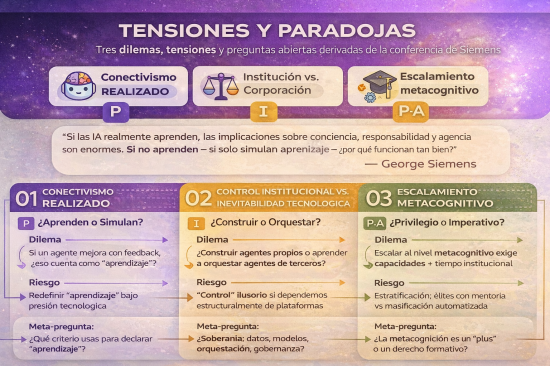

La conferencia de Siemens no ofrece un manual de implementación. Deliberadamente, abre más preguntas de las que cierra. Aquí exploro tres tensiones centrales que emergen del análisis.

11.1 La paradoja del conectivismo realizado

El conectivismo de 2004 anticipó que “el aprendizaje puede residir en dispositivos no humanos” (Siemens, 2005, p. 7). Verhagen (2006) criticó que esta afirmación requería alterar fundamentalmente la definición de “aprendizaje”—y tenía razón. Pero lo que Verhagen no anticipó es que la pregunta relevante no sería si debíamos alterar la definición, sino cuándo nos veríamos obligados a hacerlo por realidades tecnológicas.

Los sistemas que Siemens presenta—Polaris, MAI-DxO, AI Co-Scientist—no son metáforas. Son agentes que aprenden, se adaptan, persiguen objetivos y mejoran con retroalimentación. Cumplen los criterios de Russell y Norvig (2021) para agencia. ¿Están “aprendiendo” en el sentido que Siemens propuso en 2004?

La tensión es profunda: el conectivismo triunfa empíricamente justo cuando su validez teórica se vuelve más problemática. Si los agentes de IA realmente aprenden, las implicaciones sobre conciencia, responsabilidad y agencia son enormes. Si no aprenden—si solo simulan aprendizaje—entonces ¿por qué funcionan tan bien en contextos educativos?

11.2 Control institucional vs. inevitabilidad tecnológica

Siemens urge a las universidades a “tomar control de su futuro” construyendo capacidades agentivas propias. Pero la conferencia misma documenta que las arquitecturas más avanzadas provienen de corporaciones con recursos órdenes de magnitud superiores: Microsoft, Google, OpenAI, Anthropic.

¿Es realista esperar que universidades—incluso bien financiadas—desarrollen sistemas comparables? ¿O el llamado a “construir agentes” es, en realidad, un llamado a aprender a orquestar agentes construidos por otros?

La diferencia importa. Si las universidades solo pueden ser integradoras de sistemas externos, entonces el “control” que Siemens propone es ilusorio. La capa de orquestación sigue siendo valiosa, pero la dependencia estructural de plataformas comerciales es inevitable.

11.3 Escalamiento metacognitivo: ¿privilegio o imperativo?

La respuesta de Siemens sobre el rol docente—escalar al nivel metacognitivo—es pedagógicamente sofisticada pero socialmente elusiva. Presupone que:

- Los docentes tienen capacidad para operar efectivamente en ese nivel

- Los estudiantes están listos para trabajo metacognitivo

- Las instituciones valoran (y compensan) ese trabajo invisible

Ninguna de estas presuposiciones es universal. El “escalamiento metacognitivo” podría convertirse en un nuevo mecanismo de estratificación: universidades de élite ofreciendo mentoría metacognitiva humana mientras instituciones masificadas automatizan completamente la instrucción.

La pregunta no respondida: ¿qué pasa con los estudiantes en instituciones que no pueden ofrecer ese escalamiento?

📊 Simulador de Lectura Pedagógica-Andragógica

Un micro-módulo para leer tensiones y paradojas del texto (no “comprenderlo”), explicitando criterios, implicaciones y cambios de postura.

🧭 Mapa de tensiones del texto

Esto no es un resumen: es un andamio para detectar dónde te “tira” el argumento y qué supuestos llevas contigo al leer.

Conectivismo realizado: ¿aprenden o simulan?

- Dilema: si un agente mejora con retroalimentación, ¿eso cuenta como “aprendizaje”?

- Riesgo: redefinir “aprendizaje” por presión tecnológica.

- Pregunta abierta: si “no aprenden”, ¿por qué funcionan tan bien?

Control institucional vs inevitabilidad tecnológica

- Dilema: ¿construir agentes propios o aprender a orquestar agentes de terceros?

- Riesgo: “control” ilusorio si la capa crítica depende de plataformas.

- Pregunta abierta: ¿qué es “control” en un ecosistema comercial?

Escalamiento metacognitivo: ¿privilegio o imperativo?

- Dilema: escalar al nivel metacognitivo exige capacidades y tiempo institucional.

- Riesgo: estratificación: élites con mentoría humana vs masificación automatizada.

- Pregunta abierta: ¿qué pasa con quienes no reciben “escalamiento”?

🎯 Decisiones metacognitivas

Dilema 1 · ¿Aprendizaje o simulación?

Un sistema agentivo mejora su desempeño con retroalimentación, persigue objetivos y se adapta. ¿Qué afirmación te parece más defendible al leer esta tensión?

🧩 Pista pedagógico-andragógica

La metacognición aquí es: (1) declarar tu criterio, (2) ver qué consecuencias genera, (3) ajustar (o sostener) tu postura con argumentos.

📝 Bitácora metacognitiva

Escribe en formato breve. Esto se guarda en tu navegador (no se envía a ningún servidor).

Sugerencia: pega la bitácora en tu “Second Brain”/Obsidian o en el apartado de comentarios del artículo (si lo deseas).

12. Conclusiones: hacia una teoría del aprendizaje agentivo

Veintidós años después del conectivismo, Siemens no propone una nueva teoría del aprendizaje. Propone algo más modesto y más radical: una arquitectura.

El conectivismo fue una teoría sobre relaciones: cómo los nodos se conectan, cómo el conocimiento fluye por redes, cómo la capacidad de saber-dónde supera al saber-qué. Era una teoría optimista sobre distribución y acceso.

La visión de 2026 es una teoría sobre capas: qué reside en working memory vs. memoria persistente, qué decisiones toma qué agente, cómo el contexto se orquesta dinámicamente. Es una teoría pragmática sobre ingeniería y control.

El arco intelectual es coherente: si el aprendizaje es distribuido (conectivismo), entonces requiere infraestructura que gestione esa distribución (agentes, memoria, analítica). Pero hay una pérdida tonal. El conectivismo de 2004 era democratizante—cualquiera con conexión a internet podía aprender cualquier cosa. La arquitectura agentiva de 2026 es tecnocrática—se necesitan equipos de ingeniería, evaluación continua, recursos institucionales significativos.

¿Es posible recuperar el espíritu democratizante del conectivismo en la era agentiva? La conferencia no responde, pero sugiere una dirección: open-source agentic architectures. Si las universidades colaboran en frameworks agentivos abiertos—compartiendo patrones de orquestación, librerías de memoria, protocolos de evaluación—entonces quizás la arquitectura no necesita ser propietaria.

Siemens cierra con urgencia:

“Si no tienen un equipo de agentes construyendo en su universidad ahora, creo que están en una idea terrible porque necesitan montarse en esto y avanzar rápido.”

El mensaje es claro: la ventana para que las universidades construyan capacidades agentivas propias está cerrándose. Las plataformas comerciales ya están desplegando sistemas. La pregunta no es si habrá agentes en educación superior—ya los hay—sino quién controlará esos agentes y bajo qué lógica operarán.

El conectivismo argumentó que el aprendizaje ocurre en redes. La arquitectura agentiva argumenta que las redes necesitan ingeniería. Ambas afirmaciones son verdaderas. Ahora toca a las instituciones educativas decidir si serán arquitectas o inquilinas de sus propios sistemas de aprendizaje.

🧠 Cierre Metacognitivo: Arquitectura Agentiva

Síntesis • Tensiones • Posicionamiento institucional

Del conectivismo a la arquitectura

2004: Aprendizaje distribuido en redes.

2026: Infraestructura que orquesta memoria, agentes y decisiones.

➡ Aprender implica ahora diseñar sistemas, no solo contenidos.

Explora las paradojas

¿Tu institución hoy es…?

George Siemens en IFE Conference 2026

Este artículo se basa en la conferencia "AI and the Future of Higher Education" presentada por George Siemens (Chief AI Officer, Southern New Hampshire University) en IFE Conference 2026, Tecnológico de Monterrey, el 27 de enero de 2026. Las citas directas del transcript se integran con análisis de las diapositivas presentadas y contextualización académica de los conceptos discutidos. Las referencias a figuras corresponden a las diapositivas originales de la presentación.