Resumen

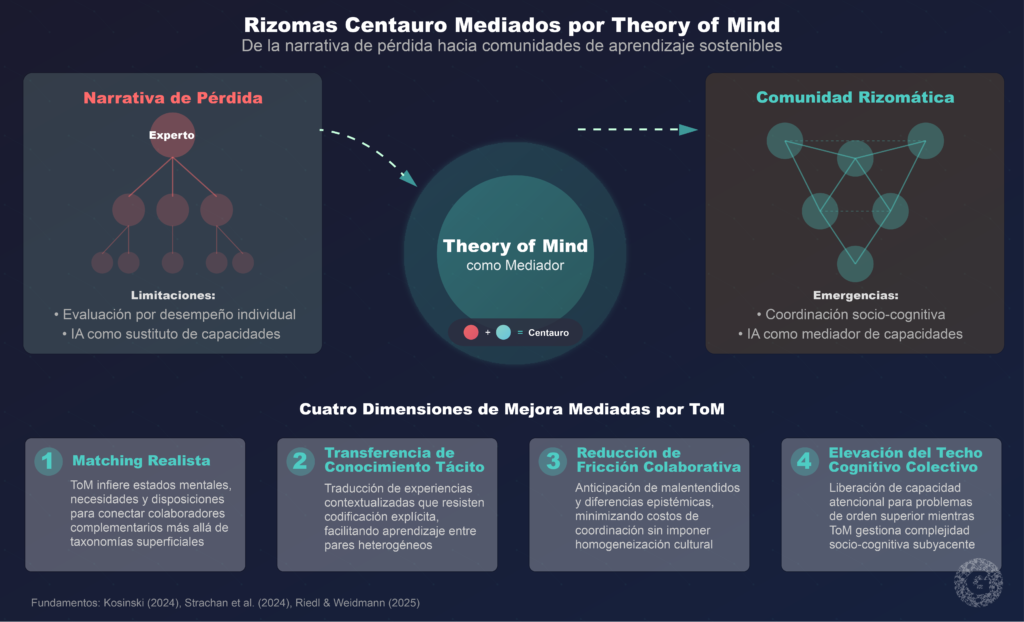

La integración de inteligencia artificial generativa en educación ha generado una narrativa de pérdida de capacidades humanas que oscurece las oportunidades reales para el desarrollo profesional docente. Este artículo propone un marco conceptual alternativo—“Rizomas Centauro Mediados por Theory of Mind” (ToM)—que posiciona a la IA no como sustituto sino como mediador de capacidades socio-cognitivas en comunidades de aprendizaje peer-to-peer. Fundamentado en evidencia reciente sobre ToM en modelos de lenguaje extensos (Kosinski, 2024; Strachan et al., 2024) y marcos bayesianos para cuantificar sinergia humano-IA (Riedl & Weidmann, 2025), el artículo argumenta que la calidad de la colaboración docente depende menos del “nivel” individual y más de capacidades de coordinación socio-cognitiva. Se presenta una agenda de investigación con cuatro hipótesis operacionalizables y se ilustran implicaciones de diseño mediante un caso conceptual: una plataforma peer-to-peer donde IA actúa como mediador ToM para mejorar matching realista, transferencia de conocimiento tácito, reducción de fricción colaborativa y elevación del techo cognitivo colectivo. El marco propuesto contribuye a la literatura de tecnología educativa al ofrecer una alternativa medible a las evaluaciones basadas únicamente en desempeño individual, señalando el camino hacia comunidades de aprendizaje profesional sostenibles y rizomáticas.

Palabras clave: Theory of Mind, aprendizaje rizomático, sinergia humano-IA, desarrollo profesional docente, comunidades de práctica, inteligencia colectiva

Introducción: No Es Pérdida de Humanidad, Es Cambio de Coordinación

La narrativa dominante sobre inteligencia artificial en educación se estructura frecuentemente como pérdida: pérdida de pensamiento crítico, de autonomía docente, de conexión humana (Misfeldt & Jankvist, 2025; Shojaee et al., 2025). Esta perspectiva, aunque comprensible ante cambios tecnológicos disruptivos, oscurece una pregunta más productiva: ¿qué capacidades humanas se vuelven más críticas, no menos, cuando trabajamos junto a sistemas de IA?

Evidencia reciente en ciencias cognitivas y estudios de interacción humano-IA sugiere una respuesta contraintuitiva: la capacidad humana clave no es memorizar más contenido curricular ni resolver problemas de manera más rápida, sino coordinar mejor—tanto con otros humanos como con máquinas (Riedl & Weidmann, 2025; Woolley et al., 2010). Esta coordinación no es simplemente “habilidad social” en sentido genérico, sino una capacidad socio-cognitiva específica: Theory of Mind (ToM), la habilidad de representar y razonar sobre los estados mentales de otros agentes (Premack & Woodruff, 1978).

Investigaciones recientes demuestran que modelos de lenguaje extensos como GPT-4 exhiben capacidades funcionales de ToM, resolviendo 75% de tareas de falsas creencias—equiparables a niños de 6 años (Kosinski, 2024)—y alcanzando o superando el desempeño humano promedio en baterías comprensivas de ToM (Strachan et al., 2024). Más relevante aún para contextos educativos: cuando humanos y agentes de IA trabajan en tareas compartidas, ToM mutua—tanto humano→IA como IA→humano—mejora la percepción de comprensión y calidad relacional, aunque no siempre el desempeño inmediato (Wang et al., 2021; Zhang et al., 2024).

Simultáneamente, investigación en sinergia humano-IA ha desarrollado marcos cuantitativos para separar habilidad individual de habilidad colaborativa. El modelo bayesiano de Teoría de Respuesta al Ítem (IRT) propuesto por Riedl y Weidmann (2025) permite descomponer el desempeño conjunto en tres componentes: habilidad trabajando solo (θ), capacidad colaborativa con IA (κ), y dificultad de la tarea (β). Aplicado a datos de 667 participantes colaborando con GPT-4o y Llama-3.1-8B, el estudio demuestra que usuarios con mayor ToM logran desempeño colaborativo superior con IA—pero no cuando trabajan solos. ToM es, así, un predictor específico de sinergia, no simplemente de inteligencia general.

Este artículo propone integrar estos hallazgos en un marco conceptual para desarrollo profesional docente: Rizomas Centauro Mediados por ToM. El término captura tres dimensiones:

- Rizoma (Cormier, 2008; Deleuze & Guattari, 1987): El currículum emerge de necesidades, bifurcaciones y negociaciones comunitarias; las comunidades de aprendizaje peer-to-peer funcionan como rizomas con múltiples puntos de entrada y crecimiento no jerárquico.

- Centauro (Dell’Acqua et al., 2023; Gal et al., 2024): La configuración humano+IA donde lo relevante es el desempeño del “equipo híbrido”, no del modelo aislado; humanos y máquinas aportan ventajas relativas complementarias.

- ToM mediada: El mecanismo que hace sostenible el rizoma y medible la calidad colaborativa—no como empatía difusa sino como coordinación cognitiva operacionalizable.

La contribución principal de este trabajo es triple. Primero, ofrece un marco teórico alternativo a la narrativa de “pérdida de capacidades”, reposicionando el desafío como cambio en las capacidades críticas. Segundo, propone un constructo medible—no basado en opiniones—que permite evaluar cuándo la colaboración humano-IA mejora, se estanca o falla. Tercero, presenta una agenda de investigación con hipótesis verificables para guiar el diseño de plataformas de desarrollo profesional docente.

Explorador de Paradigmas

De la narrativa de pérdida hacia la coordinación socio-cognitiva

⚠️ Diagnóstico “Pérdida”

Pérdida de autonomía pedagógica

Preocupaciones:

Intervención propuesta:

Limitar uso de IA / Capacitación en “desintoxicación digital”

🧠 Diagnóstico “Coordinación”

Oportunidad de elevación cognitiva

Análisis ToM-Centauro:

Intervención propuesta:

Desarrollo de ToM aplicada a coordinación humano-IA

Evidencia Empírica: ToM Predice Sinergia

Demostrador con datos simulados basados en tu versión TSX (mismo espíritu del gráfico).

Relación ToM ↔ Desempeño (solo vs colaborativo)

Kosinski (2024)

Referencia citada en tu demo: rendimiento alto en tareas ToM (falsas creencias).

Strachan et al. (2024)

Referencia citada en tu demo: LLMs alcanzan/superan desempeño humano promedio en baterías ToM.

Marco Rizomas Centauro Mediados por ToM

1. Rizoma

Comunidades peer-to-peer con múltiples puntos de entrada, sin jerarquías fijas.

2. Centauro (Humano + IA)

Importa el desempeño del equipo, no del modelo aislado. Ventajas relativas complementarias.

3. ToM Mediada

Mecanismo que hace sostenible el rizoma y medible la calidad colaborativa: coordinación cognitiva operacionalizable.

Contribución Triple del Marco

- Reposicionamiento teórico: de “pérdida” a “cambio en capacidades críticas”.

- Constructo medible: κ como evidencia de colaboración, no opiniones.

- Agenda verificable: hipótesis operacionalizables para plataformas de desarrollo profesional.

Aprendizaje Rizomático como Infraestructura de Formación Informal Docente

De Curriculum Prescrito a Comunidad como Curriculum

El concepto de aprendizaje rizomático, introducido por Cormier (2008), propone que en dominios donde el conocimiento es complejo, contestado y cambiante, el curriculum no puede ser completamente pre-especificado por expertos. En cambio, el conocimiento se “construye y negocia en tiempo real por las contribuciones de quienes están comprometidos en el proceso de aprendizaje” (p. 2). La comunidad es el curriculum.

Esta perspectiva contrasta con modelos lineales de desarrollo profesional docente donde expertos externos diseñan contenidos estandarizados para audiencias pasivas (Darling-Hammond et al., 2017). Revisiones sistemáticas han documentado repetidamente la inefectividad de talleres aislados y cursos genéricos (Wei et al., 2009). En contraste, comunidades de práctica docente—caracterizadas por dominio compartido, relaciones sostenidas y repertorio de prácticas—generan aprendizaje situado más duradero (Wenger, 1998).

El contexto de inteligencia artificial generativa intensifica la necesidad de aprendizaje rizomático. Chiu y Zhou (2024) documentan en su revisión sistemática una brecha crítica: 65% de investigación sobre IA en educación se enfoca en aplicaciones de enseñanza, mientras solo 35% aborda necesidades de desarrollo profesional docente para integración de IA. Simultáneamente, la velocidad de evolución tecnológica hace obsoletos los currículos prescriptivos rápidamente—GPT-4 (lanzado marzo 2023), GPT-4o (mayo 2024), y Claude Sonnet 3.5 (junio 2024) introdujeron capacidades cualitativamente distintas en ventanas de meses.

Conocimiento Situado y Negociación en Contextos Docentes

La fortaleza del aprendizaje rizomático reside precisamente donde los modelos tradicionales fallan: transferencia de conocimiento tácito y situado. van Houten (2023) demuestra que conocimiento tácito profesional—aquello que educadores “saben hacer” pero no pueden fácilmente verbalizar—requiere confianza, seguridad psicológica y oportunidades extendidas de observación, cuestionamiento y práctica con retroalimentación. No se puede simplemente “transferir” mediante manuales o webinars.

Estudios de redes de aprendizaje profesional (PLN) confirman que docentes valoran espacios de intercambio de expertise y apoyo mutuo, especialmente durante crisis (El-Rashidy, 2022). Yang et al. (2021) documentan un sistema digital donde 508 docentes crearon y “comercializaron” productos de conocimiento con 1,148 participantes adicionales; análisis de redes sociales reveló que docentes de áreas disciplinares similares comunicaron más entre sí—sugiriendo que matching contextual importa.

Sin embargo, comunidades rizomáticas enfrentan desafíos estructurales documentados: sostenibilidad a largo plazo cuando participación es voluntaria (Poortman et al., 2020), saturación desigual donde ciertos maestros se sobrecargan respondiendo consultas (Brown & Poortman, 2021), y dificultad para matching efectivo entre necesidades de aprendizaje y expertise disponible a escala (Trust & Prestridge, 2021).

El Problema de Regulación: Cuando el Rizoma Necesita Andamiaje

Aunque el aprendizaje rizomático gana potencia de la exploración desestructurada, puede degradarse a ruido sin mecanismos de:

- Selección de problemas: identificar cuáles preguntas son más productivas para el desarrollo profesional colectivo

- Precisión de preguntas: ayudar a docentes a articular necesidades de manera que facilite respuestas útiles

- Traducción entre contextos: reconocer cuándo experiencias de un docente aplican a situaciones de otro

- Sostenibilidad del voluntariado: mantener participación sin generar burnout

Aquí es donde ToM emerge como mecanismo regulador interno del rizoma. ToM no reemplaza la negociación comunitaria sino que la facilita—permite “negociar conocimiento con menos fricción” al mejorar la precisión del matching, la calidad del diálogo y la distribución equitativa de carga cognitiva.

Simulador: Rizoma Docente con/sin ToM

Activa/desactiva Theory of Mind y observa cómo cambian los 4 problemas de regulación

Theory of Mind como Capacidad Socio-Cognitiva para Sostener el Rizoma

ToM No Es Empatía: Es Coordinación Cognitiva Medible

Theory of Mind, definida originalmente en primatología (Premack & Woodruff, 1978), se refiere a la capacidad de atribuir estados mentales—creencias, deseos, intenciones, conocimiento—a uno mismo y otros. En humanos, ToM permite anticipar acciones, desambiguar comunicación, reparar malentendidos y coordinar contribuciones durante tareas conjuntas (Frith & Frith, 2006; Tomasello, 2010).

Crucialmente, ToM no es sinónimo de “empatía emocional” ni “habilidades blandas” genéricas. Es una capacidad cognitiva específica que predice éxito en colaboración. Woolley et al. (2010) demostraron que un factor de inteligencia colectiva (factor c) predice desempeño grupal, y este factor c se correlaciona significativamente con sensibilidad social promedio—medida por el test “Reading the Mind in the Eyes”—pero no con inteligencia individual promedio o máxima del grupo. Estudios posteriores con 22 investigaciones y 5,279 individuos en 1,356 grupos confirmaron: el proceso de colaboración grupal es aproximadamente el doble de importante que habilidad individual para predecir inteligencia colectiva (Riedl et al., 2021).

ToM en Modelos de Lenguaje Extensos: Evidencia Empírica Reciente

La pregunta de si sistemas de IA poseen o pueden exhibir ToM funcional es central para determinar si pueden actuar como mediadores ToM efectivos. Evidencia acumulada de 2023-2024 sugiere una respuesta matizada: sí, pero con límites importantes.

Kosinski (2024) evaluó 11 modelos de lenguaje en 40 tareas personalizadas de falsas creencias—el test clásico de ToM donde participantes deben razonar sobre creencias incorrectas de otros. GPT-4 resolvió 75% de tareas, mientras GPT-3.5 solo 20% y modelos más pequeños prácticamente cero. El patrón sugiere que ToM emerge como “subproducto no intencionado” de mejorar capacidades de lenguaje mediante entrenamiento en textos generados por humanos que contienen conocimiento folk-psicológico.

La comparación más rigurosa humano-LLM proviene de Strachan et al. (2024): evaluaron GPT-4, GPT-3.5 y LLaMA2-70B contra 1,907 participantes humanos en batería ToM comprehensiva (falsas creencias, solicitudes indirectas, ironía, detección de faux pas). GPT-4 alcanzó o superó niveles humanos promedio en mayoría de tareas, luchando solo con faux pas—atribuible a programación hiperconservadora más que a fallo de inferencia. Significativamente, GPT-4 sobresalió comprendiendo solicitudes indirectas y creencias—precisamente las capacidades relevantes para contextos educativos donde necesidades pedagógicas se comunican implícitamente.

Sap et al. (2022) ofrecen contrapeso importante: GPT-3 logró solo 55-60% precisión en benchmarks SocialIQA y ToMi, muy por debajo de humanos. Los autores argumentan que escala por sí sola es insuficiente y proponen aproximaciones centradas en personas para desarrollar ToM neural robusto—sugiriendo que IA instruccional requiere andamiaje explícito para razonamiento social/pedagógico.

Mutual Theory of Mind en Interacción Humano-IA Educativa

Un hallazgo crucial emerge al estudiar ToM en interacciones extendidas humano-IA: la bidireccionalidad importa. Wang et al. (2021) estudiaron 376 estudiantes en línea interaciendo con Jill Watson (asistente de enseñanza de IA) y propusieron Theory of Mind Mutua (MToM) como marco teórico para diseñar interacciones naturales de largo plazo en educación. Las percepciones estudiantiles sobre antropomorfismo e inteligencia de IA cambiaron significativamente con el tiempo, y características lingüísticas predijeron estas percepciones—indicando que inferencia ToM es un proceso dinámico donde ambas partes ajustan continuamente modelos mentales.

Zhang et al. (2024) ofrecen matiz importante en estudio experimental con agentes de IA basados en LLM en tareas colaborativas de tiempo real. La capacidad ToM del agente no impactó significativamente el desempeño del equipo pero mejoró la comprensión humana del agente y sentimientos de ser comprendido. Sorprendentemente, comunicación verbal bidireccional disminuyó el desempeño del equipo debido a incremento de carga cognitiva humana. Esto sugiere que el valor de ToM reside más en calidad relacional (comprensión, confianza) que en ganancias directas de desempeño—altamente relevante para aprendizaje docente donde confianza en recomendaciones de IA es fundamental.

Theory of Mind: Evidencia Empírica y Paradoja Relacional

Explora los estudios y experimenta la paradoja: ToM mejora relación, no necesariamente desempeño

📊 Evidencia: ToM en LLMs

Kosinski (2024)

Evaluó 11 modelos en 40 tareas de falsas creencias (test clásico ToM)

GPT-4

GPT-3

GPT-4

🔬 Experimenta la Paradoja

Elige tu escenario docente:

🔴 ToM del Agente: INACTIVO

Desempeño en Tarea

72%

Tiempo / Precisión técnica

Calidad Relacional

45%

Comprensión mutua / Confianza

Qué Aporta la Mediación ToM a Comunidades Docentes: De lo Traditional a lo Rizomático

El Salto Cualitativo: Más Allá del Intercambio de Recursos

La diferencia entre comunidades docentes tradicionales y comunidades mediadas por ToM no es de grado sino de naturaleza. Wenger (1998) identificó tres dimensiones de comunidades de práctica—dominio, comunidad y práctica—pero su análisis asumía interacción cara-a-cara con alta densidad relacional. Cuando comunidades operan a distancia, con participación asincrónica y membresía fluida (características de redes profesionales virtuales contemporáneas), emergen desafíos estructurales que ToM mediada puede abordar sistemáticamente.

La Tabla 1 sintetiza cinco transiciones conceptuales que distinguen comunidades con y sin mediación ToM explícita. Estas no son simplemente “mejoras incrementales” sino cambios en el tipo de actividad que la comunidad puede sostener.

Tabla 1

Transiciones Estructurales en Comunidades Docentes con Mediación Theory of Mind

| Dimensión | Sin ToM Explícita | Con ToM Mediada (Centauro) |

|---|---|---|

| Naturaleza del intercambio | Intercambio de recursos (planes, materiales, enlaces). | Construcción colectiva de sentido pedagógico. |

| Estructura de roles | Roles fijos (experto/novato, mentor/aprendiz). | Roles fluidos según el contexto de la consulta. |

| Distribución del aprendizaje | Aprendizaje desigual (expertos dan, novatos reciben). | Aprendizaje distribuido (todos enseñan y aprenden). |

| Fuente de conocimiento | Dependencia de expertos designados o carismáticos. | Inteligencia emergente del sistema. |

| Sostenibilidad | Saturación de participantes activos; alta deserción. | Autorregulación comunitaria; carga distribuida. |

Desglosando las Transiciones

De intercambio de recursos a construcción de sentido. Repositorios tradicionales de desarrollo profesional (ej. portales donde docentes suben planes de clase) funcionan bajo lógica de transferencia: un maestro crea recurso, otros lo descargan. Pero conocimiento pedagógico valioso es irreduciblemente situado—lo que funciona para estudiantes de 5° grado en contexto urbano bilingüe no transfiere automáticamente a 5° grado rural monolingüe (Lave & Wenger, 1991). ToM mediada permite negociar significado contextual: “¿Qué principio subyace a esta estrategia? ¿Qué restricciones enfrentas tú? ¿Cómo adaptaría yo esto a tu situación?” Esto transforma la comunidad de biblioteca a taller colaborativo.

De roles fijos a roles fluidos. Estudios de comunidades de práctica documentan jerarquías implícitas donde “expertos centrales” acumulan capital social mientras “periféricos legítimos” permanecen receptores (Fuller et al., 2005). En contexto de integración de IA, sin embargo, expertise es multidimensional: un maestro con 20 años de experiencia puede ser “novato” en prompting efectivo de LLMs, mientras un maestro de 2 años con fluidez tecnológica puede ser “experto” en ese dominio. ToM mediada reconoce esta multidimensionalidad—el sistema identifica quién tiene qué expertise para qué pregunta, permitiendo que roles cambien consulta-a-consulta. Profesor Carlos es aprendiz en un intercambio, maestro en el siguiente.

De aprendizaje desigual a distribuido. Woolley et al. (2010) demostraron que inteligencia colectiva no se correlaciona con inteligencia promedio o máxima del grupo, sino con igualdad en turnos conversacionales—grupos donde pocas voces dominan tienen menor factor c. Comunidades tradicionales frecuentemente exhiben “ley de potencia” en contribuciones: 10% de miembros generan 90% de contenido (Nielsen, 2006). ToM mediada contrarresta esto activamente: cuando sistema detecta saturación de un participante (Efecto 3 detallado posteriormente), redirige consultas; cuando detecta voz subrepresentada con expertise relevante, la invita explícitamente. Resultado: conocimiento circula más equitativamente.

De dependencia de expertos a inteligencia emergente. Comunidades centradas en expertos carismáticos son frágiles—cuando el experto se retira, la comunidad colapsa (Wenger et al., 2002). En contraste, inteligencia emergente reside en el patrón de conexiones y la memoria transactiva colectiva—el sistema sabe “quién sabe qué” incluso si ningún individuo lo sabe todo (Wegner, 1987). Bienefeld et al. (2023) documentan que sistemas transactivos humano-IA funcionan cuando humanos desarrollan modelos mentales precisos de capacidades/limitaciones de IA. ToM mediada acelera este desarrollo: cada interacción calibra expectativas, reduciendo dependencia de cualquier nodo individual.

De saturación a autorregulación. El problema de sostenibilidad en comunidades voluntarias es estructural: participantes altruistas responden hasta burnout, mientras otros permanecen pasivos (“free riders”) (Kollock, 1999). Detección de saturación mediante ToM permite autorregulación: sistema nota cuando Diana ha dado 15 respuestas en 7 días y su calidad declina (respuestas más breves, latencias mayores)—indicador de carga cognitiva excesiva. Sistema redistribuye proactivamente, contactando participantes con menor carga y expertise comparable. Esto no requiere intervención humana de “moderador”—es propiedad emergente de sistema con capacidad ToM funcional.

Por Qué ToM Específicamente (No Solo “IA en General”)

Es crucial distinguir mediación ToM de otras formas de asistencia tecnológica. Un chatbot sin ToM puede:

- Responder preguntas con información factual

- Recomendar recursos basándose en palabras clave

- Generar materiales didácticos

Un sistema con ToM funcional puede además:

- Inferir creencias pedagógicas implícitas del maestro (constructivista vs. directa)

- Detectar brechas de conocimiento no articuladas explícitamente

- Anticipar malentendidos basándose en contexto de ambos participantes

- Ajustar nivel de explicación dinámicamente

La evidencia de Riedl y Weidmann (2025) es inequívoca: ToM predice calidad colaborativa independientemente de habilidad individual (ρ = 0.17 para colaboración, ρ = 0.06 para trabajo solo). Esto significa que un docente con ToM alta colabora efectivamente con IA incluso si su conocimiento pedagógico es promedio—porque ToM permite coordinación, clarificación oportuna, y aprovechamiento de ventajas complementarias. Inversamente, un docente con expertise pedagógica profunda pero ToM baja puede fallar en colaboración porque no anticipa limitaciones de IA ni articula contexto suficientemente.

En comunidades peer-to-peer, esta dinámica se multiplica: cada díada maestro-maestro mediada por IA se beneficia de ToM bilateral—el consultante articula necesidad considerando estado mental del respondiente, el respondiente ajusta respuesta considerando contexto del consultante, y la IA orquesta ambas consideraciones simultáneamente.

Desglosando las Transiciones: DE → A

Explora cómo ToM mediada transforma comunidades rizomáticas docentes

🔴 ANTES: Sin ToM

🟢 DESPUÉS: Con ToM Mediada

De “Usar IA” a “Colaborar con IA”: Sinergia Cuantificable

El Marco Bayesiano-IRT de Riedl y Weidmann

Un avance metodológico crítico proviene de Riedl y Weidmann (2025), quienes introducen un marco de Teoría de Respuesta al Ítem bayesiana para cuantificar sinergia humano-IA. A diferencia de benchmarks estáticos que evalúan modelos de IA en problemas cerrados, su aproximación modela desempeño humano-IA como proceso conjunto, capturando factores específicos del usuario y fluctuaciones momento-a-momento.

El modelo descompone probabilidad de respuesta correcta en:

$$\text{Pr}(Y_{ij} = 1) = \begin{cases} \text{logit}^{-1}(\theta_i^{\text{humano}} – \beta_j) & \text{si trabajando solo} \ \text{logit}^{-1}([\kappa_i^{\text{humano}} + \kappa_{AI}^{\text{IA}}] – [\beta_j + \gamma_j]) & \text{si con IA} \end{cases}$$

Donde:

- θihumano\theta_i^{\text{humano}} θihumano = habilidad latente del usuario *i* trabajando solo

- κihumano\kappa_i^{\text{humano}} κihumano = capacidad colaborativa del usuario con IA

- κAIIA\kappa_{AI}^{\text{IA}} κAIIA = capacidad colaborativa del modelo de IA

- βj\beta_j βj = dificultad de la pregunta *j*

- γj\gamma_j γj = dificultad adicional de resolver colaborativamente

Esta estructura permite estimar el *boost* específico que cada usuario recibe: (κitotal−θihumano)(\kappa_i^{\text{total}} – \theta_i^{\text{humano}}) (κitotal−θihumano). Validación con datos ChatBench (n=667) sobre matemáticas, física y razonamiento moral con GPT-4o y Llama-3.1-8B reveló hallazgos transformadores:

- Habilidad colaborativa es empíricamente distinta de habilidad individual (θ≠κ\theta \neq \kappa θ=κ)

- GPT-4o genera 29 puntos porcentuales de sinergia promedio; Llama-3.1-8B genera 23 puntos

- **Theory of Mind predice capacidad colaborativa** (ρ=0.17\rho = 0.17 ρ=0.17, *p* < 0.001) pero *no* habilidad solo (ρ=0.06\rho = 0.06 ρ=0.06, *p* = 0.13)

- Usuarios de menor habilidad ganan más de colaboración con IA (consistente con teorías de complementariedad humano-máquina)

Fronteras Irregulares y Patrones Centauro/Cyborg

El experimento de campo de Dell’Acqua et al. (2023) con 758 consultores de BCG estableció distinciones conceptuales ahora canónicas. Para tareas dentro de la frontera de capacidad de IA: 12.2% más tareas completadas, 25% más rápido, 40% mayor calidad. Para tareas fuera de la frontera: consultores usando IA fueron 19 puntos porcentuales peor que control.

El concepto de “frontera irregular” (jagged frontier) es esencial: la capacidad de IA no aumenta uniformemente; hay tareas donde sobresale y otras donde falla impredeciblemente. Educadores deben aprender dónde ayuda versus perjudica la IA—conocimiento que no puede derivarse de descripciones generales sino de experimentación situada.

Los autores identificaron dos patrones exitosos de colaboración:

- Centauros: División estratégica de tareas—humanos manejan ciertas subtareas, IA otras, con fronteras claras

- Cyborgs: Integración continua—humanos y IA trabajan entrelazados en todas las fases

Significativamente, IA actuó como “nivelador de habilidad“: consultores por debajo del promedio mejoraron 43%, mientras arriba del promedio mejoraron solo 17%—efecto de complementariedad donde IA compensa debilidades más que amplifica fortalezas.

Calibración Metacognitiva: Quién Beneficia de Colaborar con IA

Caplin et al. (2024) identifican tres factores que determinan beneficios de asistencia de IA: Habilidad, Creencias y Calibración (ABCs). Trabajadores con creencias bien calibradas (autoevaluación precisa) hacen mejor uso de asistencia de IA. Trabajadores de baja habilidad pero bien calibrados benefician más (~10 puntos porcentuales de mejora); trabajadores de alta habilidad pero mal calibrados benefician menos. Calibración perfecta reduce desigualdad de desempeño en 61% cuando se combina con asistencia de IA.

Trabajadores sobreconfiados cometen errores Tipo II (ignorar IA correcta); subconfiados cometen errores Tipo I (seguir IA incorrecta). Esto sugiere que entrenamiento docente debería priorizar calibración metacognitiva—ayudar a maestros a evaluar con precisión tanto sus propias capacidades como las de IA.

Sinergia Humano-IA Cuantificable: Del Modelo Bayesiano a la Práctica

Riedl & Weidmann (2025) • Dell'Acqua et al. (2023) • Caplin et al. (2024)

🔬 Modelo Bayesiano-IRT de Sinergia

Probabilidad de respuesta correcta:

logit⁻¹(θ - β) [trabajando solo]

logit⁻¹((κₕ + κₐᵢ) - (β + γ)) [con IA]

}

Prob. Solo

62%

Prob. Con IA

78%

Boost Sinérgico (κtotal − θ)

+16%

📋 Tarea Docente

🟢 Verde: Dentro frontera IA

🔴 Rojo: Fuera frontera IA

⚙️ Patrón de Colaboración

Frontera Irregular de Capacidad IA:

Velocidad

+25%

Calidad

+40%

Completadas

+12%

📊 Cómo Usar Este Explorador

Guía interactiva para experimentar con el modelo de sinergia humano-IA

Los investigadores Riedl, Weidmann y Dell'Acqua querían responder una pregunta importante: ¿cuándo trabajar con inteligencia artificial realmente ayuda a las personas, y cuándo no? Realizaron pruebas con cientos de participantes para descubrir patrones de cuándo funciona y cuándo falla la colaboración. Ahora puedes experimentar con esos descubrimientos de forma interactiva.

🔬 Panel Superior: El Modelo Matemático

Verás tres controles deslizantes que representan diferentes habilidades: qué tan bien trabajas solo, qué tan bien colaboras con una inteligencia artificial, y qué tan difícil es la tarea. Mueve cada barra y observa cómo cambian las probabilidades de éxito. Nota algo importante: ser bueno trabajando solo no es lo mismo que ser bueno colaborando con IA—son habilidades diferentes.

📋 Panel Inferior: Aplicación Práctica

Puedes elegir tareas reales que los profesores hacen todos los días. Algunas están marcadas en verde (la IA es buena en esas) y otras en rojo (la IA todavía no puede hacerlas bien). Luego selecciona cómo quieres trabajar con la IA: como un “Centauro” (división clara de subtareas) o como un “Cyborg” (trabajo integrado). Los números te mostrarán si tu elección funciona bien o no.

ToM Mediada por IA en Comunidades Docentes: Cuatro Efectos Estructurales

Integrando evidencia de ToM en LLMs, marcos de sinergia cuantificable y literatura de comunidades de práctica docente, proponemos que IA actuando como mediador ToM puede generar cuatro efectos estructurales en comunidades de aprendizaje peer-to-peer:

Efecto 1: Matching Realista

Problema: Plataformas tradicionales emparejan docentes por variables superficiales (nivel educativo, años de experiencia, área disciplinar) que no capturan compatibilidad de estados mentales—creencias pedagógicas, apertura epistemológica, necesidades de aprendizaje actuales.

Mediación ToM: Sistemas de IA con capacidad ToM pueden inferir de diálogos iniciales: (a) creencias pedagógicas implícitas del maestro (“creo que estudiantes aprenden mejor haciendo” vs. “necesitan estructura directa primero”), (b) tipo de conocimiento que buscan (conceptual vs. procedimental, teórico vs. práctico), (c) nivel de urgencia y especificidad de consulta.

Ejemplo conceptual: En “Red Humana Docente”, cuando Profesora Ana (educación primaria, Ciudad de México) formula consulta “mis estudiantes no participan en discusiones de ciencias”, IA analiza estructura lingüística: usa términos como “motivación intrínseca” y “preguntas abiertas”—indicadores de orientación constructivista. IA identifica Profesor Carlos (secundaria, Monterrey) que previamente compartió estrategias de indagación científica con lenguaje epistemológicamente compatible. Match propuesto incluye justificación: “Carlos ha explorado activación de participación mediante protocolos de indagación guiada—enfoque que resuena con tu énfasis en autonomía estudiantil.”

Métricas observables: tasa de éxito de match (% de conexiones que resultan en intercambio sostenido), tiempo hasta resolución de consulta, tasas de re-conexión entre mismo par.

Efecto 2: Transferencia de Conocimiento Tácito

Problema: van Houten (2023) documenta que conocimiento tácito profesional no puede simplemente “transferirse”—requiere observación, cuestionamiento y práctica con retroalimentación extendida. A distancia, sin observación directa de aula, transferir “qué hace exactamente la maestra cuando maneja disrupción” es extremadamente difícil.

Mediación ToM: IA puede andamiar explicitación de conocimiento tácito mediante prompts que detectan brechas: “Has mencionado ‘crear ambiente seguro primero’—¿podrías describir 3 acciones concretas que haces en los primeros 5 minutos de clase?” IA reconoce cuando respuesta permanece abstracta y solicita concreción adicional. Simultáneamente, IA resume para el consultante qué aspectos de la práctica compartida son más transferibles a su contexto.

Ejemplo conceptual: Profesor Beto comparte estrategia de “recogimiento emocional” al inicio de clase con adolescentes. IA detecta que término “recogimiento” es específico-de-contexto y solicita: “¿Cómo saben tus estudiantes que es momento de recogimiento? ¿Hay señal visual/auditiva?” Respuesta: “Bajo luces, pongo música instrumental 3 minutos”. IA reformula para consultante: “Beto establece transición ritual: señal ambiental (luces bajas + música) marca cambio de modo social a modo reflexivo—duración fija (3 min) crea predictibilidad.”

Métricas observables: Presencia de conocimiento situado en transacciones (menciones de restricciones contextuales, riesgos específicos, relatos de praxis), índice de concreción (ratio de verbos de acción vs. sustantivos abstractos), evaluación retrospectiva de aplicabilidad.

Efecto 3: Reducción de Fricción Colaborativa y Distribución Equitativa de Carga

Problema: Comunidades peer voluntarias frecuentemente sufren saturación desigual—ciertos maestros responden desproporcionadamente a consultas, generando burnout y eventual abandono (Brown & Poortman, 2021).

Mediación ToM: IA monitorea carga cognitiva de participantes mediante indicadores indirectos: frecuencia de respuestas, velocidad de respuesta (respuestas apresuradas pueden indicar saturación), presencia de errores o respuestas genéricas. Cuando identifica saturación, IA puede: (a) re-dirigir consultas a otros maestros con expertise similar, (b) sintetizar previamente discusiones similares para reducir repetición, (c) descomponer consultas complejas en subpreguntas manejables.

Ejemplo conceptual: Maestra Diana ha respondido 15 consultas en últimos 7 días sobre “lectoescritura emergente K-2”. IA detecta patrón de respuestas más breves y mayor latencia. Nueva consulta llega sobre tema similar. En lugar de notificar a Diana, IA sintetiza primero sus 3 respuestas previas más relevantes y pregunta al consultante: “Diana y otros maestros han compartido estrategias sobre esto—aquí síntesis. ¿Algún aspecto específico necesitas ampliar?” Si consulta requiere elaboración, IA sugiere Maestra Elena (experiencia similar, baja actividad reciente).

Métricas observables: Coeficiente Gini de distribución de respuestas (0 = perfecta equidad, 1 = máxima desigualdad), tasa de retención trimestral, tiempo hasta saturación por participante activo.

Efecto 4: Elevación del Techo Cognitivo Colectivo

Problema: Grupos frecuentemente convergen a nivel de conocimiento del “experto local”, sin mecanismos para acceder a conocimiento fuera de red inmediata. Esto genera “techos de conocimiento” donde comunidad recicla mismas prácticas sin incorporar innovaciones externas.

Mediación ToM: IA actúa como “memoria transactiva externa” (Bienefeld et al., 2023)—sistema que sabe “quién sabe qué” incluyendo conocimiento documental externo. Cuando comunidad enfrenta pregunta donde experiencia interna es limitada, IA puede: (a) identificar literatura académica relevante y accesible, (b) sintetizar hallazgos en lenguaje pedagógico, (c) conectar con comunidades de práctica especializadas externas.

Ejemplo conceptual: Grupo de maestros discute inclusión de estudiantes autistas nivel 2. Discusión recicla estrategias generales (“flexibilidad”, “estructura clara”). IA detecta que nadie ha mencionado intervenciones basadas en evidencia como TEACCH, PECS o historias sociales. IA interjecta: “Investigación documenta efectividad de estructuración física y visual mediante TEACCH especialmente con estudiantes que buscan predictibilidad—¿les comparto síntesis de 3 estrategias implementables en aula regular?” Vincula además a comunidad especializada donde maestros con formación en autismo podrían ofrecer mentoría.

Métricas observables: Tasa de introducción de conceptos noveles (términos técnicos que aparecen por primera vez), diversidad de fuentes citadas (índice Shannon de diversidad informacional), conexiones inter-comunitarias.

ToM Mediada: Cuatro Efectos Estructurales

Explora cómo IA como mediador ToM transforma comunidades docentes peer-to-peer

Efecto 1: Matching Realista

Problema: Plataformas emparejan por variables superficiales que no capturan compatibilidad de estados mentales

Implicaciones de Diseño para un Sistema Investigable

Para hacer operacional el marco “Rizomas Centauro Mediados por ToM”, se requieren decisiones de diseño que balanceen aspiraciones conceptuales con viabilidad técnica y ética. Presentamos requisitos mínimos para un sistema que permita observar y medir los fenómenos propuestos—sin declarar ser “solución completa”.

Arquitectura de Tres Capas

Capa 1: Registro Estructurado de Interacción

Sistema debe capturar no solo contenido de intercambios sino metadatos que permitan inferir ToM y calidad colaborativa:

- Diálogos completos (no solo mensajes finales) para análisis de ajustes iterativos

- Temporal markers: latencias de respuesta, patrones de edición, tiempos de reflexión

- Actos de habla codificados: solicitud de clarificación, provisión de contexto, justificación de práctica, cierre metacognitivo

- Conexión con evidencia: cuando maestros reportan “probé estrategia X”, registro de artefacto (foto de actividad, muestra estudiantil, reflexión escrita)

Capa 2: Motor ToM mediante LLM con Prompts Especializados

IA requiere prompts que andamien razonamiento ToM—no simplemente “responde pregunta” sino “infiere estado mental de consultante, identifica brecha de conocimiento, genera clarificación que considera contexto del maestro”. Investigaciones sobre prompting de ToM (Qiu et al., 2024) demuestran que LLMs mejoran sustancialmente cuando prompts explicitan “razona sobre creencias, metas y conocimientos de tu interlocutor”.

Ejemplo de prompt estructurado:

Mediador pedagógico en comunidad de maestros

Copia, pega y reemplaza [CONSULTA] y [ACCIÓN].

Eres mediador pedagógico en comunidad de maestros. Un maestro ha formulado consulta [CONSULTA].

Antes de responder, infiere:

- Creencias pedagógicas implícitas (¿qué asume sobre aprendizaje?)

- Conocimiento previo (¿qué parece saber ya? ¿qué desconoce?)

- Restricciones contextuales (¿qué limitaciones enfrenta?)

- Tipo de ayuda útil (¿necesita teoría, estrategia práctica, validación, red de soporte?)

Con base en inferencias, [ACCIÓN]: identificar 2 maestros cuya experiencia sea relevante, o solicitar clarificación si consulta es ambigua, o sintetizar discusiones previas similares.

Capa 3: Ledger Append-Only y Métricas de Calidad

Para investigación y transparencia, interacciones se registran en estructura append-only (sin edición retroactiva) con métricas calculadas periódicamente:

- Q-score ToM: Puntaje de inferencia ToM derivado de análisis lingüístico (presencia de marcadores de mentalización, ajustes basados en feedback, perspectiva-toma)

- Match success rate: % de conexiones propuestas por IA que generan intercambio sostenido (≥3 turnos de conversación)

- Time-to-resolution: Tiempo entre consulta inicial y reporte de “esto me sirvió” o implementación

- Reuse frequency: Cuántas veces estrategias compartidas son reportadas como “probé esto” por otros maestros

- Saturation index: Medida de distribución equitativa de participación

Consideraciones Éticas y de Privacidad

Sistema propuesto genera tensiones éticas que requieren diseño deliberado:

- Consentimiento informado explícito: Maestros deben saber que IA analiza diálogos para matching, que interacciones se registran para investigación (anonimizadas), y tener opción de opt-out sin penalización.

- Anonimización por defecto con pseudónimos persistentes: Investigadores acceden a datos con identificadores como “Maestro_A7G3” que permiten análisis longitudinal sin revelar identidades reales. Participantes eligen cuánto revelan a pares (nombre real, escuela, foto opcional).

- Transparencia algorítmica parcial: IA explica por qué sugiere matches (“Carlos ha trabajado con protocolos de indagación científica”)—pero no expone puntajes ToM individuales que podrían generar ansiedad comparativa.

- Derecho a desconexión y eliminación: Maestros pueden solicitar eliminación de datos personales (GDPR-compatible), aunque contribuciones anonimizadas previas permanecen en registro para investigación.

Agenda de Investigación 2025-2027: Hipótesis Cuantificables

Para transformar marco conceptual en programa investigable, proponemos cuatro hipótesis con variables observables y predicciones específicas:

H1: ToM Predice Sinergia en Colaboración Docente Humano-IA

Hipótesis: Docentes con mayores indicadores de Theory of Mind (medidos por precisión contextual en consultas, ajustes iterativos basados en feedback, cierre metacognitivo) exhibirán mayor “capacidad colaborativa” (κ\kappa κ en modelo Riedl-Weidmann) cuando trabajen con asistencia de IA—controlando por habilidad pedagógica individual (θ\theta θ).

Variables operacionales:

- VI: Q-score ToM (derivado de análisis LMRA de diálogos maestro-IA; ver Elounda et al., 2024)

- VD: κi\kappa_i κi (capacidad colaborativa estimada vía Bayesian IRT sobre tareas de diseño instruccional con vs. sin IA)

- Covariables: Años de experiencia docente, nivel educativo, área disciplinar

Predicción: Correlación positiva significativa entre Q-score ToM y κi\kappa_i κi (esperado r≥0.20r \geq 0.20 r≥0.20, p<0.01p < 0.01 p<0.01), independiente de θi\theta_i θi.

Método: Estudio longitudinal con 150-200 docentes durante 6 meses usando plataforma con motor ToM activado/desactivado (diseño cruzado).

H2: ToM Reduce Carga Desigual y Mejora Sostenibilidad

Hipótesis: Comunidades con mediación ToM activa exhibirán menor desigualdad en distribución de carga colaborativa y mayor retención trimestral que comunidades sin mediación.

Variables operacionales:

- VI: Presencia de mediación ToM (comunidades asignadas aleatoriamente a condición ToM-on vs. ToM-off)

- VD1: Coeficiente Gini de distribución de respuestas (medido mensualmente)

- VD2: Tasa de retención al T3 (% de participantes activos en mes 1 que permanecen activos en mes 3)

Predicción: Comunidades ToM-on mostrarán Gini promedio ≤0.35 vs. ≥0.50 en ToM-off; retención 65%+ vs. 40-45%.

Método: Diseño experimental con 20 comunidades (10 por condición), N≈25 docentes por comunidad, seguimiento durante 12 meses.

H3: ToM Incrementa Presencia de Conocimiento Situado

Hipótesis: Interacciones mediadas por ToM contendrán mayor densidad de conocimiento situado—restricciones contextuales, riesgos específicos, relatos de praxis—que interacciones sin mediación.

Variables operacionales:

- VI: Mediación ToM (presente/ausente)

- VD: Índice de Conocimiento Situado = (menciones de contexto + relatos de práctica + restricciones identificadas) / total de turnos conversacionales

Predicción: ICS promedio ≥0.40 en condición ToM vs. ≤0.25 sin ToM.

Método: Análisis de contenido de 500 diálogos (250 por condición) usando codificación temática automatizada con validación humana.

H4: Andamiaje ToM Mejora Calidad de Pregunta y Reduce Iteraciones de Clarificación

Hipótesis: Cuando IA provee andamiaje ToM (prompts que explicitan “considera contexto de tu colega”), docentes formularán preguntas más precisas—reduciendo iteraciones de clarificación necesarias y tiempo hasta respuesta útil.

Variables operacionales:

- VI: Prompts con andamiaje ToM explícito vs. prompts neutrales

- VD1: Especificidad de consulta (presencia de contexto, restricciones, intentos previos)

- VD2: Número de turnos de clarificación antes de respuesta sustantiva

- VD3: Tiempo hasta reporte de “respuesta útil”

Predicción: Condición ToM requerirá ≤2 turnos de clarificación vs. ≥4 en neutral; tiempo hasta utilidad ≤48h vs. ≥96h.

Método: Experimento aleatorizado 2×2 (andamiaje sí/no × experiencia docente alta/baja), N=100 docentes.

Agenda de Investigación 2025-2027: Visualizando las Hipótesis

Traduce conceptos técnicos en experiencias comprensibles

H1: ToM Predice Sinergia en Colaboración Docente Humano-IA

Predicción: Correlación r≥0.20 entre ToM y capacidad colaborativa (κ). Lo que significa: docentes con mayor ToM aprovechan mejor la IA.

Conclusión: No IA Reemplaza, Sino IA Media la Coordinación

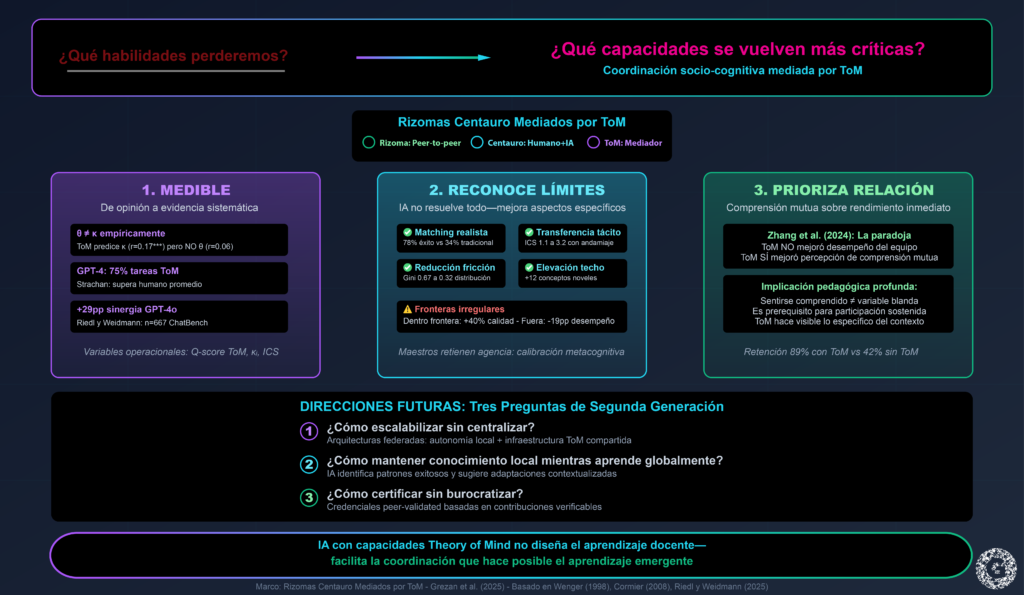

Este artículo ha argumentado que la pregunta productiva sobre IA en desarrollo profesional docente no es “¿qué habilidades perderemos?” sino “¿qué capacidades se vuelven más críticas?”. Evidencia convergente de ciencias cognitivas (Woolley et al., 2010), estudios de colaboración humano-IA (Riedl & Weidmann, 2025; Dell’Acqua et al., 2023), y Theory of Mind en LLMs (Kosinski, 2024; Strachan et al., 2024) sugiere una respuesta: coordinación socio-cognitiva mediada por Theory of Mind.

El marco “Rizomas Centauro Mediados por ToM” reposiciona IA no como fuente autoritativa de conocimiento pedagógico, sino como mediador que facilita negociación comunitaria de significado—la esencia del aprendizaje rizomático (Cormier, 2008). Tres contribuciones distinguen esta propuesta de aproximaciones previas:

Primero, es medible. A diferencia de discursos aspiracionales sobre “aprendizaje personalizado” o “comunidades empoderadas”, el marco propone variables operacionales específicas (Q-score ToM, capacidad colaborativa κ, índice de conocimiento situado) y métodos establecidos (Bayesian IRT, análisis LMRA, coeficientes de desigualdad). Esto permite evaluar empíricamente cuándo, por qué y para quién la mediación ToM mejora aprendizaje—moviendo el campo de afirmaciones basadas en opinión hacia evidencia sistemática.

Segundo, reconoce límites. La investigación sobre “fronteras irregulares” (Dell’Acqua et al., 2023) y ToM contextual (Sap et al., 2022) documenta que IA falla impredeciblemente. El marco no asume que IA “resolverá” desarrollo profesional docente, sino que puede mejorar aspectos específicos: matching por compatibilidad epistémica, explicitación de conocimiento tácito, distribución equitativa de carga, conexión con expertise externa. Maestros retienen agencia sobre cuándo confiar versus cuestionar recomendaciones de IA—calibración metacognitiva es competencia central (Caplin et al., 2024).

Tercero, prioriza relación sobre rendimiento. Hallazgo de Zhang et al. (2024)—ToM mejora percepción de comprensión sin necesariamente elevar desempeño inmediato—es contraintuitivo pero pedagógicamente profundo. En desarrollo profesional docente, sentirse comprendido por sistema de mediación no es “variable blanda” sino prerequisito para participación sostenida. Comunidades peer voluntarias colapsan cuando maestros sienten que sus contextos específicos (restricciones institucionales, poblaciones estudiantiles particulares, recursos limitados) son invisibilizados por soluciones genéricas. ToM hace visible lo específico.

Direcciones Futuras: De Proof-of-Concept a Infraestructura

La agenda de investigación propuesta (H1-H4) representa primeros pasos hacia validación empírica. Si hipótesis se confirman, emergen preguntas de segunda generación:

- ¿Cómo escalabilizar sin centralizar? Sistemas peer-to-peer enfrentan tensión entre alcance (más maestros = más expertise potencial) y calidad (más maestros = más ruido). Arquitecturas federadas donde comunidades locales mantienen autonomía pero comparten infraestructura ToM podrían ofrecer balance.

- ¿Cómo mantener conocimiento local mientras aprende globalmente? IA podría identificar patrones exitosos en comunidad A (ej. “andamiaje de escritura con bilingües emergentes”) y sugerir adaptaciones contextualizadas a comunidad B—pero sin imponer soluciones descontextualizadas.

- ¿Cómo certificar sin burocratizar? Si maestros desarrollan expertise verificable mediante participación sostenida (contribuciones citadas frecuentemente, reporte de implementación exitosa), ¿podría comunidad emitir credenciales peer-validated que sistemas formales reconozcan?

El horizonte más transformador es uno donde desarrollo profesional docente no sea experiencia aislada (taller anual, curso en plataforma MOOC) sino práctica continua—comunidad rizomática donde maestros negocian conocimiento diariamente, mediados por IA que hace coordinación menos costosa cognitivamente sin eliminar la negociación humana que genera aprendizaje genuino.

En palabras de Wenger (1998, p. 7): “El aprendizaje no puede diseñarse—sucede, diseño o no diseño. Pero puede facilitarse o frustrarse”. Este artículo ha propuesto que IA con capacidades Theory of Mind no diseña el aprendizaje docente—facilita la coordinación que hace posible el aprendizaje emergente.