Introducción

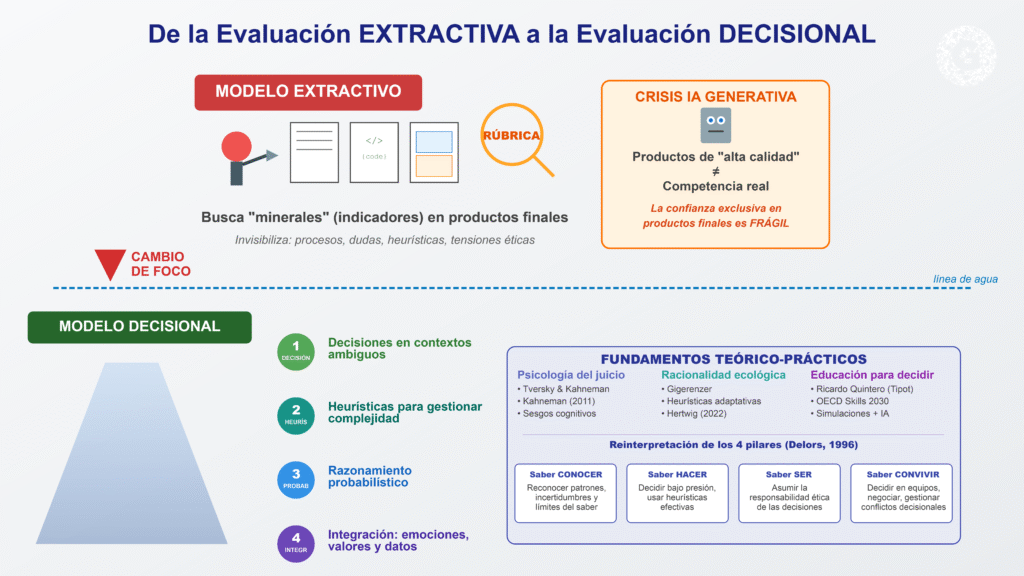

La evaluación por competencias se ha convertido en un eje articulador de las reformas educativas desde finales del siglo XX, inspirada en marcos como el Informe Delors y los cuatro pilares del aprendizaje. En teoría, esta perspectiva integra el saber conocer, el saber hacer, el saber ser y el saber convivir como dimensiones inseparables del desempeño profesional y ciudadano (Delors et al., 1996). Sin embargo, en la práctica institucional, esta promesa se ha traducido casi siempre en una lógica evaluativa centrada en productos, mediados por rúbricas, que el docente interpreta como evidencia de competencia.

En este trabajo se argumenta que dicha lógica configura un modelo extractivo de evaluación: el evaluador actúa como “minero” que busca rastros de “minerales preciosos” (indicadores de competencia) en la superficie del producto entregado por el estudiante. El proceso real de toma de decisiones, las heurísticas que utiliza, sus dudas, tensiones éticas y estrategias de razonamiento quedan invisibilizadas. La aparente objetividad de la rúbrica no elimina la fuerte carga interpretativa del juicio evaluador (Brookhart, 2013; Shavelson et al., 2019).

La irrupción de la inteligencia artificial (IA) generativa intensifica esta crisis. Hoy es posible producir textos, códigos, presentaciones y prototipos de alta calidad sin que necesariamente exista una competencia equivalente en quien los firma (Zawacki-Richter et al., 2020; Díaz-Guio et al., 2024).

En este contexto, seguir confiando casi exclusivamente en productos finales como evidencia de competencia resulta frágil.

Frente a ello, se propone avanzar hacia una evaluación decisional y heurística de competencias, que observe explícitamente:

las decisiones que toman las personas en contextos ambiguos,

las heurísticas que utilizan para gestionar la complejidad,

su capacidad para razonar probabilísticamente,

y la manera en que integran emociones, valores y datos en su juicio.

Este enfoque dialoga con la psicología del juicio y la decisión (Tversky & Kahneman, 1974; Kahneman, 2011), con la noción de racionalidad ecológica y heurísticas adaptativas (Gigerenzer & Gaissmaier, 2011; Hertwig, 2022) y con propuestas recientes que incorporan simulaciones y IA en la evaluación de competencias en educación superior.

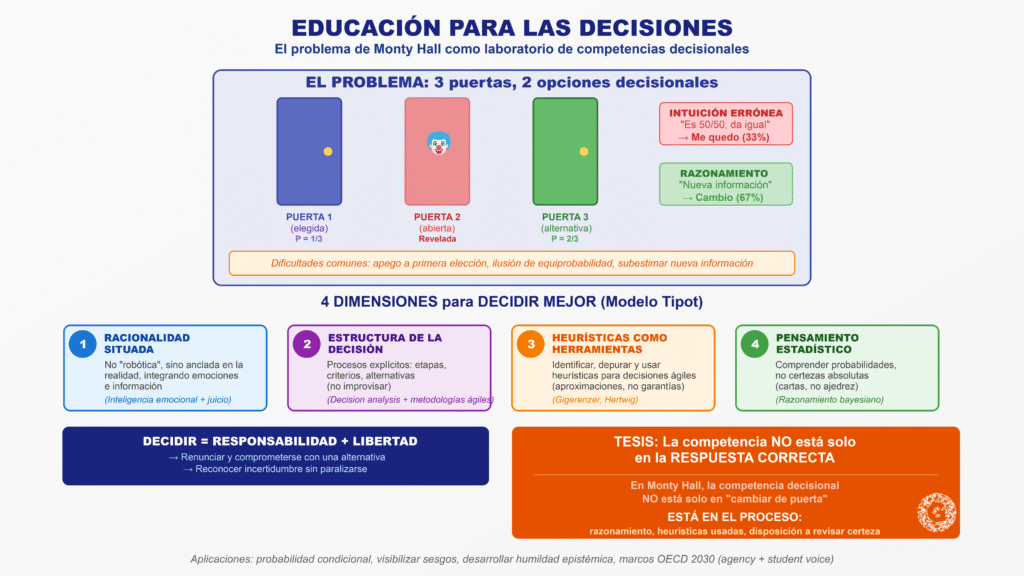

Además, se recoge la contribución de experiencias prácticas como el taller “Conoce el secreto para decidir mejor”, de Ricardo Quintero (Tipot), donde se plantea la decisión como un acto de responsabilidad y libertad, articulado en cuatro dimensiones: racionalidad, estructuración de la decisión, uso de heurísticas y pensamiento estadístico. Este tipo de propuestas de “educación para las decisiones” se alinea con la creciente centralidad de la toma de decisiones en los marcos de habilidades para 2030 (OECD, 2023; OECD, 2024).

2. El modelo extractivo de evaluación por competencias

2.1. Rúbricas, productos y minería interpretativa

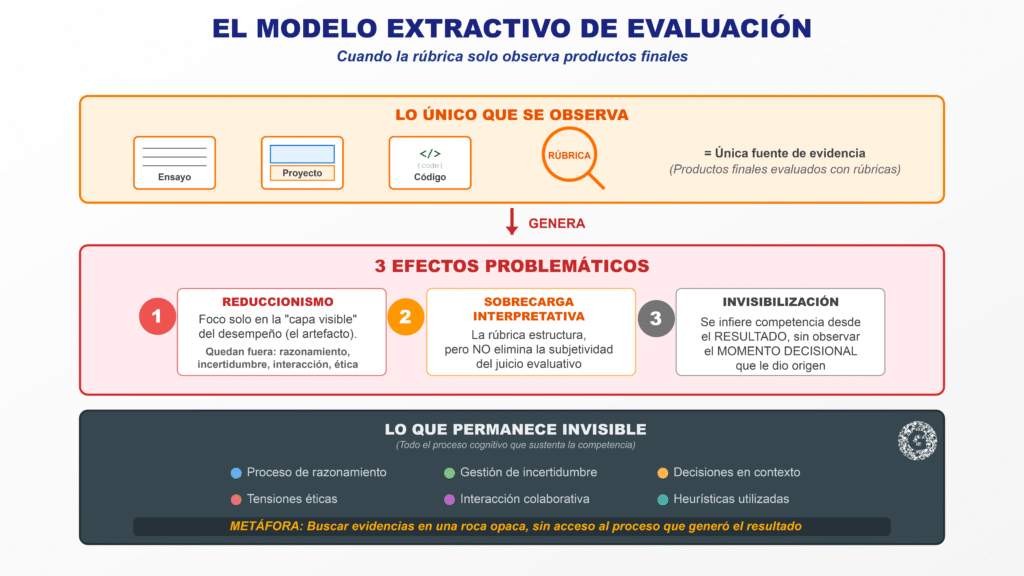

Las rúbricas surgieron como una herramienta potente para explicitar criterios de calidad, favorecer la transparencia y orientar la retroalimentación (Wiggins, 1998). Sin embargo, en muchos contextos se han convertido en el único dispositivo para inferir competencias, aplicado casi exclusivamente sobre productos finales (ensayos, proyectos, prototipos). Esto genera tres efectos:

Reduccionismo del desempeño observable.

El foco se concentra en la “capa visible” del desempeño: el artefacto. El proceso de razonamiento, la gestión de la incertidumbre, la interacción con otros y las tensiones éticas quedan fuera de campo (Sadler, 1989; Brown et al., 1989).Sobrecarga interpretativa del evaluador.

La rúbrica no elimina la subjetividad, sólo la estructura. La valoración sigue dependiendo de cómo el docente interpreta lo que “ve” del estudiante (Brookhart, 2013).Invisibilización de la toma de decisiones.

La competencia se infiere a partir de un resultado, sin observar el momento decisional que le dio origen. Esta lógica es particularmente problemática cuando se evalúan competencias como pensamiento crítico, resolución de problemas o juicio ético.

La metáfora de la minería resulta pertinente: el evaluador busca “evidencias” valiosas en una roca relativamente opaca, confiando en que el producto final condensa todo el proceso de aprendizaje.

2.2. Vulnerabilidad frente a la IA generativa

La IA generativa multiplica la distancia entre producto y proceso. Estudios recientes muestran su capacidad para producir textos académicos plausibles, resolver problemas y simular tareas complejas, lo cual cuestiona la equivalencia entre “buen producto” y “competencia auténtica” (US Department of Education, 2023; Zawacki-Richter et al., 2020; Díaz-Guio et al., 2024).

Paradójicamente, la propia IA puede ser un aliado para observar mejor el proceso: registrar interacciones, simular escenarios decisionales, modelar trazas de pensamiento y ofrecer retroalimentación personalizada (Díaz-Guio et al., 2024; Muniz & Diamanti, 2025; Dzhumatovich et al., 2025).

3. Heurísticas, sesgos y racionalidad limitada como núcleo de la competencia

3.1. De la heurística como error a la heurística como recurso

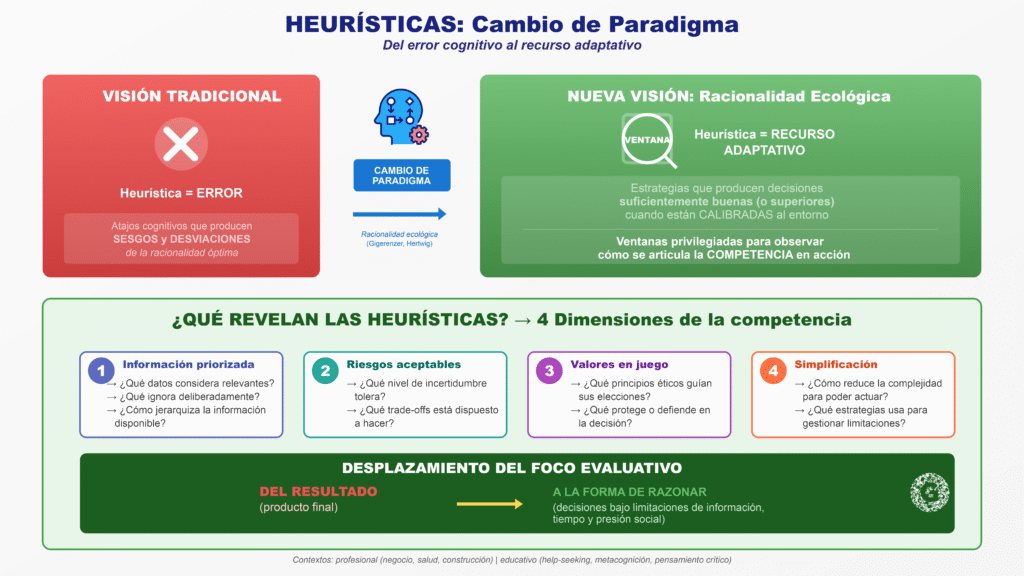

La psicología del juicio ha mostrado que, frente a la complejidad e incertidumbre, las personas recurren a heurísticas: atajos cognitivos que permiten decidir con información y tiempo limitados (Tversky & Kahneman, 1974; Kahneman, 2011). Tradicionalmente, muchas de estas heurísticas han sido descritas a través del prisma de los sesgos cognitivos (por ejemplo, heurística de disponibilidad, representatividad, afecto).

No obstante, la línea de la racionalidad ecológica defiende que, en entornos reales, estas heurísticas pueden ser estrategias adaptativas que producen decisiones suficientemente buenas, o incluso superiores a enfoques más complejos, siempre que estén bien calibradas al entorno (Gigerenzer & Gaissmaier, 2011; Hertwig, 2022; Marewski, 2024).

Desde esta perspectiva, las heurísticas no son simplemente “errores” a corregir, sino ventanas privilegiadas para observar cómo se articula la competencia en la acción:

Qué información prioriza la persona.

Qué riesgos considera aceptables.

Qué valores pone en juego.

Cómo simplifica la complejidad para poder actuar.

3.2. Heurísticas en contextos profesionales y educativos

Estudios recientes han analizado el rol de las heurísticas en decisiones de negocio, construcción, salud o educación, mostrando que los profesionales combinan estrategias analíticas e intuitivas de forma complementaria (Pathak, 2023; Love, 2025; Marewski, 2024).

En el ámbito educativo, emergen investigaciones que vinculan heurísticas con:

help-seeking académico y decisiones de pedir ayuda (Chakraborty & Stone, 2020); desarrollo de metacognición a partir de la enseñanza de heurísticas en ciencias experimentales (Silva & colegas, 2025);

uso de paradojas probabilísticas (como Monty Hall) para fortalecer pensamiento crítico (Wijayatunga, 2024; Feliciano-Semidei et al., 2022; Rodríguez, 2025).

En todos los casos, el foco se desplaza del resultado a la forma de razonar, es decir, a las decisiones que se toman bajo limitaciones de información, tiempo y presión social.

4. Educación para las decisiones: aportes del modelo Tipot y el caso Monty Hall

4.1. Decidir como responsabilidad y libertad

En el taller “Conoce el secreto para decidir mejor”, Quintero plantea que decidir implica renunciar: comprometerse con una alternativa y aceptar las consecuencias, lo cual convierte la decisión en un acto de responsabilidad y, simultáneamente, en una recuperación de la libertad personal frente a la pasividad o la dependencia de las circunstancias.

La narrativa que desarrolla —la duda como “huésped incómodo”, la tentación de “no decidir” y delegar en el azar o en otros, la metáfora del día de lluvia que no desaparece por desear sol— enfatiza que la madurez decisional implica:

reconocer la incertidumbre sin paralizarse;

aceptar que ninguna decisión garantiza el resultado deseado;

actuar desde lo que está efectivamente bajo control.

Esta concepción coincide con visiones contemporáneas sobre agency y student voice en marcos de competencias para 2030, donde se subraya que las y los estudiantes deben ser protagonistas de sus decisiones vitales, profesionales y éticas (OECD, 2018, 2023).

4.2. Las cuatro dimensiones: racionalidad, estructura, heurísticas y pensamiento estadístico

Quintero organiza su propuesta en cuatro dimensiones que se corresponden, de forma notable, con líneas de investigación académica:

Racionalidad situada.

No se trata de una racionalidad “robótica”, sino de estar anclado en la realidad integrando emociones e información. Aquí dialoga con la literatura sobre inteligencia emocional, juicio profesional y racionalidad limitada (Kahneman, 2011).Estructura de la decisión.

Contar con procesos explícitos (etapas, criterios, alternativas) en lugar de improvisar. Esto conecta con la tradición de decision analysis y con metodologías ágiles que institucionalizan procesos de decisión en organizaciones.Heurísticas como herramientas.

Identificar, depurar y usar heurísticas que permitan decisiones ágiles, sabiendo que son aproximaciones y no garantías de éxito (Gigerenzer & Gaissmaier, 2011; Hertwig, 2022).Pensamiento estadístico y probabilístico.

Comprender que la vida se parece más a un juego de cartas que a un juego determinista como el ajedrez; es decir, operar con probabilidades y no con absolutos.

4.3. El problema de las tres puertas: Monty Hall como laboratorio de competencias decisionales

El ejemplo de las tres puertas con un personaje (amor de tu vida) y un payaso funciona como variación narrativa del clásico problema de Monty Hall. Investigaciones recientes han mostrado que:

los estudiantes tienden a confiar en su intuición de “50/50” tras la apertura de una puerta,

subestiman el valor de la nueva información,

y tienen dificultades para pensar condicionalmente (Feliciano-Semidei et al., 2022; Rodríguez, 2025).

El uso de Monty Hall como recurso didáctico permite:

trabajar conceptos de probabilidad condicional y razonamiento bayesiano;

visibilizar sesgos como el apego a la primera elección o la ilusión de equiprobabilidad;

desarrollar la humildad epistémica de “asumir que puedo estar equivocado” y revisar la decisión.

Este tipo de tarea ilustra de manera muy directa la tesis de este artículo: la competencia no está sólo en la respuesta correcta (“cambiar de puerta”), sino en el proceso de razonamiento, en la heurística usada para decidir y en la disposición a revisar la propia certeza a la luz de nueva evidencia.

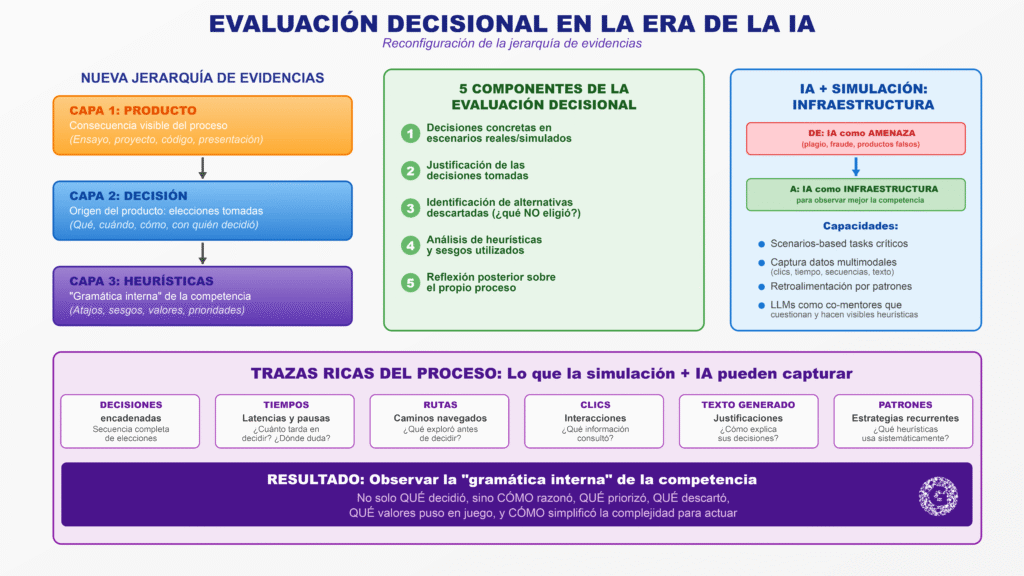

5. Evaluación decisional de competencias en la era de la IA

5.1. Más allá del producto: decisiones como evidencia evaluativa

Proponemos llamar evaluación decisional al proceso de valorar competencias a partir de:

decisiones concretas tomadas por la persona en escenarios reales o simulados;

la justificación de dichas decisiones;

la identificación de alternativas descartadas;

el análisis de sus heurísticas y sesgos;

y la reflexión posterior sobre el propio proceso.

Esta evaluación decisional no sustituye totalmente al producto, pero reconfigura la jerarquía de evidencias:

El producto es una consecuencia;

la decisión es el origen;

las heurísticas son la “gramática interna” de la competencia.

5.2. Simulación, IA y trazas ricas del proceso

La literatura reciente en simulation-based assessment y IA educativa muestra que es posible diseñar entornos donde los estudiantes deban tomar decisiones encadenadas, mientras el sistema registra sus acciones, tiempos, rutas y justificaciones (Muniz & Diamanti, 2025; Dzhumatovich et al., 2025; Campbell et al., 2025).

Estos entornos permiten:

plantear scenarios-based tasks que modelan situaciones críticas de la profesión;

capturar datos multimodales (clics, tiempo, secuencias, texto generado);

generar retroalimentación personalizada basada en patrones de decisión;

explorar el uso de LLMs como co-mentores que cuestionan y hacen visibles las heurísticas del estudiante.

En este marco, la IA deja de ser sólo una “amenaza” para la evaluación (plagio, fraude) y se convierte en infraestructura para observar mejor la competencia.

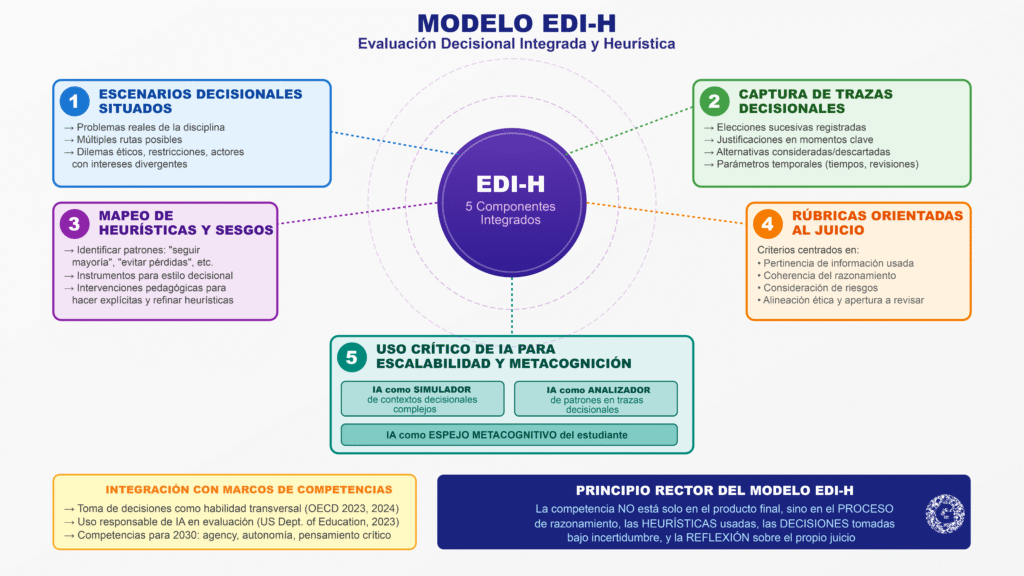

6. Propuesta de modelo: Evaluación Decisional Integrada y Heurística (EDI-H)

A partir de lo anterior, se propone un modelo ampliado de Evaluación Decisional Integrada y Heurística (EDI-H), con cinco componentes:

Escenarios decisionales situados.

Inspirados en problemas reales de la disciplina, con múltiples rutas posibles.

Pueden incorporar dilemas éticos, restricciones de recursos y actores con intereses divergentes.

Captura de trazas decisionales.

Registro de elecciones sucesivas.

Justificaciones breves en momentos clave.

Alternativas consideradas y descartadas.

Parámetros temporales (tiempos de respuesta, revisiones, etc.).

Mapeo de heurísticas y sesgos.

Identificación de patrones como: “seguir a la mayoría”, “evitar pérdidas”, “pensar en blanco y negro”.

Uso de instrumentos estandarizados para estilo decisional y uso de pistas heurísticas (Pathak, 2023).

Diseño de intervenciones pedagógicas para hacer explícitas y refinar estas heurísticas (Hertwig, 2022; Marewski, 2024).

4. Rúbricas orientadas al juicio y no sólo al resultado.

Criterios centrados en: pertinencia de la información usada, coherencia del razonamiento, consideración de riesgos, alineación ética, apertura a revisar la decisión.

Integración con marcos de competencias que ya reconocen la toma de decisiones como habilidad transversal (OECD, 2023; OECD, 2024).

5. Uso crítico de IA para escalabilidad y metacognición.

IA como simulador de contextos, como analizador de patrones y como espejo metacognitivo del estudiante.

Coherente con recomendaciones recientes sobre uso responsable de IA en la evaluación y el desarrollo de competencias (US Department of Education, 2023; Díaz-Guio et al., 2024).

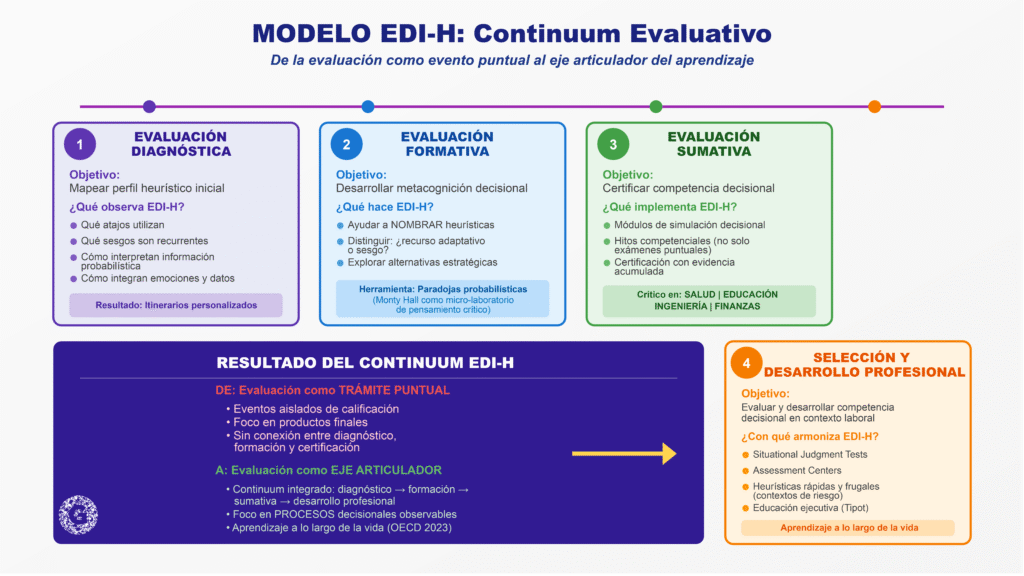

7. Implicaciones para evaluación diagnóstica, formativa, sumativa y selección de personal

7.1. Evaluación diagnóstica

La evaluación decisional permite mapear el perfil heurístico inicial de estudiantes o candidatos:

qué atajos utilizan,

qué sesgos son recurrentes,

cómo interpretan información probabilística,

cómo integran emociones y datos.

Esto permite diseñar itinerarios personalizados de desarrollo de competencias, superando la lógica de diagnósticos basados sólo en cuestionarios de autopercepción.

7.2. Evaluación formativa

En un enfoque EDI-H, la evaluación formativa se centra en:

ayudar a los participantes a nombrar sus heurísticas;

distinguir cuándo funcionan como recursos adaptativos y cuándo se vuelven sesgos;

explorar alternativas estratégicas (por ejemplo, cambiar regla de decisión, incorporar evidencia adicional, consultar a otros).

Aquí los paradojas probabilísticas (como Monty Hall y otros problemas) aparecen como excelentes “micro-laboratorios” para entrenar pensamiento crítico y probabilístico (Wijayatunga, 2024).

7.3. Evaluación sumativa

En lugar de limitarse a calificar productos, las instituciones pueden:

integrar módulos de simulación decisional en cursos clave;

convertir determinadas situaciones de decisión en “hitos competenciales”;

certificar niveles de competencia decisional con base en evidencia acumulada de decisiones tomadas en diversos contextos.

Esto es especialmente relevante en carreras donde el error decisional puede tener alto impacto (salud, educación, ingeniería, finanzas).

7.4. Selección de personal y desarrollo profesional

La literatura organizacional ya utiliza formatos como Situational Judgment Tests y assessment centers para evaluar decisiones en contextos simulados (Weekley & Ployhart, 2013). La propuesta EDI-H refuerza este enfoque y lo armoniza con:

modelos de heurísticas rápidas y frugales aplicados a contextos de riesgo e incertidumbre (Love, 2025);

programas de educación ejecutiva orientados a “educación para las decisiones”, como el que plantea Tipot.

De este modo, la evaluación de competencias deja de ser un trámite de cierre (producto) y se convierte en un eje articulador de aprendizaje a lo largo de la vida, coherente con las agendas de habilidades para el futuro (OECD, 2023).

8. Discusión y líneas de investigación

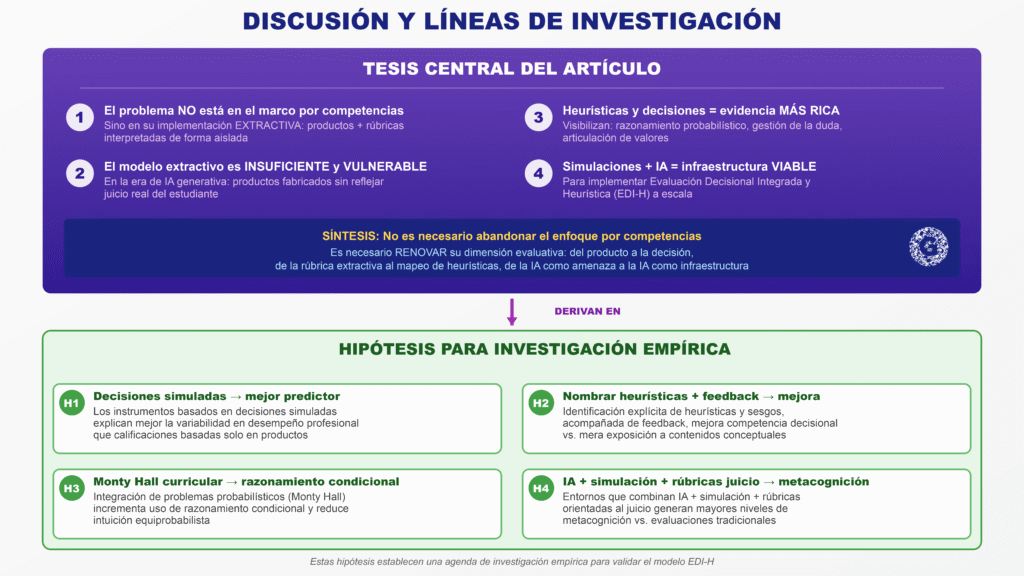

8.1. Resumen de la tesis

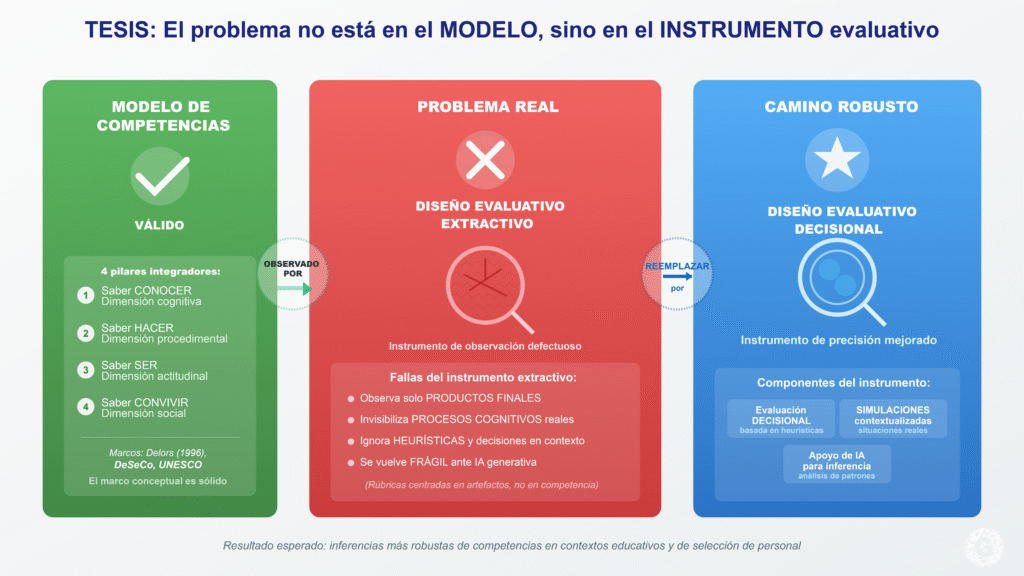

El artículo sostiene que:

El problema actual de la evaluación por competencias no radica en el marco competencial en sí, sino en una implementación extractiva, basada en productos y rúbricas interpretadas de forma aislada.

Este modelo es insuficiente y vulnerable en la era de la IA generativa, donde el producto puede ser fabricado sin reflejar el juicio del estudiante.

Las heurísticas y decisiones constituyen una fuente de evidencia más rica y directa de la competencia, especialmente cuando se hace visible el razonamiento probabilístico, la gestión de la duda y la articulación de valores.

Las simulaciones apoyadas en IA ofrecen una infraestructura viable para implementar una Evaluación Decisional Integrada y Heurística (EDI-H) a escala.

8.2. Hipótesis para investigación empírica

Se derivan, entre otras, las siguientes hipótesis:

H1: Los instrumentos basados en decisiones simuladas explican mejor la variabilidad en desempeño profesional que las calificaciones basadas sólo en productos.

H2: La identificación explícita de heurísticas y sesgos, acompañada de feedback, mejora la competencia decisional en comparación con una mera exposición a contenidos conceptuales sobre decisión.

H3: La integración de problemas probabilísticos como Monty Hall en currículos de educación superior incrementa el uso de razonamiento condicional y reduce la intuición equiprobabilista.

H4: Los entornos de evaluación que combinan IA + simulación + rúbricas orientadas al juicio generan mayores niveles de metacognición que las evaluaciones tradicionales.

9. Conclusiones

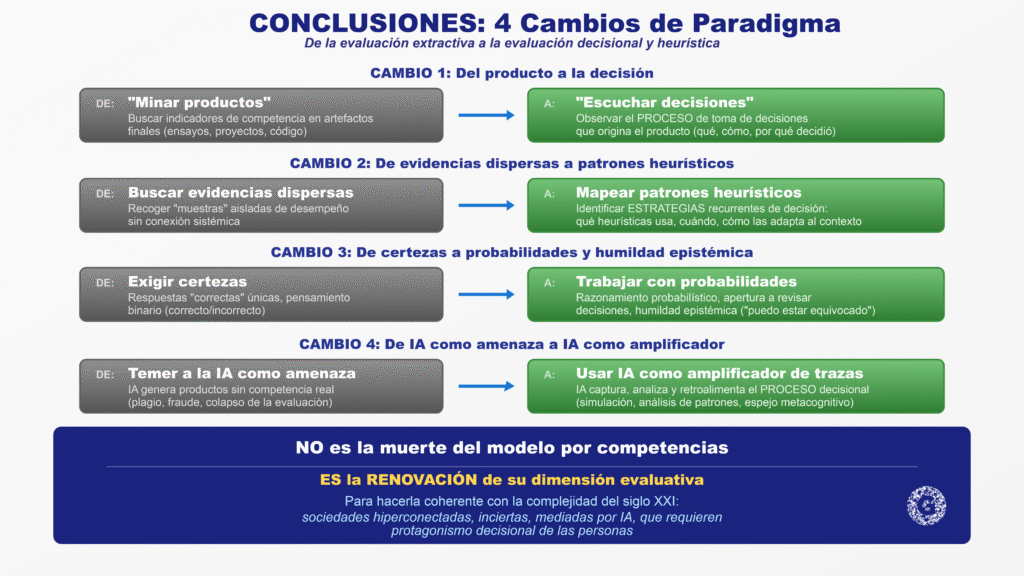

La transición desde un modelo extractivo hacia una evaluación decisional y heurística de competencias implica un cambio de paradigma:

de “minar productos” a escuchar decisiones;

de buscar evidencias dispersas a mapear patrones heurísticos;

de exigir certezas a trabajar con probabilidades y humildad epistémica;

de temer a la IA como amenaza a usar la IA como amplificador de trazas del proceso.

Lejos de declarar “muerto” el enfoque por competencias, este artículo propone renovar su dimensión evaluativa para hacerla coherente con la complejidad del siglo XXI y con el protagonismo decisional que requieren las personas en sociedades hiperconectadas, inciertas y mediadas por IA.