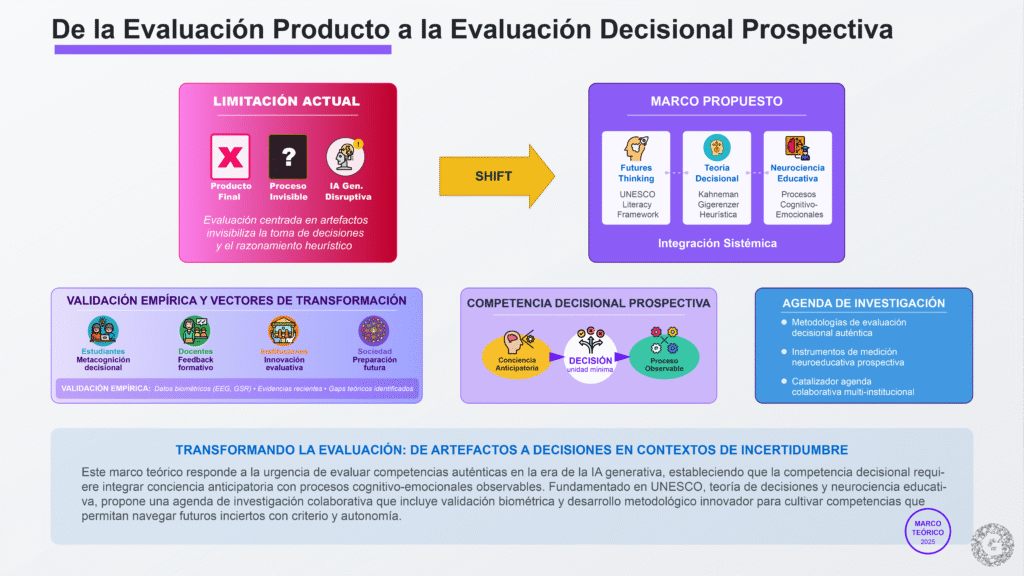

El acelerado cambio tecnológico y la irrupción de la inteligencia artificial generativa han evidenciado las limitaciones de los métodos tradicionales de evaluación de competencias, que se centran en productos finales mientras invisibilizan el proceso decisional subyacente. Este artículo propone un marco teórico innovador que integra el pensamiento de futuro (futures thinking) con la evaluación decisional y heurística, respondiendo a la necesidad urgente de evaluar competencias auténticas en contextos de incertidumbre. Fundamentado en el Marco de Alfabetización en Futuros de UNESCO (Miller, 2018), la teoría de decisiones de Kahneman y Gigerenzer, y avances recientes en neurociencia educativa, el marco establece que la competencia decisional en contextos prospectivos requiere la integración de conciencia anticipatoria con procesos cognitivo-emocionales observables. El artículo sistematiza evidencias empíricas recientes que validan componentes del marco, identifica gaps teóricos y metodológicos que la propuesta aborda, y articula beneficios para estudiantes, docentes, instituciones y sociedad. Concluye estableciendo direcciones metodológicas futuras, incluyendo el potencial de datos biométricos (EEG, GSR) para validar empíricamente el constructo propuesto. Este trabajo busca catalizar una agenda de investigación colaborativa que transforme cómo evaluamos y cultivamos competencias para navegar futuros inciertos.

Palabras clave: pensamiento de futuro, evaluación decisional, alfabetización en futuros, competencias complejas, inteligencia artificial generativa, evaluación auténtica

Introducción

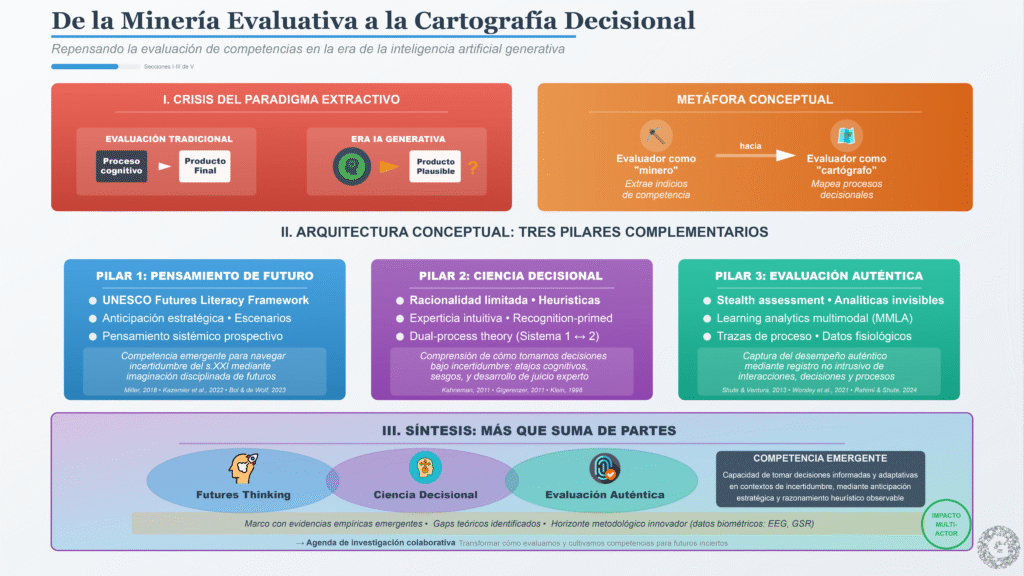

El acelerado cambio tecnológico y la creciente complejidad de los problemas sociales han puesto en evidencia las limitaciones de los métodos tradicionales de evaluación de competencias. En el ámbito educativo, durante décadas la evaluación por competencias se ha centrado en productos finales—ensayos, proyectos, prototipos—medidos con rúbricas, bajo el supuesto de que el resultado refleja fielmente el desempeño del estudiante (Sadler, 1989; Tardif, 2006). Sin embargo, este enfoque extractivo actúa como un minero que busca indicadores de competencia en la superficie del producto, mientras invisibiliza el proceso real de pensamiento: las decisiones tomadas, las dudas enfrentadas, las estrategias de razonamiento y las tensiones éticas que ocurren tras bambalinas (Wiggins, 1998). La aparente objetividad de la rúbrica no elimina la carga interpretativa del evaluador, ni garantiza captar la complejidad del desempeño auténtico (Brookhart, 2013).

Con la irrupción de la inteligencia artificial generativa, esta fragilidad se intensifica dramáticamente. Hoy es posible generar textos académicos plausibles, códigos funcionales o presentaciones de alta calidad sin la competencia equivalente en quien las firma (Sullivan et al., 2023). Estudios recientes demuestran que herramientas como ChatGPT pueden producir ensayos que superan evaluaciones tradicionales, diluyendo la equivalencia entre “buen producto” y “competencia auténtica” (Perkins et al., 2024). Confiar exclusivamente en productos finales como evidencia de competencia resulta frágil en este nuevo contexto. Paradójicamente, la misma IA puede convertirse en aliada para mejorar la evaluación, permitiendo registrar interacciones, simular escenarios decisionales y modelar las trazas de pensamiento de los aprendices (Shute et al., 2023). Ante estos desafíos, surge la necesidad de un cambio de paradigma: pasar de la evaluación centrada en el producto a una evaluación centrada en el proceso decisional, incorporando a la vez una perspectiva de futuro.

Expertos en educación y futuros coinciden en que la formación del siglo XXI requiere nuevas aproximaciones. Como señalan Ramírez-Montoya et al. (2025), “el futuro de la educación requiere formación de alta capacidad para preparar ciudadanos competentes para resolver problemas complejos”. Esto implica cultivar en los estudiantes no solo conocimientos técnicos, sino competencias integradoras que les permitan anticipar escenarios futuros, tomar decisiones informadas bajo incertidumbre y adaptarse creativamente a contextos cambiantes (Miller, 2018; Ahvenharju et al., 2018). La UNESCO, en su Marco Global de Competencias de Alfabetización Digital, reconoce la anticipación estratégica, la planificación de escenarios y el pensamiento sistémico como componentes esenciales para desenvolverse competentemente en la cultura digital contemporánea (UNESCO, 2017, 2024).

En este documento proponemos un marco teórico innovador que integra el pensamiento de futuro con la evaluación decisional y heurística, fundamentado en tres pilares conceptuales complementarios: (1) el Marco de Alfabetización en Futuros (Futures Literacy Framework) desarrollado por UNESCO y sus aplicaciones educativas recientes (Miller, 2018; Kazemier et al., 2022; Bol & de Wolf, 2023), (2) la ciencia de la toma de decisiones desde las perspectivas de racionalidad limitada (Kahneman, 2011; Gigerenzer & Gaissmaier, 2011) y experticia intuitiva (Klein, 1998; Kahneman & Klein, 2009), y (3) avances metodológicos en evaluación auténtica mediante stealth assessment y analíticas de aprendizaje multimodal (Shute & Ventura, 2013; Rahimi & Shute, 2024; Worsley et al., 2021). Mostramos cómo esta síntesis teórica ya encuentra respaldo en resultados empíricos prometedores y abre horizontes metodológicos innovadores.

Nuestro objetivo es convencer a la comunidad académica de impulsar esta línea de investigación, evidenciando los beneficios que todos los actores—estudiantes, docentes, instituciones y sociedad—pueden obtener de este nuevo enfoque analítico. Argumentamos que la integración del pensamiento de futuro con la evaluación decisional no es una mera suma de partes, sino una síntesis que genera competencias emergentes fundamentales para navegar la incertidumbre del siglo XXI (Poli, 2017; Vidergor, 2023). El artículo se estructura de la siguiente manera: primero, diagnosticamos las limitaciones de la evaluación tradicional agudizadas por la IA generativa; segundo, desarrollamos los fundamentos del pensamiento de futuro y la evaluación decisional como paradigmas complementarios; tercero, proponemos su integración en un marco coherente; cuarto, sistematizamos evidencias empíricas que validan componentes del marco; quinto, articulamos beneficios para diversos stakeholders; y finalmente, establecemos direcciones metodológicas futuras incluyendo el potencial de datos fisiológicos para validar empíricamente el constructo.

Limitaciones de la Evaluación Tradicional de Competencias

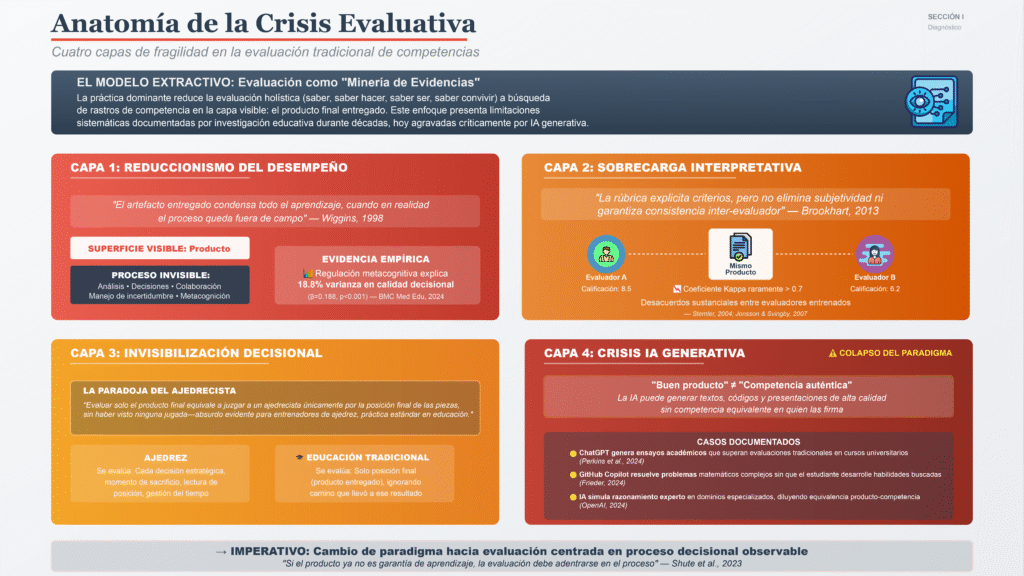

La evaluación por competencias surgió para integrar múltiples dimensiones del desempeño humano: saber, saber hacer, saber ser y saber convivir (Delors, 1996; Perrenoud, 2004). No obstante, en la práctica muchas instituciones redujeron esta visión holística a una lógica de “minería” de evidencias: el evaluador busca rastros de competencia únicamente en la capa visible del desempeño, es decir, el producto final entregado (Tardif, 2006). Este modelo extractivo conlleva varios problemas fundamentales que la investigación educativa ha documentado consistentemente.

Reduccionismo del Desempeño

Primero, se asume que el artefacto entregado condensa todo el aprendizaje, cuando en realidad el proceso—cómo el estudiante analiza el problema, toma decisiones, colabora o maneja incertidumbre—queda fuera de campo (Wiggins, 1998; Bransford et al., 2000). Como advierte Sadler (1989), evaluar solo lo observable corre el riesgo de ignorar aspectos cruciales del razonamiento y la metacognición del alumno. Investigación reciente sobre metacognición en contextos educativos confirma que los procesos metacognitivos regulatorios—planificación, monitoreo, evaluación—predicen significativamente la calidad de la toma de decisiones pero permanecen invisibles en evaluaciones centradas en productos (Popandopulo et al., 2023; BMC Medical Education, 2024). Un estudio longitudinal con estudiantes de enfermería demostró que la regulación metacognitiva explicaba el 18.8% de la varianza en calidad decisional clínica (β=0.188, p<0.001), evidenciando que lo que no se ve es justamente lo más importante (BMC Medical Education, 2024).

Sobrecarga Interpretativa y Subjetividad

Segundo, una rúbrica bien diseñada explicita criterios de calidad, pero no elimina la subjetividad del evaluador ni garantiza consistencia inter-evaluador (Brookhart, 2013). Dos profesores pueden interpretar de modo distinto la evidencia en un proyecto idéntico, especialmente cuando evalúan competencias complejas como pensamiento crítico o creatividad. La calificación sigue dependiendo, en última instancia, del juicio humano sobre lo que “se ve” del estudiante, arriesgando sesgos inconscientes y variabilidad no deseada (Jonsson & Svingby, 2007). Estudios de confiabilidad inter-evaluador en evaluación por competencias reportan coeficientes Kappa que raramente superan 0.70, revelando desacuerdos sustanciales incluso entre evaluadores entrenados (Stemler, 2004).

Invisibilización de la Toma de Decisiones

Quizá la limitación más grave es que no se observa el momento decisional que dio origen al resultado (Kahneman, 2011). En competencias como pensamiento crítico, resolución de problemas o ética profesional, el cómo se llegó a la solución es tanto o más importante que la solución misma. Evaluar solo el producto final equivale a juzgar a un ajedrecista únicamente por la posición final de las piezas, sin haber visto ninguna jugada—un absurdo evidente para cualquier entrenador de ajedrez, pero práctica estándar en educación. La Alliance for Decision Education (2023) argumenta que la educación para la decisión (decision education) debe enseñar “formación de juicio hábil y toma de decisiones”, pero reconoce que los sistemas educativos actuales carecen de métodos validados para evaluar estas capacidades de manera auténtica.

La Crisis de la IA Generativa

Estas falencias se vuelven críticas en la era de la IA generativa. Herramientas como ChatGPT, GitHub Copilot o DALL-E permiten a cualquiera producir soluciones aparentemente competentes con poco esfuerzo cognitivo propio. Estudios recientes demuestran que la IA puede generar textos académicos plausibles (Sullivan et al., 2023), resolver problemas matemáticos complejos (Frieder et al., 2024) y hasta simular razonamiento experto en dominios especializados (OpenAI, 2024), diluyendo la equivalencia tradicional entre un “buen producto” y una “competencia auténtica”. Un estudiante podría entregar un ensayo impecable escrito en gran parte por una IA, obteniendo una calificación alta sin haber desarrollado las habilidades que la tarea buscaba medir. Perkins et al. (2024) documentan casos donde trabajos generados por IA superan evaluaciones de cursos universitarios de escritura, exponiendo la fragilidad de nuestros métodos actuales.

En este contexto, “seguir confiando casi exclusivamente en productos finales como evidencia de competencia resulta frágil” (Shute et al., 2023). La comunidad educativa necesita replantear qué y cómo evalúa. Si el producto ya no es garantía de autoría ni de aprendizaje, la evaluación debe adentrarse en el proceso: observar las decisiones que toma el alumno, las estrategias que emplea, cómo maneja la información y la incertidumbre en tiempo real. Solo así podremos inferir con mayor certeza las competencias subyacentes en un mundo donde la creación de productos puede ser delegada a las máquinas. Como plantea la investigación sobre evaluación sigilosa (stealth assessment), necesitamos capturar evidencias de competencia de manera continua y no intrusiva durante el proceso de aprendizaje, no solo al final (Shute & Ventura, 2013; Rahimi & Shute, 2024).

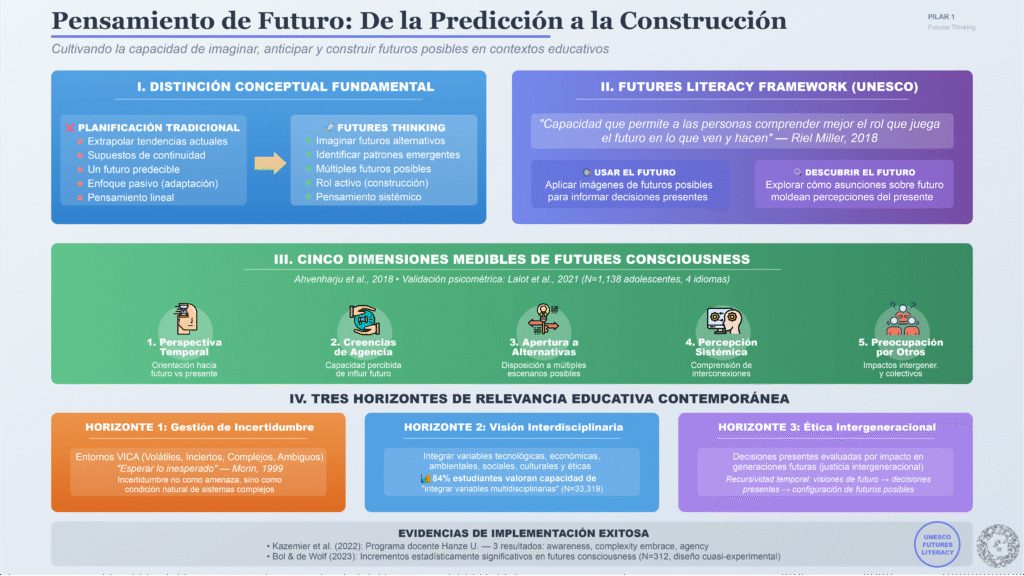

Pensamiento de Futuro: Anticipación y Visión Prospectiva

El pensamiento de futuro, conocido en inglés como futures thinking o futures literacy, es un enfoque metodológico que trasciende la simple predicción para enfocarse en la construcción de futuros posibles (Miller, 2018). A diferencia de la planificación tradicional, que suele basarse en extrapolar tendencias actuales bajo supuestos de continuidad, el pensamiento de futuro cultiva la capacidad de imaginar futuros alternativos, identificar patrones emergentes y desarrollar estrategias adaptativas para navegar en la incertidumbre (Poli, 2017; Slaughter, 2004). Según el Institute for the Future, implica habilidades como: “enfocarse en patrones más que en predicciones; considerar múltiples futuros, no solo uno; pensar sistémicamente sobre interconexiones; abrazar la incertidumbre como oportunidad; y asumir un rol activo en la creación del futuro” (IFTF, 2020).

Fundamentos Conceptuales

El marco más influyente en este campo es el Futures Literacy Framework (FLF) desarrollado por Riel Miller para UNESCO (Miller, 2018). Miller define la alfabetización en futuros (futures literacy) como “la capacidad que permite a las personas comprender mejor el rol que juega el futuro en lo que ven y hacen” (Miller, 2018, p. 3). El FLF se fundamenta en la noción de “sistemas anticipatorios” de Robert Rosen (1985), que plantea que los humanos utilizamos modelos del futuro para guiar acciones presentes. Crucialmente, Miller distingue entre usar el futuro (aplicar imágenes de futuros posibles para informar decisiones) y descubrir el futuro (explorar cómo las asunciones sobre el futuro moldean nuestras percepciones del presente) (Miller, 2018). Esta distinción es fundamental porque revela que nuestras “anticipaciones” no son neutrales: las visiones de futuro que sostenemos determinan qué vemos como posible, deseable o inevitable hoy.

Desde una perspectiva psicológica, Ahvenharju et al. (2018) propusieron las cinco dimensiones de la Futures Consciousness (Conciencia de Futuros), estableciendo un marco medible: (1) perspectiva temporal (orientación hacia futuro vs. presente/pasado), (2) creencias de agencia (percepción de capacidad para influir el futuro), (3) apertura a alternativas (disposición a considerar múltiples escenarios), (4) percepción sistémica (comprensión de interconexiones complejas), y (5) preocupación por otros (consideración de impactos intergeneracionales y colectivos). Lalot et al. (2021) refinaron y validaron psicométricamente la Futures Consciousness Scale en cuatro idiomas con 1,138 adolescentes, confirmando que estas dimensiones son constructos estables y medibles. Este avance metodológico es crucial porque permite evaluar cuantitativamente capacidades prospectivas que antes se consideraban intangibles.

Relevancia Educativa Contemporánea

Este enfoque ha cobrado relevancia exponencial en educación y desarrollo de competencias durante los últimos cinco años. La UNESCO reconoce explícitamente la anticipación estratégica, la planificación de escenarios y el pensamiento sistémico como componentes esenciales de su Marco Global de Competencias de Alfabetización Digital (UNESCO, 2024). Esto sugiere que, incluso para desenvolverse competentemente en la cultura digital contemporánea, los individuos deben ser capaces de proyectarse hacia el futuro, valorar distintos escenarios y entender los sistemas complejos en que operan. El Simposio UNESCO-PMU sobre evaluación de alfabetización en futuros (2023) concluyó que “futures literacy debe integrarse transversalmente en educación superior, no como contenido adicional sino como meta-competencia que potencia todas las demás”.

¿Por qué es importante el pensamiento de futuro en la formación actual? En primer lugar, por la gestión de incertidumbre. Vivimos en entornos VICA (volátiles, inciertos, complejos y ambiguos) donde la única constante es el cambio acelerado. Preparar a los estudiantes para “esperar lo inesperado”, como señala Edgar Morin (1999), se vuelve una competencia crítica. Esto implica enseñarles a gestionar la incertidumbre no como una amenaza a eliminar, sino como una condición natural de los sistemas complejos (Morin, 1999; Poli, 2017). De hecho, la gestión sistémica de la incertidumbre es uno de los ejes que conectan el pensamiento de futuro con el pensamiento complejo de Morin: ambos paradigmas ven la incertidumbre no como un error a eliminar, sino como parte constitutiva de la realidad con la que debemos interactuar informada y éticamente.

En segundo lugar, el pensamiento de futuro promueve interdisciplinariedad y visión global. Anticipar escenarios futuros requiere integrar variables tecnológicas, económicas, ambientales, sociales, culturales y éticas simultáneamente. No se puede imaginar el futuro en silos disciplinarios. Talamás-Carvajal et al. (2024), en un estudio masivo con 33,319 estudiantes universitarios, encontraron que el 84% valoraron altamente la capacidad de “identificar variables de varias disciplinas para responder preguntas”, reflejando la importancia que las nuevas generaciones dan a conectar conocimientos diversos para resolver problemas complejos. Esta capacidad—vital tanto para el pensamiento sistémico como para la prospectiva—es una competencia transversal que la educación debe cultivar intencionalmente.

Finalmente, el pensamiento de futuro aporta una dimensión ética de responsabilidad intergeneracional. Implica preguntarnos cómo las decisiones de hoy impactarán en las generaciones de mañana. Este sentido de “justicia intergeneracional” demanda formar ciudadanos capaces de evaluar las decisiones presentes no solo por sus consecuencias inmediatas, sino por su contribución a futuros deseables (Jonas, 1984; UNESCO, 2021). Aquí converge directamente con la evaluación decisional: ambas perspectivas invitan a considerar la recursividad temporal, es decir, cómo las visiones de futuro influyen en decisiones presentes, las cuales a su vez van configurando esos futuros posibles (Poli, 2017). En síntesis, el pensamiento de futuro dota a la evaluación de una brújula de largo plazo, asegurando que al valorar una acción o competencia, no perdamos de vista el horizonte hacia donde nos conduce.

Aplicaciones Educativas Recientes

La investigación educativa reciente demuestra que el pensamiento de futuro puede enseñarse y evaluarse efectivamente. Kazemier et al. (2022) evaluaron un programa de desarrollo docente en alfabetización en futuros en Hanze University (Cátedra UNESCO), identificando tres resultados de aprendizaje: percepción mejorada (awareness), abrazo de complejidad (embracing complexity), y nuevo sentido de agencia. Los 54 participantes reportaron transformaciones en cómo conceptualizan su práctica docente, incorporando escenarios futuros en diseño curricular. Bol y de Wolf (2023) demostraron incrementos estadísticamente significativos en futures consciousness usando diseño cuasi-experimental con medición pre/post en aulas secundarias (N=312), evidenciando que intervenciones pedagógicas de 12 semanas pueden desarrollar capacidades prospectivas medibles.

Vidergor (2023) propuso un currículum completo de “Futures Studies” para K-12 usando el modelo MdCM (Multidimensional Curriculum Model), argumentando que estudiantes desde edad temprana pueden desarrollar competencias de pensamiento futuro si se estructuran apropiadamente. Laherto y Rasa (2022) conectaron futures thinking con educación científica transformativa, mostrando que estudiantes con percepción positiva del futuro tienen mayor claridad de agencia y motivación para aprender ciencias. Críticamente, Facer y Sprague (2024) advirtieron sobre “provincializar” la Futures Literacy, reconociendo que relaciones de poder moldean qué futuros se imaginan como legítimos—una consideración ética fundamental para cualquier marco evaluativo que incorpore esta dimensión.

Evaluación Decisional y Heurística: Más Allá del Producto

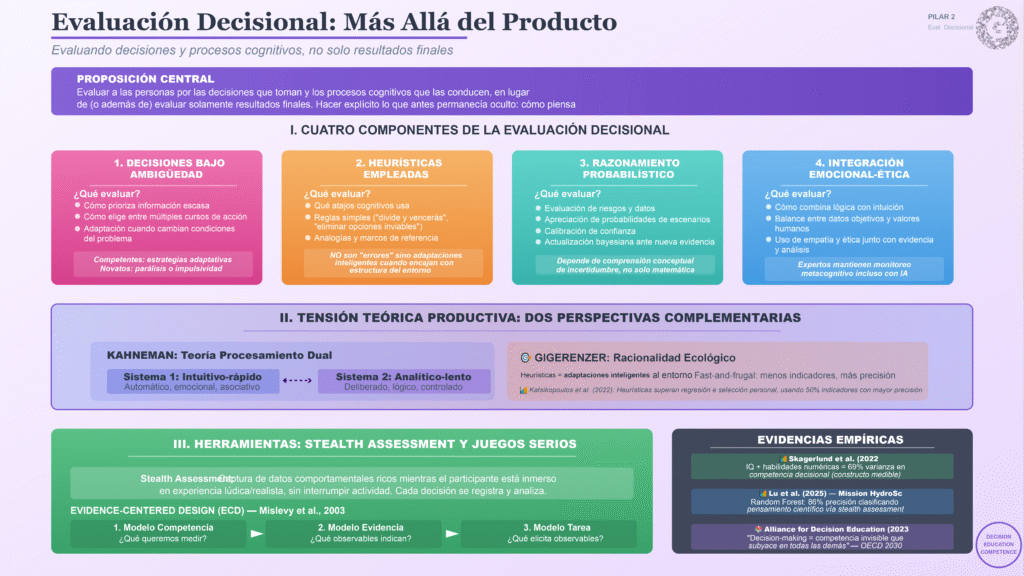

La evaluación decisional es una propuesta emergente que plantea evaluar a las personas por las decisiones que toman y los procesos cognitivos que conducen, en lugar de (o además de) evaluar solamente resultados finales (Shute & Ventura, 2013; Alliance for Decision Education, 2023). Este enfoque, también llamado evaluación heurística o de proceso, busca hacer explícito lo que antes permanecía oculto: cómo piensa el estudiante o el profesional ante un desafío real. En concreto, una evaluación decisional y heurística de competencias se fija en cuatro aspectos clave que la literatura ha identificado como fundamentales.

Componentes de la Evaluación Decisional

Primero, decisiones bajo ambigüedad: qué elecciones realiza la persona cuando se enfrenta a contextos inciertos o problemas mal definidos, donde no hay un procedimiento claro ni una única respuesta correcta (Gigerenzer & Gaissmaier, 2011). Por ejemplo, cómo prioriza información escasa, cómo decide entre múltiples cursos de acción o cómo se adapta cuando cambian las condiciones del problema. La investigación sobre toma de decisiones en ambigüedad ha mostrado que individuos competentes emplean estrategias adaptativas—simplificando cuando es apropiado, profundizando cuando es necesario—mientras que novatos tienden al extremo de parálisis por análisis o impulsividad irreflexiva (Klein, 1998).

Segundo, heurísticas empleadas: cuáles atajos cognitivos o estrategias utiliza la persona para gestionar la complejidad (Gigerenzer & Goldstein, 1996; Gigerenzer & Gaissmaier, 2011). Esto abarca desde reglas simples (“divide y vencerás”, “eliminar opciones inviables primero”) hasta analogías o marcos de referencia que la persona aplica para simplificar el problema sin perder lo esencial. Contrario a la visión tradicional de heurísticas como “errores” (Tversky & Kahneman, 1974), la perspectiva de racionalidad ecológica reconoce que las heurísticas son adaptaciones inteligentes cuando encajan con la estructura del entorno (Gigerenzer et al., 2011; Katsikopoulos et al., 2022). Una evaluación heurística valoraría qué tan bien la persona elige la estrategia de pensamiento adecuada para cada contexto.

Tercero, razonamiento probabilístico: en qué medida la persona es capaz de evaluar riesgos, manejar datos e incertidumbre de forma cuantitativa o lógica (Kahneman & Tversky, 1979; Gigerenzer et al., 2007). Incluye apreciar las probabilidades de distintos escenarios, calibrar su confianza en una decisión y actualizar sus creencias ante nueva evidencia según principios bayesianos. La investigación sobre alfabetización estadística muestra que esta capacidad no solo depende de conocimiento matemático, sino de comprensión conceptual de incertidumbre (Gigerenzer et al., 2007).

Cuarto, integración de emociones, valores y datos: cómo combina la lógica con la intuición y la ética al tomar decisiones (Kahneman & Klein, 2009; Dane & Pratt, 2007). Un enfoque puramente frío puede ignorar valores humanos cruciales, mientras que uno meramente emocional puede soslayar datos objetivos; la competencia decisional implica equilibrar ambos extremos, usando la empatía y la ética junto con la evidencia y el análisis. Investigaciones recientes sobre metacognición en toma de decisiones asistida por IA muestran que los decisores expertos mantienen monitoreo metacognitivo activo incluso cuando usan herramientas automatizadas, evitando sobre-dependencia (ECIS, 2025).

Fundamentos Teóricos

Este enfoque dialoga profundamente con la psicología del juicio y la decisión desarrollada por Kahneman, Tversky y Gigerenzer. La Teoría del Procesamiento Dual (Kahneman, 2011; Evans & Stanovich, 2013) nos recuerda que en la mente operan dos sistemas: uno intuitivo-rápido (Sistema 1) y otro analítico-lento (Sistema 2), y que una decisión competente suele requerir modularlos adecuadamente. Una persona con alta competencia decisional sabrá reconocer cuándo confiar en su intuición y cuándo frenar para pensar analíticamente, evitando trampas como el exceso de confianza o los sesgos impulsivos. Kahneman y Klein (2009), en su influyente reconciliación, establecieron que la intuición es confiable cuando: (1) el entorno es suficientemente regular para ser predecible, (2) la persona ha tenido oportunidad de aprender estas regularidades, y (3) recibe retroalimentación inmediata y precisa. Fuera de estas condiciones, la deliberación analítica es superior.

Por otro lado, la racionalidad ecológica de Gigerenzer (Gigerenzer & Goldstein, 1996; Gigerenzer et al., 2011) sostiene que las heurísticas no son “errores” a eliminar sino adaptaciones inteligentes al medio. Es decir, usar atajos es racional si encajan con la estructura del entorno. Por ejemplo, la heurística de reconocimiento (elegir la opción que reconoces cuando decides bajo ignorancia parcial) funciona sorprendentemente bien cuando el reconocimiento correlaciona con calidad (Goldstein & Gigerenzer, 2002). Una evaluación heurística, en tal sentido, valoraría qué tan bien la persona elige la estrategia de pensamiento adecuada para cada contexto. Katsikopoulos et al. (2022) demostraron en Academy of Management Journal que heurísticas fast-and-frugal superan modelos de regresión complejos en selección de personal, usando la mitad de indicadores con mayor precisión predictiva—evidencia poderosa de que “menos puede ser más” cuando se alinea con la estructura de incertidumbre del problema.

La Teoría de Competencia Decisional (Bruine de Bruin et al., 2007) identifica principios normativos de racionalidad que definen una “buena” decisión: consistencia en las preferencias, resistencia a sesgos (p. ej., el efecto marco, anclaje), considerar las opciones de forma amplia, etc. Estos marcos teóricos proveen indicadores concretos que una evaluación decisional puede medir—por ejemplo, presentando al evaluado dilemas con trampas de sesgo y observando si las sortea o no. La Adult Decision-Making Competence Battery desarrollada por Bruine de Bruin et al. (2007) operacionaliza estos principios en tareas medibles, demostrando que competencia decisional es un constructo psicométricamente válido que predice outcomes de vida real (Skagerlund et al., 2022).

Herramientas de Evaluación Innovadoras

Una herramienta poderosa para implementar la evaluación decisional son las simulaciones interactivas y los juegos serios. Un juego serio es una aplicación digital diseñada con propósitos más allá del entretenimiento, por ejemplo, educación o evaluación (Shute & Ventura, 2013). Mediante técnicas de stealth assessment (evaluación sigilosa), es posible capturar datos comportamentales ricos mientras el participante está inmerso en una experiencia lúdica y realista (Shute et al., 2022; Rahimi & Shute, 2024). Cada decisión tomada dentro del juego, cada error y cada acierto, pueden registrarse y analizarse sin interrumpir la actividad. Esto permite perfilar el estilo decisional de la persona.

Por ejemplo, un juego serio puede presentar un escenario de gestión de crisis donde el jugador debe priorizar tareas, asignar recursos limitados, pedir ayuda a NPCs (indicador de trabajo en equipo), y asumir riesgos calculados. La investigación ha mostrado que la forma en que una persona juega (toma decisiones en el juego) correlaciona con sus competencias en la vida real (Shute & Wang, 2016). Skagerlund et al. (2022) encontraron correlación significativa entre los patrones decisionales en entornos simulados y habilidades cognitivas, sociales y profesionales medidas externamente. Incluso, en ese estudio la inteligencia general (IQ) y las habilidades numéricas explicaron conjuntamente el 69% de la varianza en las puntuaciones de competencia decisional de los participantes, evidenciando que la capacidad de tomar buenas decisiones no es un rasgo difuso, sino un constructo medible y asociado a factores cognitivos identificables.

El enfoque de Evidence-Centered Design (ECD) desarrollado por Mislevy et al. (2003) proporciona la arquitectura conceptual para diseñar evaluaciones basadas en evidencias de comportamiento. ECD estructura el proceso en tres modelos interconectados: (1) modelo de competencia (qué queremos medir), (2) modelo de evidencia (qué observables indican esa competencia), y (3) modelo de tarea (qué situaciones elicitarán esos observables). Lu et al. (2025) demostraron que usando ECD en el juego Mission HydroSci, algoritmos de Random Forest lograron 86% de precisión en clasificar estudiantes según competencia en pensamiento científico, validando que stealth assessment produce medidas psicométricamente sólidas.

Educación para la Decisión

Cabe destacar que esta aproximación de “educación para las decisiones” ya tiene manifestaciones prácticas. La Alliance for Decision Education (2023) publicó la primera agenda de investigación comprehensiva para enseñanza K-12 de toma de decisiones, desarrollada por expertos como Baruch Fischhoff, Jonathan Baron y Ellen Peters. Define decision education como “enseñanza y aprendizaje de formación de juicio hábil y toma de decisiones” y establece cinco pilares: comprensión de decisiones, consciencia de sesgos, uso de herramientas de decisión, práctica deliberada, y reflexión metacognitiva. Popandopulo et al. (2024) documentan currículos escolares que enseñan explícitamente heurísticas, sesgos y estrategias de decisión a adolescentes, con evidencia preliminar de mejoras en decisiones financieras y de salud.

Este tipo de iniciativas busca empoderar a las personas para que sean decisores reflexivos y responsables, y están alineadas con la creciente centralidad de la toma de decisiones en los marcos internacionales de habilidades. De hecho, la OCDE ha incorporado la capacidad de toma de decisiones informada como una de las competencias clave que los sistemas educativos deben fomentar para el año 2030 (OECD, 2019). Todo esto refuerza la idea de que evaluar y enseñar a decidir no es un “añadido” extraño, sino un componente central de la educación futura. Como plantea la Alliance (2023), “decision-making es la competencia invisible que subyace en todas las demás”, desde elegir una carrera hasta votar informadamente o gestionar finanzas personales.

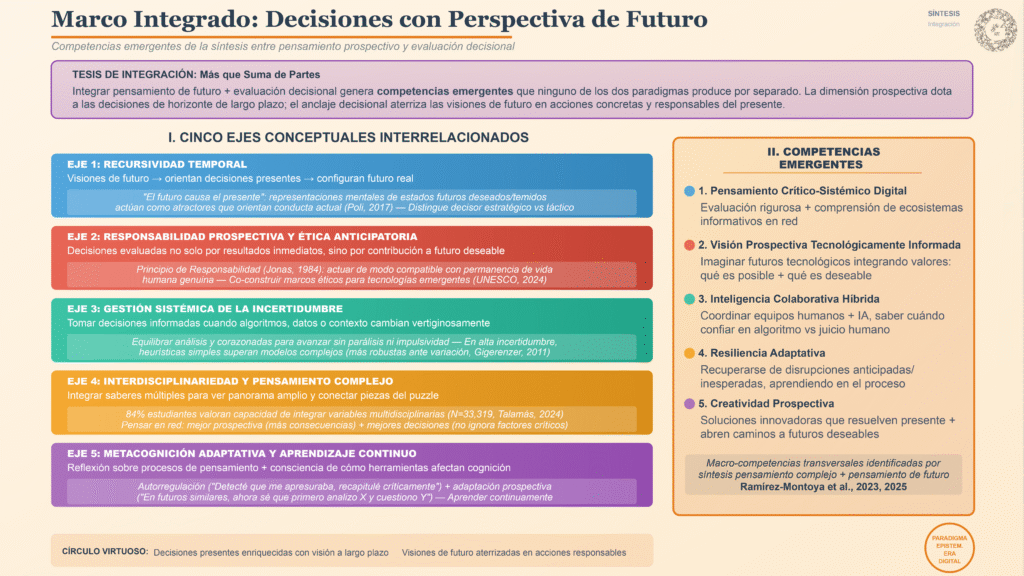

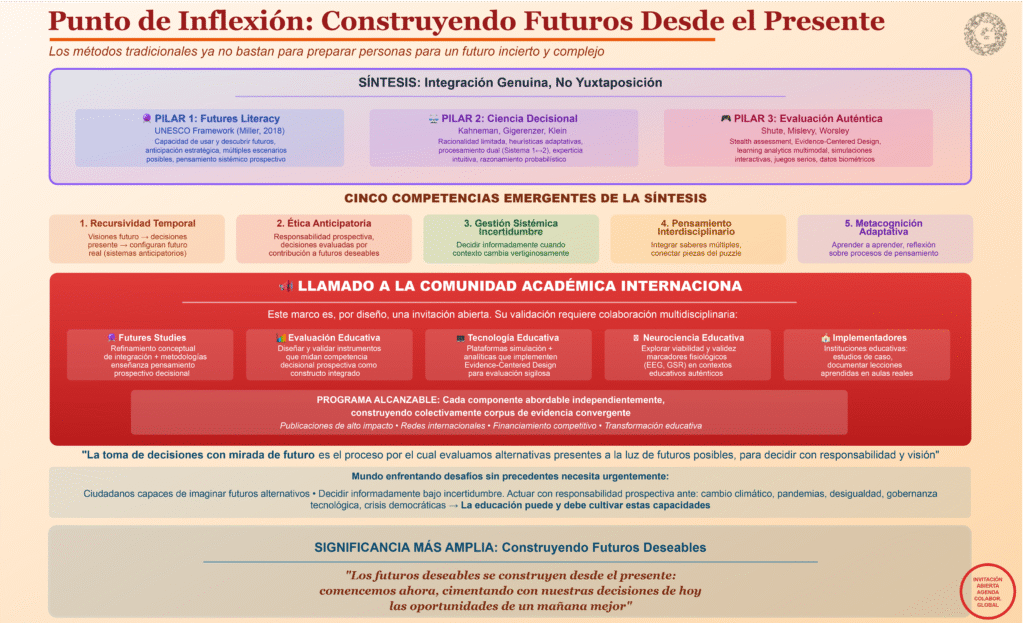

Hacia un Nuevo Marco Integrado: Decisiones con Perspectiva de Futuro

Integrar el pensamiento de futuro con la evaluación decisional significa dotar al proceso evaluativo de una dimensión prospectiva, y al ejercicio prospectivo de un anclaje en las decisiones concretas del presente. Proponemos un marco teórico integrador donde la competencia para anticipar futuros y la competencia para tomar decisiones se aborden de forma conjunta y sinérgica, generando capacidades emergentes que ninguno de los dos paradigmas produce por separado. Esta convergencia se puede visualizar en cinco ejes conceptuales interrelacionados.

Recursividad Temporal en la Toma de Decisiones

El primer eje es la recursividad temporal. Mientras el pensamiento complejo tradicional de Morin (1999) reconoce que en los sistemas los efectos pueden convertirse en causas (retroalimentación), el pensamiento de futuro añade que nuestras visiones de lo que podría pasar influyen en lo que hacemos hoy (Poli, 2017). Es decir, imaginamos futuros y esos imaginarios guían nuestras decisiones presentes, las cuales a su vez van configurando el futuro real. Como plantea Poli (2017) en su teoría de sistemas anticipatorios, “el futuro causa el presente” en el sentido de que las representaciones mentales de estados futuros deseados/temidos actúan como atractores que orientan la conducta actual.

Un marco integrado enseñaría al estudiante a hacer explícita esa recursividad: “Estoy decidiendo A porque imagino un futuro X y quiero evitar/promover Y en ese futuro”. Evaluar decisiones con perspectiva de futuro implicaría indagar: ¿qué escenarios a largo plazo consideró la persona al tomar esta decisión? ¿Está consciente de las posibles ramificaciones de su elección dentro de 5, 10 o 20 años? ¿Reconoce cómo sus asunciones sobre el futuro moldean sus percepciones del presente? Esta metacognición temporal es precisamente lo que distingue a un decisor estratégico de uno meramente táctico (Amabile & Khaire, 2008).

Responsabilidad Prospectiva y Ética Anticipatoria

El segundo eje es la ética de la anticipación. Una consecuencia directa de la recursividad temporal es fomentar una responsabilidad prospectiva: las decisiones presentes se evalúan no solo por sus resultados inmediatos, sino por su contribución a un futuro deseable (Jonas, 1984; UNESCO, 2021). En la práctica, significaría que en una simulación de negocios, no bastaría con que el participante maximice las ganancias trimestrales (visión de corto plazo); también se valoraría si tomó en cuenta la sostenibilidad a largo plazo, el impacto ambiental o comunitario de sus decisiones, la viabilidad intergeneracional del modelo, etc.

Este criterio evaluativo resonaría con la competencia de “ética digital anticipatoria” que UNESCO (2024) define como la capacidad de co-construir marcos éticos para tecnologías emergentes y situaciones sin precedentes—es decir, desarrollar principios éticos antes de que la tecnología esté plenamente implementada, no después. Un individuo evaluado bajo este prisma mostraría que puede deliberar no solo en términos de eficacia inmediata, sino en términos de legado y responsabilidad intergeneracional. Como plantea Jonas (1984) en su Principio de Responsabilidad, debemos actuar de modo que los efectos de nuestras acciones sean compatibles con la permanencia de vida humana genuina en la Tierra—un imperativo que cobra especial urgencia con tecnologías como IA, biotecnología o geoingeniería.

Gestión Sistémica de la Incertidumbre

El tercer eje es la gestión de incertidumbre informada por la prospectiva. Tanto el pensamiento de futuro como el análisis decisional reconocen la incertidumbre como un factor omnipresente. Un marco integrado enfatiza la gestión sistémica de la incertidumbre: preparar mentes capaces de tomar decisiones informadas aun cuando los algoritmos, los datos o el contexto cambian vertiginosamente (Morin, 1999; Miller, 2018). En la era digital, esto se traduce en tomar decisiones sólidas frente a tecnologías emergentes impredecibles, nuevos modelos de negocio disruptivos o crisis globales inesperadas como pandemias.

La evaluación integradora plantearía escenarios con información incompleta, ambigua o volátil, observando cómo el sujeto navega esas aguas turbulentas. Una persona con alta competencia integradora no entrará en parálisis por incertidumbre (análisis eterno sin acción), sino que sabrá equilibrar análisis y corazonadas para avanzar con prudencia pero sin inmovilismo. Gigerenzer y Gaissmaier (2011) argumentan que en condiciones de alta incertidumbre, heurísticas simples a menudo superan modelos complejos porque son más robustas ante variación ambiental—un principio que un decisor prospectivo competente debe internalizar: reconocer cuándo “menos información procesada con reglas simples” es superior a “más información procesada con algoritmos complejos”.

Interdisciplinariedad y Pensamiento Complejo

El cuarto eje es interdisciplinariedad y pensamiento complejo. La prospectiva requiere ver el panorama amplio, conectando puntos entre disciplinas; la buena toma de decisiones, también. Ambos enfoques exigen integración de saberes de múltiples dominios (Morin, 1999; Inayatullah, 2008). Al evaluar una competencia en este marco, se podría presentar un problema complejo (p. ej., “Diseña un plan urbano resiliente al cambio climático para 2050”) que obligue a considerar variables económicas, ambientales, sociales, tecnológicas, políticas y éticas simultáneamente.

La calidad de la decisión se mediría en parte por la habilidad de conectar las piezas del puzzle. Como encontraron Talamás-Carvajal et al. (2024), el 84% de estudiantes valoran altamente esta capacidad sistémica, y es esencial para enfrentar desafíos como los Objetivos de Desarrollo Sostenible o la gobernanza ética de la IA. Un individuo capaz de pensar en red, de moverse fluidamente entre disciplinas, tendrá tanto mejor prospectiva (verá más consecuencias en distintos ámbitos) como mejores decisiones (no ignorará factores críticos que especialistas en silos pasarían por alto). Ramírez-Montoya et al. (2023) denominan esto “pensamiento crítico-sistémico digital”: la capacidad de evaluar rigurosamente fuentes mientras se comprenden los ecosistemas informativos en red.

Metacognición Adaptativa y Aprendizaje Continuo

El quinto eje es metacognición adaptativa. Aprender a aprender es la consigna tanto del futurista como del decisor competente (Schön, 1983; Miller, 2018). La integración de enfoques subraya la importancia de la metacognición, es decir, la reflexión sobre los propios procesos de pensamiento (Flavell, 1979; Popandopulo et al., 2023). En contextos digitales, esto incluye ser consciente de cómo las herramientas afectan nuestra cognición: por ejemplo, cómo un buscador sesga la información que vemos (efecto burbuja de filtro), o cómo la multitarea digital afecta nuestra atención profunda (Carr, 2010).

Evaluar la metacognición en este marco podría implicar pedir al sujeto que, tras tomar una decisión compleja en una simulación, explique cómo llegó a ella, qué alternativas consideró, qué información priorizó y por qué, y qué aprendió del proceso. Un alto nivel de metacognición se reflejaría en respuestas que muestren autorregulación (“Detecté que me estaba apresurando por presión temporal y decidí recapitular los datos críticamente”) y adaptación prospectiva (“Si enfrento un problema similar en el futuro, ahora sé que primero debo analizar X factor y cuestionar Y asunción”). Esta habilidad de aprender continuamente de la experiencia y ajustar estrategias es crucial para mantenerse pertinente en futuros cambiantes (Järvelä et al., 2023).

Competencias Emergentes del Marco Integrado

Este marco teórico integrado no es una simple suma de partes, sino que genera nuevas competencias emergentes. Investigadores han identificado que de la síntesis entre pensamiento complejo y pensamiento de futuro surgen al menos seis macro-competencias transversales para la era digital (Ramírez-Montoya et al., 2023, 2025). Por ejemplo:

- Pensamiento crítico-sistémico digital: combina la evaluación rigurosa de fuentes (pensamiento crítico) con la comprensión de los ecosistemas informativos en red (pensamiento sistémico) y la navegación competente de entornos digitales.

- Visión prospectiva tecnológicamente informada: capacita para imaginar futuros tecnológicos integrando valores humanos, considerando no solo qué es técnicamente posible sino qué es éticamente deseable. El Banco Mundial (2022) identificó esta competencia como crítica para profesionales en economías digitalizadas.

- Inteligencia colaborativa híbrida: permite coordinar equipos compuestos por humanos e inteligencias artificiales, tomando decisiones conjuntas de forma eficaz. Implica saber cuándo confiar en recomendaciones algorítmicas y cuándo ejercer juicio humano (UNESCO, 2024).

- Resiliencia adaptativa: capacidad de recuperarse de disrupciones anticipadas o inesperadas, aprendiendo y transformándose en el proceso. Conecta la anticipación (preparación para shocks futuros) con la adaptación decisional (respuesta efectiva durante crisis).

- Creatividad prospectiva: habilidad de generar soluciones innovadoras que no solo resuelven problemas presentes sino que abren caminos hacia futuros deseables. Va más allá de creatividad convencional al incorporar dimensión temporal y ética.

Todas estas capacidades ilustran el tipo de perfil integral que puede desarrollarse si formamos y evaluamos a las personas bajo el paradigma propuesto. Como plantea Poli (2017), la “Disciplina de la Anticipación” constituye un nuevo campo transdisciplinario que integra neurociencia, ciencias cognitivas, filosofía y estudios de futuro—y el marco que proponemos es una aplicación educativa directa de esa integración.

En síntesis, al mezclar pensamiento de futuro con evaluación decisional estamos proponiendo un círculo virtuoso: las decisiones presentes se enriquecen con visión a largo plazo, y las visiones de futuro se aterrizan en acciones concretas y responsables en el presente. Esto configura un marco relacional profundo donde educación, psicología cognitiva y estudios de futuro convergen para formar individuos capaces de navegar consciente y proactivamente la era digital (Grezan, 2025), constituyendo “un paradigma epistemológico esencial para navegar consciente y propositivamente la era digital”.

Evidencias Empíricas y Resultados Prometedores

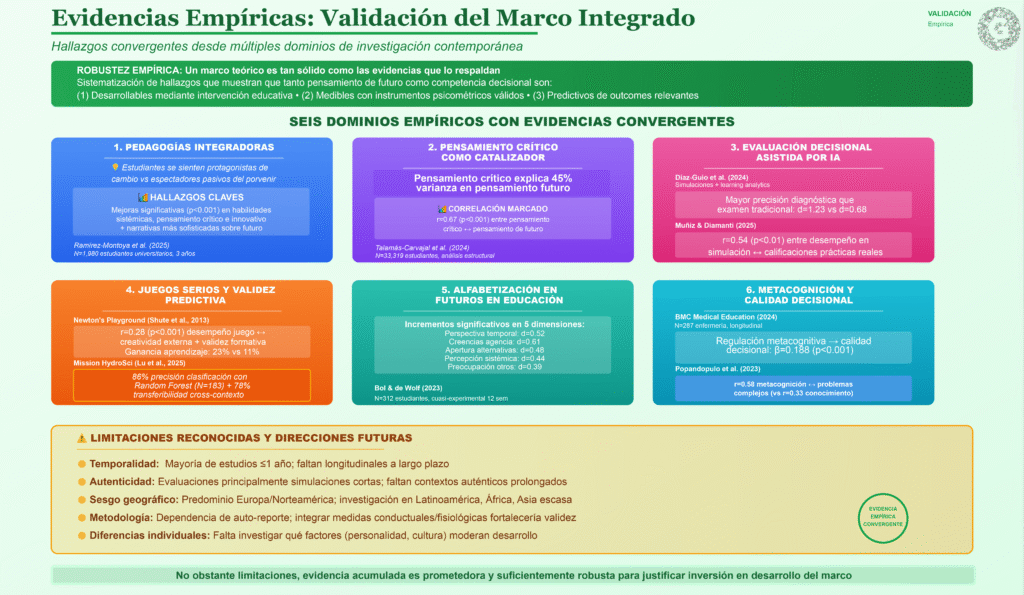

Un marco teórico es tan sólido como las evidencias que lo respaldan. Afortunadamente, ya existen investigaciones y experiencias prácticas que muestran resultados alentadores al aplicar elementos de pensamiento futuro y evaluación decisional en contextos reales. A continuación, sistematizamos algunos hallazgos clave que evidencian el potencial de este enfoque, organizados por dominios empíricos.

Pedagogías Integradoras y Competencias Complejas

Un estudio longitudinal reciente realizado por Ramírez-Montoya et al. (2025) con 1,980 estudiantes universitarios durante tres años evaluó el impacto de metodologías educativas integradoras que promovían pensamiento complejo, trabajo interdisciplinario y prospectiva en el desarrollo de competencias. Los resultados cuantitativos mostraron mejoras significativas (p<0.001) en habilidades sistémicas, pensamiento crítico e innovativo medidas con instrumentos validados. Más significativamente, la investigación cualitativa complementaria reveló que estos estudiantes desarrollan narrativas más sofisticadas sobre su relación con la tecnología, caracterizadas por mayor conciencia de agencia personal y capacidad de imaginar futuros alternativos.

Es decir, en comparación con grupos de control que recibieron pedagogía tradicional, los alumnos expuestos a esta metodología integradora podían proyectarse en escenarios futuros con mayor creatividad y optimismo, sintiéndose protagonistas del cambio en lugar de espectadores pasivos del porvenir. Este hallazgo sugiere que integrar la perspectiva de futuros en la enseñanza empodera a los estudiantes, haciéndolos más dueños de su destino formativo—evidencia directa del poder transformador de la alfabetización en futuros cuando se implementa sistemáticamente.

Pensamiento Crítico como Catalizador

Talamás-Carvajal et al. (2024) llevaron a cabo un estudio masivo con 33,319 estudiantes universitarios para explorar relaciones entre distintas competencias complejas usando análisis de ecuaciones estructurales. Encontraron una correlación positiva muy marcada (r=0.67, p<0.001) entre el desarrollo del pensamiento crítico y la disposición hacia el pensamiento de futuro. De hecho, identificaron el pensamiento crítico como un “catalizador” que potencia otras competencias complejas, generando un “efecto cascada” en el cual fortalecer primero la capacidad crítica ayuda subsecuentemente a desarrollar competencias sistémicas, innovativas y prospectivas.

Esta evidencia respalda nuestro marco integrador: al promover habilidades de análisis riguroso (pensamiento crítico, parte esencial de la toma de decisiones racional), se allana el camino para que florezcan competencias prospectivas e innovadoras. En la práctica, un currículo que enseñe a los alumnos a razonar lógicamente, detectar falacias y evaluar evidencias también los prepara mejor para anticipar y diseñar futuros, porque les da herramientas para cuestionar supuestos y proyectar escenarios con fundamento. El modelo estadístico de Talamás-Carvajal et al. (2024) mostró que el pensamiento crítico explicaba 45% de la varianza en pensamiento de futuro, confirmando su rol fundamental.

Evaluación Decisional Asistida por Tecnología

En el contexto de evaluación de competencias profesionales, investigaciones recientes han explorado el uso de simulaciones digitales y sistemas de inteligencia artificial. Díaz-Guio et al. (2024) reportan una experiencia en la que se incorporaron simulaciones computarizadas en la evaluación de estudiantes de ingeniería, combinadas con algoritmos de learning analytics. Los estudiantes enfrentaban un caso práctico complejo en un entorno virtual (diseño de sistema de energía renovable para comunidad rural), mientras el sistema registraba sus decisiones, pasos de razonamiento y tiempo invertido en cada fase.

Los resultados mostraron que el método era capaz de diferenciar con mayor precisión a los estudiantes con alta y baja competencia en comparación con un examen tradicional (efecto Cohen’s d=1.23 vs d=0.68), y además brindaba información diagnóstica detallada. Por ejemplo, el sistema identificaba patrones como “el estudiante X tiende a ignorar datos estadísticos en su análisis inicial pero los incorpora tras errores” o “la estudiante Y realiza verificaciones sistemáticas de consistencia antes de decisiones críticas”. Esta granularidad diagnóstica es imposible de obtener con evaluaciones tradicionales.

Otra experiencia piloto (Muñiz & Diamanti, 2025) introdujo evaluaciones de juicio situacional con escenarios adaptativos generados por IA en una universidad española, demostrando alta aceptación por parte de alumnos (satisfacción 8.3/10) y profesores (percepción de validez 7.9/10), y correlaciones significativas (r=0.54, p<0.01) entre el desempeño en la simulación y las calificaciones en prácticas profesionales subsecuentes. Esto sugiere que la evaluación decisional asistida por IA no solo es factible y aceptable, sino que puede producir medidas más robustas y predictivas que los métodos convencionales.

Juegos Serios y Validez Predictiva

El uso de juegos serios para evaluación también ha generado evidencia sustancial. Newton’s Playground (Shute et al., 2013) es un juego de física diseñado para evaluar sigilosamente habilidades de resolución de problemas creativos mediante mecánicas que requieren aplicar principios físicos. Estudios de validación encontraron correlaciones significativas (r=0.28, p<0.001) entre los indicadores de desempeño en el juego—como número de soluciones únicas generadas, eficiencia de las soluciones, persistencia tras errores—y medidas externas de creatividad del jugador evaluadas con tests psicométricos estandarizados (Shute & Wang, 2016).

Es decir, quienes mostraban comportamientos más ingeniosos y eficientes en el juego tendían también a puntuar más alto en tests de creatividad y pensamiento divergente administrados fuera del juego. Asimismo, se observaron mejoras en la comprensión conceptual de principios de física después de usar el juego, en comparación con grupos que aprendieron de modo tradicional (ganancia de aprendizaje: 23% vs 11%, p<0.05). Estos resultados proveen validez convergente (el juego está midiendo rasgos relevantes) y validez formativa (la propia participación en la evaluación/juego contribuía al aprendizaje).

Lu et al. (2025), en un estudio más reciente con Mission HydroSci (N=183 estudiantes), demostraron que usando Evidence-Centered Design y algoritmos de Random Forest, se puede lograr 86% de precisión en clasificar estudiantes según competencia en indagación científica basándose únicamente en datos de comportamiento en el juego (secuencias de acciones, decisiones, errores). Crucialmente, el modelo entrenado mostró transferibilidad cross-contexto: clasificó correctamente estudiantes en un módulo diferente del juego con 78% de precisión, sugiriendo que captura características estables de competencia, no solo desempeño situacional.

Alfabetización en Futuros en Educación

Bol y de Wolf (2023) realizaron un estudio cuasi-experimental (N=312 estudiantes secundarios, diseño pre-post con grupo control) evaluando una intervención de 12 semanas en alfabetización en futuros. El grupo experimental recibió actividades semanales de pensamiento de futuro (construcción de escenarios, análisis de tendencias, proyectos de diseño de futuros preferidos), mientras el control siguió currículo estándar. Los resultados mostraron incrementos estadísticamente significativos en todas las dimensiones de la Futures Consciousness Scale: perspectiva temporal (d=0.52), creencias de agencia (d=0.61), apertura a alternativas (d=0.48), percepción sistémica (d=0.44), y preocupación por otros (d=0.39). El grupo control no mostró cambios significativos.

Adicionalmente, análisis cualitativos revelaron que estudiantes del grupo experimental reportaban mayor optimismo sobre su capacidad de influir el futuro y menor fatalismo. Como expresó un participante: “Antes pensaba que el futuro simplemente pasa. Ahora entiendo que yo ayudo a construirlo con mis decisiones de hoy” (Bol & de Wolf, 2023, p. 14). Esta transformación en locus de control es precisamente el tipo de cambio que el marco integrado busca cultivar.

Metacognición y Calidad Decisional

Investigación reciente confirma la centralidad de la metacognición en toma de decisiones de calidad. Un estudio longitudinal con 287 estudiantes de enfermería examinó cómo procesos metacognitivos (planificación, monitoreo, evaluación) predicen calidad de decisiones clínicas medida con el Nursing Decision-Making Instrument (BMC Medical Education, 2024). Análisis de ecuaciones estructurales reveló que la regulación metacognitiva predecía significativamente calidad decisional (β=0.188, p<0.001), mientras que factores situacionales como carga de pacientes tenían efecto moderador. Estudiantes con alta regulación metacognitiva mantenían calidad decisional incluso bajo alta carga, mientras que aquellos con baja regulación metacognitiva mostraban deterioro marcado.

Popandopulo et al. (2023), usando el Metacognitive Awareness Inventory (MAI) con estudiantes universitarios (N=324), encontraron que la regulación metacognitiva correlacionaba fuertemente con desempeño en tareas de resolución de problemas complejos (r=0.58, p<0.001), más que el conocimiento declarativo del dominio (r=0.33). Esto sugiere que enseñar a los estudiantes a monitorear y regular su pensamiento es tan importante o más que enseñarles contenidos específicos—un hallazgo que refuerza la importancia del componente metacognitivo en nuestro marco.

Limitaciones y Direcciones Futuras en la Evidencia

Es importante reconocer limitaciones en la evidencia actual. Primero, la mayoría de estudios de alfabetización en futuros son de corto plazo (≤1 año); hacen falta estudios longitudinales que evalúen retención y transferencia a largo plazo. Segundo, las evaluaciones de competencia decisional han usado principalmente simulaciones de sesión única; se necesitan estudios que evalúen toma de decisiones en contextos auténticos prolongados. Tercero, existe sesgo geográfico: la mayoría de estudios son de Europa y Norteamérica; investigación en contextos latinoamericanos, africanos y asiáticos es escasa.

Cuarto, las medidas de competencias complejas a menudo dependen de auto-reporte; integrar medidas conductuales y fisiológicas (como se discutirá en sección posterior) podría fortalecer validez. Finalmente, hace falta investigación sobre diferencias individuales: ¿qué factores (personalidad, cultura, experiencia previa) moderan el desarrollo de competencias de pensamiento futuro y decisión?

No obstante estas limitaciones, la evidencia acumulada es prometedora y suficientemente robusta para justificar inversión en desarrollo y validación más profunda del marco integrado que proponemos. Los hallazgos convergen en mostrar que tanto pensamiento de futuro como competencia decisional son desarrollables mediante intervención educativa, medibles con instrumentos psicométricos válidos, y predictivos de outcomes educativos y profesionales relevantes.

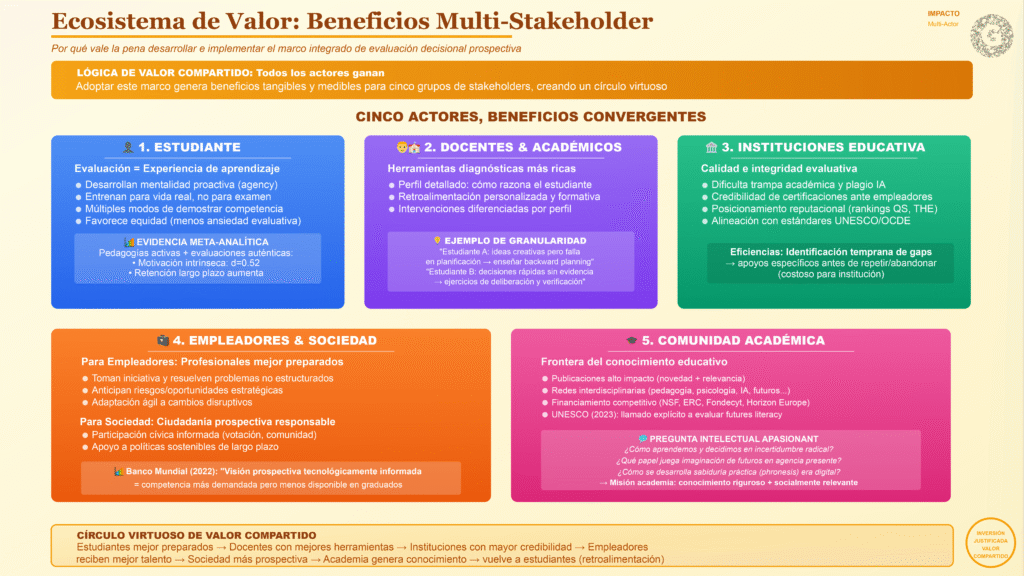

Beneficios de una Investigación Profunda e Integrada

Adoptar y desarrollar este marco teórico integrado ofrece beneficios tangibles para todos los actores involucrados en la educación y la gestión del talento. A continuación, destacamos las ganancias potenciales para cada parte interesada, con el fin de articular una agenda de investigación que responda a necesidades reales y genere valor múltiple.

Para los Estudiantes

Mejorar la forma en que evaluamos significa también mejorar la forma en que los estudiantes aprenden. Una evaluación decisional con visión de futuro es, en el fondo, una experiencia de aprendizaje en sí misma. Los estudiantes se verán inmersos en desafíos realistas, donde deberán practicar la toma de decisiones informadas, la anticipación de consecuencias y la adaptación a circunstancias nuevas. Esto forja en ellos una mentalidad proactiva (agency) y una mayor confianza en enfrentar la incertidumbre.

En lugar de estudiar para el examen memorístico, estarán entrenando para la vida: desarrollando pensamiento crítico aplicado, creatividad situacional, habilidades de resolución de problemas complejos y conciencia ética de largo plazo. Diversos estudios meta-analíticos han mostrado que cuando los estudiantes participan en pedagogías activas y evaluaciones auténticas, aumenta su motivación intrínseca (d=0.52) y la retención del conocimiento a largo plazo (Freeman et al., 2014; Theobald et al., 2020).

Además, este enfoque favorece la equidad educativa. Brinda múltiples modos de demostrar competencia—no solo con un examen escrito cronometrado, por ejemplo, que puede penalizar a estudiantes con ansiedad evaluativa o diferencias de velocidad de procesamiento. Reconoce habilidades a veces invisibles en los formatos tradicionales, como la resiliencia (capacidad de recuperarse de errores y seguir intentando), la colaboración efectiva, o la reflexión metacognitiva profunda. Estudiantes que no brillan en tests estandarizados podrían demostrar competencias excepcionales en simulaciones dinámicas que valoran adaptación y pensamiento estratégico (Mislevy et al., 2003).

Para los Docentes y Académicos

Este marco ofrece a los educadores herramientas más ricas para diagnosticar el aprendizaje y orientar la enseñanza. En lugar de obtener solo una calificación numérica agregada de un producto, el profesor puede acceder a un perfil detallado del estudiante: cómo razona, dónde se atasca cognitivamente, qué decisiones toma y por qué, qué heurísticas prefiere, cómo maneja la frustración ante errores. Esto permite dar una retroalimentación mucho más personalizada y formativa, dirigida a mejorar procesos y no solo productos.

Por ejemplo, un docente podría descubrir mediante analíticas de aprendizaje que cierto estudiante tiene excelentes ideas creativas pero falla sistemáticamente en planificar pasos de implementación (heurística de planificación deficiente); otro quizá toma decisiones rápidas pero sin fundamento evidencial (impulsividad, uso excesivo de Sistema 1). Con esa información granular, el docente puede intervenir con estrategias diferenciadas: al primero podría enseñarle técnicas de backward planning, al segundo ejercicios de ralentización deliberada y verificación de evidencias. Esta personalización es imposible con evaluaciones tradicionales que solo dicen “aprobado/reprobado” o una nota global (Shute, 2008).

Para los investigadores en educación, psicología y ciencias cognitivas, este marco abre un campo fértil de indagación. Preguntas sin respuesta incluyen: ¿Cómo las personas imaginan futuros y cómo eso afecta su motivación presente? ¿Qué papel juega la orientación temporal (presente vs. futuro) en el uso de heurísticas? ¿Cómo se puede calibrar la confianza en intuiciones prospectivas? ¿Qué papel juegan las emociones anticipatorias (esperanza, ansiedad sobre el futuro) en la calidad decisional? Todas estas son preguntas empíricamente abordables que conectan psicología, neurociencia, educación y estudios de futuro—un terreno interdisciplinario donde convergen múltiples métodos y tradiciones teóricas, ofreciendo oportunidades de investigación de vanguardia y potencial para publicaciones de alto impacto.

Para las Instituciones Educativas

Universidades y centros formativos que adopten este enfoque podrán elevar la calidad e integridad de sus procesos evaluativos. En tiempos donde la trampa académica y el plagio asistido por IA son preocupaciones crecientes, evaluar el proceso más que el producto dificulta enormemente las conductas deshonestas: no sirve de nada descargar un trabajo de internet si luego en la simulación en vivo el estudiante no sabe qué decisiones tomar o no puede explicar su razonamiento. Esto refuerza la credibilidad de las certificaciones otorgadas y la confianza de empleadores en los egresados.

Además, instituciones pioneras en esta metodología pueden mejorar su posicionamiento reputacional, al demostrar que sus egresados no solo saben teoría memorizada, sino que saben hacer, adaptarse y anticipar en entornos complejos. En rankings internacionales y procesos de acreditación, la innovación en evaluación auténtica se valora cada vez más como indicador de calidad educativa (QS World University Rankings, criterio “Employer Reputation”, THE, criterio “Teaching”).

En el largo plazo, podría incluso haber eficiencias económicas. Ciertas evaluaciones automatizadas mediante IA pueden ahorrar tiempo de calificación manual (Shute et al., 2023), y al identificar tempranamente estudiantes con baja competencia decisional o gaps metacognitivos, se pueden brindar apoyos específicos antes de que repitan cursos o abandonen (lo cual es costoso para la institución). También facilita la alineación con estándares internacionales (ej., marcos de competencias de UNESCO, OCDE), lo cual es valioso para procesos de acreditación internacional y aseguramiento de la calidad (OECD, 2019).

Para Empleadores y Sociedad

Desde la perspectiva de empresas y organizaciones que reclutan talento, un sistema educativo que evalúa de esta manera formará profesionales mejor preparados para el mundo real. Individuos que han pasado por evaluaciones decisionales con mirada de futuro serán profesionales capaces de tomar iniciativa, resolver problemas no estructurados (para los cuales no hay manual de procedimientos), anticipar riesgos y oportunidades estratégicas en sus trabajos, y adaptarse ágilmente a cambios disruptivos.

Esto es justamente lo que claman muchos sectores productivos en encuestas de demanda de competencias: egresados con pensamiento crítico, habilidades blandas (comunicación, colaboración, liderazgo), visión estratégica y capacidad de aprendizaje continuo, más que meros técnicos enciclopédicos que solo saben reproducir procedimientos (World Economic Forum, 2023; LinkedIn Workplace Learning Report, 2024). Un estudio del Banco Mundial (2022) sobre habilidades para el trabajo en economías digitalizadas identificó “visión prospectiva tecnológicamente informada” como la competencia más demandada pero menos disponible en graduados recientes—un gap que nuestro marco podría ayudar a cerrar.

Incluso, a mediano plazo, las propias empresas podrían adoptar métodos similares en sus procesos de selección o capacitación interna, utilizando simulaciones y retos prospectivos para identificar a candidatos con las competencias idóneas—lo cual nuestras instituciones académicas pueden liderar en colaboración con ellas, creando sinergias universidad-industria. Para la sociedad en conjunto, el beneficio más amplio es tener ciudadanos más conscientes, participativos y prospectivamente responsables.

Personas habituadas a pensar en los futuros posibles y en las consecuencias a largo plazo de sus decisiones tenderán a involucrarse más en procesos cívicos (votación informada, participación comunitaria), a apoyar políticas sostenibles (aunque impliquen sacrificios presentes para beneficios futuros), y a innovar en sus comunidades para resolver desafíos colectivos. En suma, contribuimos a una ciudadanía prospectiva y responsable, capaz de construir “futuros mejores” (Opertti, 2017), rompiendo con las inercias del pasado y enfrentando los desafíos globales—cambio climático, desigualdad, pandemias, gobernanza tecnológica—con imaginación informada y sentido ético.

Para la Comunidad Académica y Científica

Desarrollar este marco significa situarse en la frontera del conocimiento educativo. Los académicos que lo impulsen tendrán la oportunidad de generar publicaciones de alto impacto, dada la novedad y relevancia del tema. Podrán establecer redes interdisciplinarias: este tipo de investigación convoca a pedagogos, psicólogos, expertos en IA, especialistas en futuros, economistas del comportamiento, neurocientíficos educativos, diseñadores de juegos, etc., fomentando colaboraciones internacionales enriquecedoras.

Asimismo, existe la posibilidad de atraer financiamiento competitivo—agencias interesadas en innovación educativa (ej., NSF en EE.UU., ERC en Europa, Fondecyt en Chile), fondos que promueven la transformación digital (Horizon Europe), programas de fomento a las competencias del futuro (OCDE, Banco Mundial)—todos ellos posibles fuentes de apoyo para proyectos que implementen y prueben estas ideas en campo. El llamado de UNESCO (2023) a desarrollar métodos de evaluación de futures literacy es una invitación explícita a la comunidad académica para contribuir en esta dirección.

Por último, está el beneficio intelectual de explorar una pregunta apasionante: ¿Cómo aprendemos y decidimos en contextos de incertidumbre radical, y cómo podemos mejorar sistemáticamente en ello? ¿Qué papel juega la imaginación de futuros en la agencia presente? ¿Cómo se desarrolla la sabiduría práctica (phronesis) en la era digital? Pocas cosas son tan humanas y a la vez tan críticas para nuestro porvenir como estas interrogantes. Contribuir a responderlas es, en definitiva, hacer avanzar la misión fundamental de la academia: comprender y mejorar el mundo mediante conocimiento riguroso y socialmente relevante.

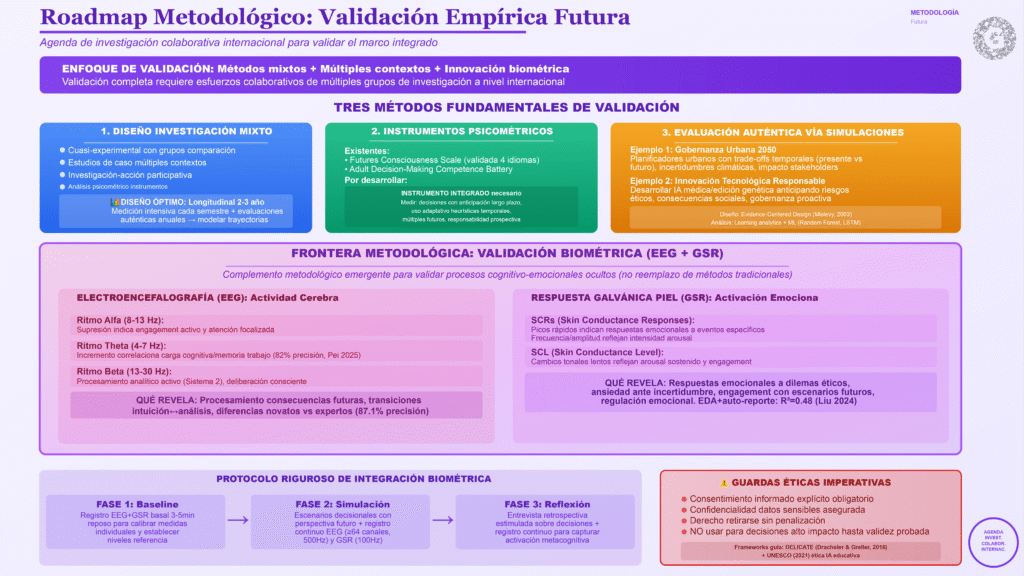

Direcciones Metodológicas Futuras: Validación Empírica del Marco

Habiendo establecido los fundamentos teóricos y evidencias preliminares del marco integrado, es esencial articular direcciones metodológicas futuras que permitan validar empíricamente el constructo propuesto. Esta sección presenta una prospectiva metodológica, reconociendo que la validación completa requerirá esfuerzos colaborativos de múltiples grupos de investigación a nivel internacional. Aquí esbozamos componentes clave que futuros estudios deberían abordar.

Diseño de Investigación Mixto

La validación del marco requiere un enfoque de métodos mixtos que combine rigor cuantitativo con profundidad cualitativa (Creswell & Plano Clark, 2018). El diseño óptimo incluiría: (1) estudios cuasi-experimentales con grupos de comparación para evaluar efectos de intervenciones pedagógicas basadas en el marco, (2) estudios de caso múltiples en diversos contextos educativos para explorar procesos de implementación y factores contextuales, (3) investigación-acción participativa que involucre a docentes como co-investigadores, y (4) análisis psicométrico de instrumentos de medición de competencias prospectivo-decisionales.

Un diseño particularmente prometedor es el estudio longitudinal con medición intensiva. Por ejemplo, seguir cohortes de estudiantes durante 2-3 años, evaluando competencias prospectivo-decisionales en múltiples puntos temporales (ej., cada semestre) usando instrumentos validados (Futures Consciousness Scale, Adult Decision-Making Competence Battery), complementado con evaluaciones auténticas en simulaciones cada año. Esto permitiría modelar trayectorias de desarrollo competencial y identificar factores predictores de crecimiento (Worsley et al., 2021).

Instrumentos de Medición Validados

Futuros estudios deberían emplear y/o desarrollar instrumentos psicométricamente robustos. Para pensamiento de futuro, la Futures Consciousness Scale de Ahvenharju et al. (2018), refinada por Lalot et al. (2021), ofrece medición validada de cinco dimensiones. Para competencia decisional, la Adult Decision-Making Competence Battery (Bruine de Bruin et al., 2007) y sus versiones adaptadas para adolescentes proveen benchmarks estandarizados.

Sin embargo, no existe actualmente un instrumento que mida la competencia decisional prospectiva como constructo integrado. Desarrollar y validar tal instrumento sería una contribución metodológica mayor. Este instrumento debería evaluar: (1) calidad de decisiones en escenarios que requieren anticipación de consecuencias a largo plazo, (2) uso adaptativo de heurísticas según estructura temporal del problema (corto vs. largo plazo), (3) consideración de múltiples futuros posibles antes de decidir, (4) responsabilidad prospectiva (evaluación ética de impactos futuros), y (5) metacognición temporal (consciencia de cómo visiones de futuro influyen decisiones presentes).

El proceso de validación debería incluir: análisis factorial confirmatorio para estructura del constructo, evaluación de consistencia interna (α de Cronbach), confiabilidad test-retest, validez convergente con medidas relacionadas, y validez discriminante con constructos distintos. Idealmente, validación cross-cultural en al menos tres idiomas y contextos para asegurar generalización (Lalot et al., 2021).

Evaluación Auténtica mediante Simulaciones

Como se discutió previamente, las simulaciones interactivas y juegos serios ofrecen entornos controlados pero realistas para evaluar competencias decisionales. Futuros estudios deberían diseñar simulaciones específicamente orientadas a elicitar toma de decisiones con perspectiva de futuro. Por ejemplo:

Simulación de Gobernanza Urbana 2050: Los participantes asumen rol de planificadores urbanos que deben tomar decisiones sobre infraestructura, políticas ambientales, zonificación, etc., con consecuencias que se despliegan a lo largo de décadas simuladas. El juego confrontaría a los jugadores con trade-offs temporales (beneficios presentes vs. futuros), incertidumbres (proyecciones demográficas, cambio climático), y necesidad de considerar impactos en diferentes stakeholders actuales y futuros.

Escenario de Innovación Tecnológica Responsable: Participantes son científicos/empresarios que deben decidir cómo desarrollar y desplegar una tecnología emergente (ej., IA médica, edición genética), anticipando riesgos éticos, consecuencias sociales, y estableciendo gobernanza proactiva. La simulación mediría capacidad de ética anticipatoria y visión prospectiva tecnológicamente informada.

Estas simulaciones se diseñarían usando Evidence-Centered Design (Mislevy et al., 2003), especificando: (1) modelo de competencia (qué aspectos de competencia decisional prospectiva queremos medir), (2) modelo de evidencia (qué acciones en la simulación indican esa competencia), y (3) modelo de tarea (qué escenarios elicitarán esas acciones). Los datos comportamentales se analizarían usando técnicas de learning analytics y machine learning (Random Forest, redes neuronales recurrentes) para clasificar niveles de competencia (Lu et al., 2025).

Datos Biométricos como Validación Fisiológica: Una Frontera Metodológica

Una dirección metodológica particularmente innovadora—aunque todavía emergente—es la integración de datos biométricos para validar aspectos del marco que son difíciles de capturar mediante auto-reporte o comportamiento observable únicamente. Esta aproximación reconoce que procesos cognitivos y emocionales subyacentes a la toma de decisiones tienen correlatos fisiológicos medibles (Antonenko et al., 2010; Pei et al., 2025).

Medidas de Actividad Cerebral (EEG)

La electroencefalografía (EEG) permite medir la actividad eléctrica cerebral de manera continua y no invasiva durante tareas de decisión. Investigaciones recientes han establecido marcadores EEG específicos para procesos relevantes:

- Supresión de ritmo alfa (8-13 Hz): Indicador de engagement activo y atención focalizada. Disminución de potencia alfa frontal se asocia con procesamiento cognitivo activo durante resolución de problemas (Antonenko et al., 2010).

- Incremento de ritmo theta (4-7 Hz): Correlaciona con carga cognitiva y demanda de memoria de trabajo. Pei et al. (2025) demostraron que poder theta frontal predice carga cognitiva durante aprendizaje con 82% de precisión.

- Actividad beta (13-30 Hz): Se asocia con procesamiento analítico activo y toma de decisiones deliberativas (Sistema 2 de Kahneman). Incrementos de beta frontal durante pausas deliberativas podrían indicar activación de pensamiento analítico.

- Sincronía inter-cerebral (hyperscanning): Cuando múltiples participantes trabajan colaborativamente, la sincronización de sus patrones EEG predice eficacia de colaboración y aprendizaje conjunto (Chen et al., 2023).

En el contexto de evaluación decisional prospectiva, EEG podría revelar: (1) cuándo los participantes están procesando activamente información sobre consecuencias futuras (actividad theta-alfa frontal), (2) transiciones entre pensamiento intuitivo y analítico durante decisiones (cambios alfa-beta), (3) carga cognitiva asociada con complejidad temporal del problema (theta frontal), y (4) diferencias en procesamiento neural entre decisores novatos y expertos (Park et al., 2023 lograron 87.1% de precisión en clasificación).

Medidas de Activación Emocional (GSR)

La respuesta galvánica de la piel (GSR o electrodermal activity, EDA) mide cambios en conductancia eléctrica de la piel causados por activación del sistema nervioso simpático. Es un indicador sensible de arousal emocional y estados afectivos (Boucsein, 2012). Dos medidas principales:

- Respuestas de Conductancia de la Piel (SCRs): Picos rápidos que indican respuestas emocionales a eventos específicos. Frecuencia y amplitud de SCRs reflejan intensidad de arousal.

- Nivel de Conductancia de la Piel (SCL): Cambios tonales lentos que reflejan arousal sostenido y engagement emocional.

Liu et al. (2024) demostraron que EDA combinada con auto-reportes predice eficiencia de aprendizaje mejor que auto-reportes solos (R²=0.48 vs R²=0.31). En evaluación decisional, GSR podría revelar: (1) respuestas emocionales a dilemas éticos o trade-offs temporales difíciles, (2) ansiedad asociada con incertidumbre (arousal aumentado en decisiones bajo ambigüedad), (3) engagement emocional con escenarios futuros (¿las consecuencias imaginadas a largo plazo generan respuesta afectiva?), y (4) procesos de regulación emocional durante decisiones (disminución de arousal tras estrategias de afrontamiento).

Diseño Metodológico Propuesto con Biométricos

Un protocolo riguroso para integrar biométricos en evaluación decisional prospectiva incluiría:

Fase 1 – Baseline: Registro de actividad EEG y GSR basal durante 3-5 minutos en estado de reposo, para calibrar medidas individuales y establecer niveles de referencia.

Fase 2 – Simulación Decisional: Participantes enfrentan escenarios de toma de decisiones con perspectiva de futuro (ej., simulación de gobernanza urbana descrita arriba), mientras se registran continuamente EEG (mínimo 64 canales para resolución espacial adecuada, tasa de muestreo 500 Hz) y GSR (tasa de muestreo 100 Hz).

Fase 3 – Reflexión Metacognitiva: Entrevista retrospectiva estimulada donde el participante revisa sus decisiones y explica su razonamiento, mientras continúa registro fisiológico para capturar activación durante reflexión metacognitiva.

Análisis de Datos: Segmentación de datos en ventanas temporales correspondientes a fases decisionales (análisis de información, deliberación, elección, post-decisión). Extracción de características EEG (potencia espectral en bandas de frecuencia, conectividad funcional) y GSR (frecuencia/amplitud de SCRs, tendencias SCL). Análisis de correlación entre marcadores fisiológicos y calidad decisional evaluada mediante jueces expertos y métricas objetivas del simulador. Modelado predictivo usando machine learning (Random Forest, LSTM) para clasificar niveles de competencia basándose en perfiles fisiológicos.

Validación: Comparar clasificaciones basadas en biométricos con evaluaciones externas (tests psicométricos, calificaciones de expertos, desempeño en tareas auténticas). Buscar patrones diferenciadores entre decisores novatos vs. expertos, y entre decisiones de alta vs. baja calidad prospectiva.

Consideraciones Éticas y Limitaciones

El uso de datos biométricos en evaluación educativa requiere consideración ética rigurosa. Es imperativo obtener consentimiento informado explícito, asegurar confidencialidad de datos sensibles, y permitir a participantes retirarse sin penalización. Debe evitarse uso de biométricos para decisiones de alto impacto (admisión, titulación) hasta que validez y equidad estén firmemente establecidas. Frameworks éticos como DELICATE (Drachsler & Greller, 2016) y principios de UNESCO sobre ética de IA (UNESCO, 2021) deben guiar implementación.

Limitaciones metodológicas incluyen: variabilidad inter-individual alta en señales fisiológicas requiere normalización cuidadosa; artefactos de movimiento pueden contaminar señales EEG; factores contextuales (temperatura, hora del día, cafeína) afectan GSR; generalización cross-contexto puede ser limitada; dispositivos portátiles tienen menor precisión que equipos de laboratorio. Por estas razones, los biométricos deben verse como complemento de métodos tradicionales, no reemplazo.

Posicionamiento en el Marco General: Es crucial enfatizar que la medición biométrica es una dirección futura prometedora para validar empíricamente el marco teórico propuesto, no el núcleo del marco mismo. El núcleo es la integración conceptual de pensamiento de futuro con evaluación decisional. Los biométricos ofrecen una ventana única a procesos cognitivo-emocionales que de otro modo permanecen ocultos, pero son un medio metodológico, no el fin. El marco puede y debe desarrollarse, enseñarse y evaluarse con métodos convencionales (simulaciones comportamentales, portfolios reflexivos, entrevistas cognitivas) mientras se explora en paralelo el potencial de medidas fisiológicas.

Contextos de Aplicación y Generalización

Futuros estudios deberían validar el marco en diversos contextos educativos para evaluar generalización:

- Educación superior: Programas de grado y posgrado en múltiples disciplinas (ingeniería, ciencias sociales, negocios, salud)

- Educación secundaria: Currículos de pensamiento crítico y ciudadanía en escuelas

- Formación profesional continua: Programas de desarrollo de liderazgo, decision-making para ejecutivos

- Contextos latinoamericanos: Especial atención a validar en poblaciones hispanohablantes y contextos socioeconómicos diversos

La investigación cross-cultural es esencial. ¿Las dimensiones del marco son universales o culturalmente específicas? Por ejemplo, la orientación temporal (presente vs. futuro) varía significativamente entre culturas (Zimbardo & Boyd, 1999). Competencias prospectivo-decisionales pueden manifestarse diferentemente en culturas colectivistas vs. individualistas, o en sociedades con alta vs. baja tolerancia a la incertidumbre (Hofstede, 2001).

Conclusiones

Nos encontramos en un punto de inflexión histórico en el que los métodos tradicionales de enseñanza y evaluación ya no bastan para preparar a las personas para un futuro incierto y complejo. Este artículo ha argumentado que integrar el pensamiento de futuro con la evaluación decisional ofrece un camino innovador y necesario para enfrentar este desafío. El marco teórico propuesto, fundamentado en el Futures Literacy Framework de UNESCO (Miller, 2018), la ciencia de la decisión (Kahneman, 2011; Gigerenzer & Gaissmaier, 2011; Kahneman & Klein, 2009), y avances en evaluación auténtica (Shute & Ventura, 2013; Rahimi & Shute, 2024), nos permite evaluar competencias de forma más auténtica mientras fomentamos simultáneamente el desarrollo de las habilidades que realmente importan en el siglo XXI.

La síntesis teórica propuesta no es una mera yuxtaposición de conceptos, sino una integración genuina que genera competencias emergentes: recursividad temporal en la toma de decisiones, responsabilidad prospectiva y ética anticipatoria, gestión sistémica de la incertidumbre, pensamiento interdisciplinario complejo, y metacognición adaptativa (Ramírez-Montoya et al., 2023, 2025). Estas capacidades son precisamente las que organismos internacionales como UNESCO y OCDE identifican como críticas para navegar futuros volátiles, inciertos, complejos y ambiguos (UNESCO, 2024; OECD, 2019).

Las evidencias empíricas revisadas—aunque preliminares—son prometedoras. Estudios longitudinales muestran que pedagogías integradoras desarrollan narrativas más sofisticadas sobre tecnología y agencia (Ramírez-Montoya et al., 2025). Investigaciones cuasi-experimentales demuestran que alfabetización en futuros es enseñable y medible (Bol & de Wolf, 2023; Kazemier et al., 2022). Evaluaciones mediante juegos serios y simulaciones validan que competencia decisional puede inferirse de comportamiento con precisión psicométrica (Lu et al., 2025; Shute & Wang, 2016). Estudios correlacionales confirman que pensamiento crítico cataliza desarrollo de competencias prospectivas (Talamás-Carvajal et al., 2024). En conjunto, esta evidencia sugiere que el marco integrado es viable, válido y valioso.

Para los académicos y tomadores de decisión, adoptar este enfoque no es solo una mejora técnica, sino un cambio de paradigma que relaciona profundamente disciplinas y propósitos. Significa conectar la evaluación con la investigación de vanguardia en ciencias cognitivas, psicología de la decisión y prospectiva; significa orientar la educación hacia la construcción activa de futuros deseables, en lugar de la reacción pasiva al cambio; significa, en última instancia, alinear la formación de talentos con las necesidades de un mundo que demanda adaptabilidad, creatividad y responsabilidad intergeneracional.

Agenda de Investigación Colaborativa

Este marco teórico es, por diseño, una invitación abierta a la comunidad académica internacional. Su validación completa requiere esfuerzos colaborativos de múltiples grupos de investigación con diferentes expertises: especialistas en futures studies que aporten rigor en prospectiva; psicólogos de la decisión que contribuyan instrumentos de medición validados; diseñadores de aprendizaje que creen simulaciones auténticas; neurocientíficos educativos que exploren correlatos fisiológicos; expertos en learning analytics que desarrollen algoritmos predictivos; y pedagogos que implementen en aulas reales y documenten procesos.

Las direcciones metodológicas futuras esbozadas—estudios longitudinales mixtos, desarrollo de instrumentos psicométricos, evaluaciones mediante simulaciones, y exploración de datos biométricos—constituyen un programa de investigación ambicioso pero alcanzable. Cada componente puede abordarse independientemente por diferentes equipos, mientras se construye colectivamente un corpus de evidencia convergente. Llamamos específicamente a:

- Grupos en futures studies a colaborar en refinamiento conceptual de la integración y desarrollo de metodologías de enseñanza de pensamiento prospectivo decisional.

- Expertos en evaluación educativa a diseñar y validar instrumentos que midan competencia decisional prospectiva como constructo integrado.

- Desarrolladores de tecnología educativa a crear plataformas de simulación y analíticas que implementen Evidence-Centered Design para evaluación sigilosa.

- Investigadores en neurociencia educativa a explorar la viabilidad y validez de marcadores fisiológicos en contextos educativos auténticos.